チャットAI「StableLM」発表 オープンソースモデルで商用可 「Stable Diffusion」開発元から

英Stability AIは4月19日(英国時間)、オープンソースの大規模言語モデル「StableLM」を発表した。α版として30億と70億パラメータの2モデルを公開。今後150億パラメータから650億パラメータのモデルも公開予定としている。ライセンスはCC BY-SA-4.0で、商用や研究目的で自由に利用できるとしている。

現状で対応しているのは英語のみ。できることとしてはチャット、フォーマルな文書作成、創作、プログラミングコードの提示などを例に挙げている。

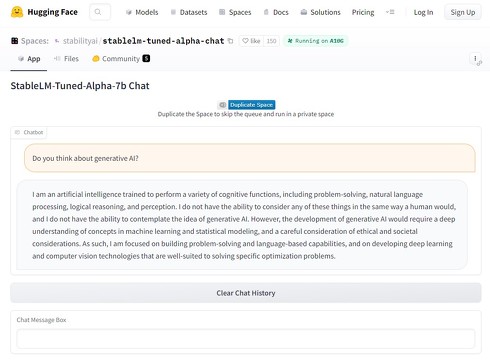

サービスではなくローカルで実行可能なモデルとして公開しているが、AI関連のコミュニティーWebサイト「HuggingFace」上でチャットを試すこともできる。

ローカル実行環境の要件について言及は見つからないが、米Googleの機械学習向けクラウド実行環境「Google Colaboratory」で実行できるサンプルも用意されていることから、個人で用意できる程度のローカル環境でも実行はできそうだ。

また、他の大規模言語モデル(Alpaca、GPT4All、Dolly、ShareGPT、HH)を使ってベースモデルを追加学習させたモデルもあわせて公開。ただし、これらのモデルは研究用のみの用途に限られるライセンスとなることから、追加学習させたモデルについては非営利のCC BY-NC-SA 4.0ライセンスでの公開となる。

今回公開したモデルは、非営利のAI研究組織「EleutherAI」と共同で研究した経験に基づいて開発したものという。共同研究では「GPT-J」「GPT-NeoX」といった大規模言語モデルの他に、大規模言語モデルの分析ツールも手掛けていた。

GPT-Jなどの訓練には5000億トークンのオープンソースデータセット「The Pile」を使っていたが、今回のStableLMの訓練にはThe Pileをベースにしつつもその3倍となる1.5兆トークンの新たなデータセットを使用。これにより、パラメータが30億や70億という比較的小さなサイズ(米OpenAIのGPT-3は1750億)にもかかわらず高い性能を発揮するとしている。今後、650億パラメータまでのモデルを公開すべく作業中としているが、計画には1750億パラメータのモデルも挙がっている。

なお、人間のテストや機械学習向けのベンチマークでの性能比較の結果は公開していない。同社は近く、完全な技術レポートを公開するとしている。

関連記事

「GPT-4」発表 日本語でもChatGPT英語版より高性能、司法試験で上位10%、「この画像何が面白いの?」にも回答

「GPT-4」発表 日本語でもChatGPT英語版より高性能、司法試験で上位10%、「この画像何が面白いの?」にも回答

大規模言語モデル「GPT-4」が登場。テキストでのやり取りだけでなく、ユーザーから画像も受け取れるようになった。司法試験の模擬問題を解かせると上位10%のスコアで合格する。ChatGPTの有料版やAPI経由でこれから利用可能になる。 イーロン・マスクがAIの開発表明 名前は「TruthGPT」

イーロン・マスクがAIの開発表明 名前は「TruthGPT」

イーロン・マスク氏が新しいAI「TruthGPT」(トゥルースGPT)の開発を表明した。「宇宙と自然を理解しようとするAIになる」という。 みんなどのくらいChatGPTに課金してるの? 読者調査結果

みんなどのくらいChatGPTに課金してるの? 読者調査結果

話題沸騰のChatGPTだが、実はどのくらいのユーザーが使っているのだろうか。また、月額20ドルの有料版への課金率はどのくらいなのか。技術への造詣が深く、AIへの関心も高いと想像される、ITmedia NEWSの読者に対してTwitterでアンケートをとってみた。 話題の画像生成AI「Stable Diffusion」、ビジネスモデルは? 企業の利用状況は? 日本法人代表にいろいろ聞いてみた

話題の画像生成AI「Stable Diffusion」、ビジネスモデルは? 企業の利用状況は? 日本法人代表にいろいろ聞いてみた

画像生成AI「Stable Diffusion」開発元の日本法人代表ジェリー・チーさんに、企業での利用状況やビジネスモデル、クリエイターからの反応などについて、いろいろと聞いてみた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR