大規模言語モデルは相関関係から“本当の”因果関係を推定できるのか? 40万個の問題で研究者らが調査:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。Twitter: @shiropen2

ドイツのMPI-IS、スイスのETH Zurich、米ミシガン大学、香港大学、米Meta AIに所属する研究者らが発表した論文「Can Large Language Models Infer Causation from Correlation?」は、大規模言語モデル(LLM)が相関関係から因果関係を推定する因果推論タスクでどの程度の性能を発揮できるかを調査した研究報告である。

推論の基本的な考え方では、因果関係を得るために2つの方法がある。1つは、経験的な知識に基づくものだ。例えば、誕生日パーティーを友人のために準備すると、幸せになるということは常識的に知られている。

もう1つは、既知の手順やルールを用いて因果関係を推論する純粋な因果推論だ。前者の場合は、過去の事例を学習データとして活用することで、経験的な知識に基づいた推定が可能だろう。しかし、後者の純粋な因果推論によって因果関係を推論することは可能だろうか。

この研究の動機の一つは、後者の因果推論がLLMにとって必要不可欠であることだ。例えば、「ワクチン」という単語が病気の患者数の変動と相関しているような相関関係がたくさん存在するが、必ずしも因果関係があるとはいえない。

LLMの成功は、用語間の膨大な統計的相関を捕らえることにあるという立場を取るなら、重要だが欠けているステップは、このような相関を処理して因果関係を推測する方法となる。そのため、LLMの精度向上のためには、因果推論能力の向上が必要となる可能性がある。

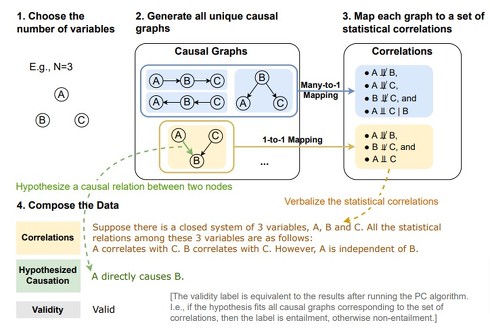

研究チームは、LLMの因果推論能力を評価するために、40万の因果推論問題データセット「Corr2Cause」を作成した。このデータセットでは、相関関係と因果関係をペアとしてラベル付けしており、因果推論の概念に基づいた有効性や無効性などを記述したデータが含まれる。

対象となる変数の数やその相関関係から複数のノードを持つ因果グラフを生成し、DGCMやD-Separation、MECなどの因果推論の概念が適用されている。

Corr2Causeデータセットを利用して、既存のLLMが因果推論タスクにおいてどの程度の性能を示すのか、また、既存のLLMをテストデータで微調整(Fine-tuning)することで、頑健な因果推論スキルを獲得することが可能かを調査する。

実験では、AlpacaやGPT-4などの最新含む17種類のLLMモデル(GPTベース、BERTベース、LLaMaベースなど)を使用し、Corr2Causeデータセットでテストした。その結果、全てのモデルにおいて因果推論タスクがうまく機能しないことが示された。各LLMの結果を見ると、F1スコアにおいて、BART MNLIが最も高く、次いでGPT-4やAlpaca-6.7Bなどが続いたが、全体的に精度が低い結果となった。

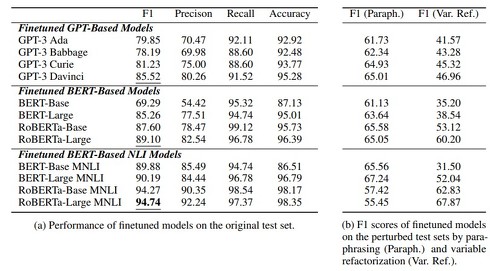

次に、LLMをデータ上で微調整することで因果推論タスクの精度がどのように変化するかを調査した。その結果、ほとんどのモデルが微調整により大幅に改善された。特にBERTベースのNLIモデルが最も強力な性能を示した。「RoBERTa-Large MNLI」はこのタスクで94.74%のF1スコアと非常に高い精度を示した。

しかし、研究者たちはモデルが本当に因果推論スキルを頑健に学習したのか疑問を抱き、問題の言い換えや変数名のアルファベットの逆転などのリファクタライズを行い、頑健性テストを行った。

その結果、テストセットを言い換えた場合、全てのモデルが最大39.29%低下し、変数名をリファクタリングした場合は最大58.38%低下することが分かった。最も優れたモデルである「RoBERTa-Large MNLI」は、言い換えに特に敏感であり、全モデルの中で最も低下した。

これらの結果から、微調整によって良好な性能が得られることは分かったが、LLMが獲得する因果推論スキルは頑健ではないことが示された。

Source and Image Credits: Jin, Zhijing, Jia-Rou Liu, Zhiheng Lyu, Spencer Poff, Mrinmaya Sachan, Rada Mihalcea, Mona Diab and Bernhard Scholkopf. “Can Large Language Models Infer Causation from Correlation?”(2023).

関連記事

「社内のアレ分からん、教えてAI」実現 Microsoftの“自社版ChatGPT作成サービス”にデータ取り込み機能

「社内のアレ分からん、教えてAI」実現 Microsoftの“自社版ChatGPT作成サービス”にデータ取り込み機能

米Microsoftが、「Azure OpenAI Service」に新機能「On Your Data」を追加。ユーザーがローカルやAzure上のストレージに保管するテキストファイルやPDF、PowerPointファイルをチャットAIに参照させられるという。 生成AIに“生成AIが作った文章”を学習させ続けるとどうなる? 「役立たずになる」と英国チームが報告

生成AIに“生成AIが作った文章”を学習させ続けるとどうなる? 「役立たずになる」と英国チームが報告

英オックスフォード大学や英ケンブリッジ大学、英インペリアル・カレッジ・ロンドン、米トロント大学に所属する研究者らは、GPT-4などの大規模言語モデル(LLM)が別のLLMが生成したテキストを学習し続けるとどうなるかを調査した研究報告を発表した。 草津温泉、AIフル活用のPR動画を公開 「本物との違いをお楽しみいただけたら」

草津温泉、AIフル活用のPR動画を公開 「本物との違いをお楽しみいただけたら」

草津温泉観光協会は19日、ChatGPTなどのAIを活用して制作した観光PR動画をYouTubeで公開したと発表した。 「自社版ChatGPT」をグループ全社導入 約1万5000人で2カ月使った手応えは? ベネッセに聞いた

「自社版ChatGPT」をグループ全社導入 約1万5000人で2カ月使った手応えは? ベネッセに聞いた

「自社版ChatGPT」をグループ全社に導入したベネッセ。導入から2カ月余り、現状の手応えをキーパーソンに聞いた。 「ChatGPT」に関する報道発表、5カ月で32倍に 「AI」の月間発表数は12位→3位に

「ChatGPT」に関する報道発表、5カ月で32倍に 「AI」の月間発表数は12位→3位に

PR TIMESは、2023年に入ってから、「AI」「ChatGPT」をキーワードとする企業の発表が急増していると発表した。月間キーワードランキングでは「AI」が徐々に順位を上げ、月間プレスリリース数では、「ChatGPT」が1月から5月で約32倍に増加した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR