東大松尾研、日英対応の大規模言語モデル公開 100億パラメータ、精度は「国内オープンソース最高水準」

東京大学院工学系研究科・松尾研究室(主宰:松尾豊教授)は8月18日、日英の2カ国語に対応した100億パラメータサイズの大規模言語モデル(LLM)「Weblab-10B」を、事前学習と事後学習(ファインチューニング)により開発し、非商用ライセンスでモデルを無料公開した。

【修正履歴:2023年8月18日午後9時 当初、モデルの公開形式をオープンソースと記載していましたが、ソースコードが公開されていないなどオープンソースの定義に沿わないと思われる部分があるため記述を改めました。なお、引用部分についてはそのままにしています】

日本語だけでなく英語のデータセットも学習に用いることで学習データ量を拡張し、言語間の知識転移を行うことで日本語の精度を高めたのが特徴。

事前学習には、代表的な英語のデータセット「The Pile」と日本語のデータセット「Japanese-mC4」を使用。事後学習には、Alpaca(英語)、Alpaca(日本語訳)、Flan 2021(英語)、Flan CoT(英語)、Flan Dialog(英語)を使った。

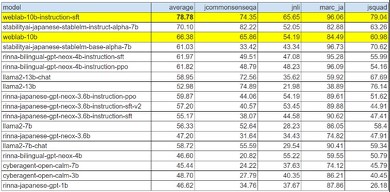

事後学習の日本語データ比率は低いが、日本語のベンチマークである「JGLUE」評価値は事前学習時より大幅に改善(66%→78%)し、言語間の知識転移を確認した。この精度は「国内オープンソースモデルとしては最高水準」という。

近年のLLMは、インターネットから収集した大量のテキストデータを学習に用いるが、英語などのデータが多く、日本語は限られている。そこで松尾研は、日本語に加え、0英語のデータセットも学習に用いることで学習データ量を拡張し、日本語の精度を高めることに成功した。

「Weblab-10B」という名前には、Web工学の研究から始まった松尾研が立ち上げ当初から長く使用してきたドメイン「https://weblab.t.u-tokyo.ac.jp/」名と、100億パラメータ(10 Billion)などの意味を込めた。

今後、「世界と伍する事のできるさらに大きな日本発のLLM開発に挑戦するという。LLMの産業実装に向けた研究も進めていく。人材も募集しており、「大規模言語モデルの開発に強い意思と情熱を持っている方」を求めている。

関連記事

岸田首相、東大松尾研でAI学ぶ 夏休みを利用し業界動向を聞く

岸田首相、東大松尾研でAI学ぶ 夏休みを利用し業界動向を聞く

岸田文雄内閣総理大臣は、東京大学松尾研究室で大規模言語モデルの特別講座を受講した。夏休みを利用して生成AI業界の動向を学んだという。 Stability AI Japan、日本語言語モデル「Japanese StableLM Alpha」公開 他社上回る性能、商用利用も可能

Stability AI Japan、日本語言語モデル「Japanese StableLM Alpha」公開 他社上回る性能、商用利用も可能

英Stability AIの日本法人であるStability AI Japanは、日本語向け大規模言語モデル(LLM)「Japanese StableLM Base Alpha 7B」を公開した。パラメータは70億。ライセンスはApache License 2.0で、商用利用可能だ。 「りんな」開発元、大規模言語モデルを公開 36億パラメーターで日本語特化

「りんな」開発元、大規模言語モデルを公開 36億パラメーターで日本語特化

コミュニケーションAI「りんな」を提供するrinnaが、GPTベースの大規模言語モデルをオープンソースで公開した。日本語に特化した36億パラメーターを持つ汎用言語モデルと、対話言語モデルの2種類を用意する。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR