なぜ日本はGPUのない「富岳」でLLMを研究するのか 外国に後れを取らないための“現実的な理由”(2/2 ページ)

GPUスパコンがあるのに非GPUスパコンの富岳を使う意味

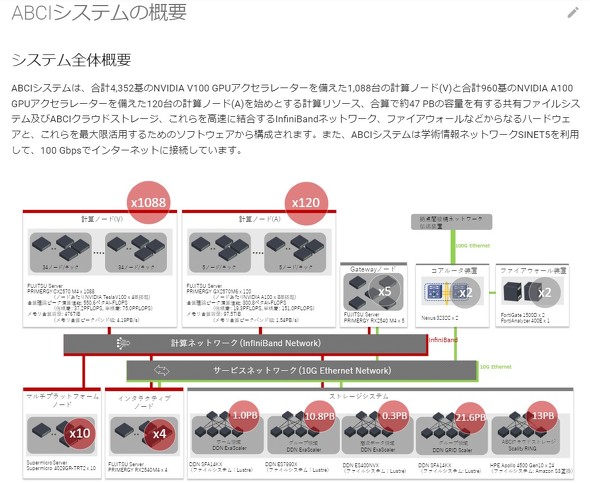

一方で、1000垓規模の計算をするにあたっては、富岳以外の選択肢もある。一般的に深層学習に向いているとされるGPUを搭載したスーパーコンピュータとしては、産業技術総合研究所が構築・運用する「ABCIシステム」が日本最大とされてきた。搭載されているGPUの計算処理性能も富岳のCPUを超えている。

富士通研究所の白幡さんによると、ABCIシステムを完全に貸し切って10日ほど計算させれば、1000垓規模の計算をすることも「技術的には可能」(白幡さん)という。

しかし、現実的にはそうもいかない。ABCIシステムはさまざまな組織が共用しているものであり、長時間貸切ることが難しい。性能は高いが占有できないという“現実”がハードルになっている。

対して富岳は、各CPUの処理性能を見るとABCIシステムのGPUの17.75分の1程度。しかし、現実的に使えるリソースの規模を考慮すると1000垓規模の計算を実現できるのは日本で富岳だけになるという。

この1年を無駄にしないための富岳 「勝負の年」

LLMの研究分野は非常に流れが速く、短期間でどんどん更新されてしまう。それも富岳でLLMを研究する意味の一つという。

「24年度以降になれば、また使えるサービスも増えてくるため、それも活用するべきだと思うが、それは未来の話。LLMの研究は半年前と今では状況が全く違う。1年間放っておくわけにはいかない。23年度がある意味勝負と考えている。23年度でどこまでできるかが24年度につながっていく」(白幡さん)

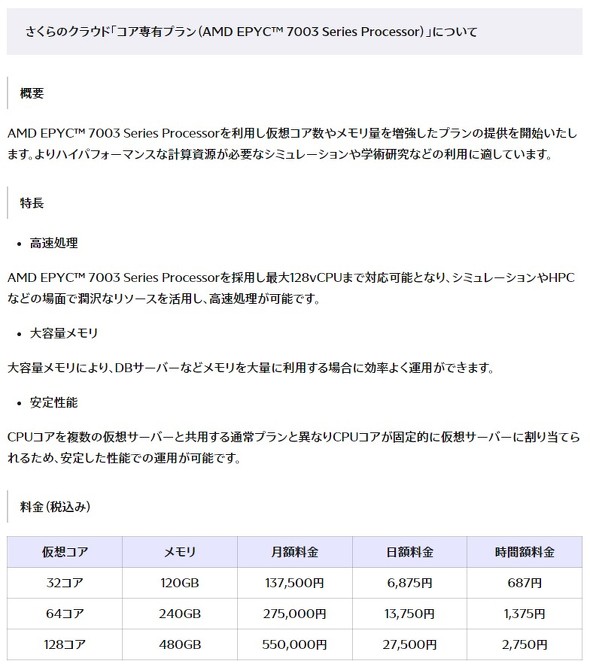

今はさくらインターネットが8月上旬にクラウドサービス「さくらのクラウド」で、AI開発・研究向けの新プラン「コア専有プラン(AMD EPYC 7003 Series Processor)」を公開している。同社はGPUクラウドサービスへの投資計画を前倒しで進めるとも発表しており、24年度には確かにLLM研究基盤がさらに充実しそうだ。

しかし、それを待っていてはその間に諸外国と差をつけられてしまうかもしれない。その穴を埋めてくれるのが富岳なのだ。

研究チームは計算処理の高速化をはじめ、学習方法を模索していく。開発したLLMは最終的にGitHubやHugging Faceで公開するが、モデルの制作が最終目標なのではない。学習ノウハウという基盤を作ることが目標といえる。それがさくらインターネットなどが公開していく計算資源を上手に使うときにも役立っていくかもしれない。

関連記事

「富岳」で大規模言語モデル開発へ 分散並列学習法を研究 成果はGitHubなどで公開予定

「富岳」で大規模言語モデル開発へ 分散並列学習法を研究 成果はGitHubなどで公開予定

理化学研究所と富士通、東京工業大学、東北大学が、スーパーコンピュータ「富岳」で大規模言語モデルの分散並列学習手法の研究を始める。 気象庁、線状降水帯の予測に「富岳」をフル活用 全国の気象をリアルタイムにシミュレート

気象庁、線状降水帯の予測に「富岳」をフル活用 全国の気象をリアルタイムにシミュレート

気象庁が線状降水帯の予測精度向上のため、気象レーダーやアメダス、スーパーコンピュータなどの強化、「富岳」を活用したより詳細な予報技術の開発を進めると発表した。 さくらのクラウド、AI意識の新プラン 仮想コア数・メモリ“マシマシ”

さくらのクラウド、AI意識の新プラン 仮想コア数・メモリ“マシマシ”

さくらインターネットが、クラウドサービス「さくらのクラウド」の新プランを発表。AIの開発や学術研究など、ハイパフォーマンスな計算資源が必要な用途での利用を見込むという。 さくらインターネット、GPUクラウド強化を前倒し 生成AI意識

さくらインターネット、GPUクラウド強化を前倒し 生成AI意識

さくらインターネットが、6月に発表したGPUクラウドサービスへの投資計画を前倒しで進めると発表。2024年に78億5000万円を投じると決めた。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR