なぜ日本はGPUのない「富岳」でLLMを研究するのか 外国に後れを取らないための“現実的な理由”(1/2 ページ)

米OpenAIの大規模言語モデル(LLM)・GPT-4は今、世界を大きく塗り替え続けている技術の一つだ。世界各国の企業がこぞってLLMの開発を進めている。特にGAFAなどの巨大企業は、その膨大な資源を使ってすでにいくつものLLMを世に放っている。

そんな中、日本では理化学研究所と富士通、東京工業大学、東北大学が、スーパーコンピュータ「富岳」を使ったLLMの研究を今まさに進めている。学習手法の研究からデータの法的な扱いまで幅広く検討し、日本のLLM開発の基盤を作るのが目的だ。

深層学習といえば、今ではGPUを使うのが一般的になっている。しかし富岳はそのGPUを搭載していない。日本にはGPU搭載スパコンも存在するのに、なぜ富岳を使ってLLMを研究するのか。

今回は富士通研究所・コンピューティング研究所の中島耕太所長と白幡晃一さんに、富岳を使ったLLM研究について、その意義を聞いた。富岳は確かにハイスペックなスーパーコンピュータだ。しかし、LLM研究における活用には、それだけでないもっと“現実的な理由”があった。

やりたいのは10の23乗規模の計算 それができるのは?

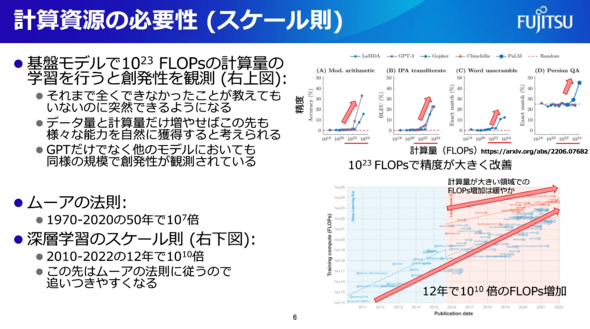

LLMの学習には大量の計算が必要になる。では、具体的には何回以上計算すればいいのか。これには一つの答えがあるという。

その数字が「10の23乗FLOPs」だ。富岳をはじめとするスーパーコンピュータの性能を示すとき「このスパコンの計算速度は○○FLOPsです」のようにいうことがあるが、今回の「FLOPs」は計算速度ではなく計算量を示す単位のこと。平易に書くなら「10の23乗回」となる。10の23乗は日本語でいうと「1000垓」。1兆の1000億倍のことだ。

中島さんによると、過去の研究の中でLLMには不思議な性質が見つかっているという。LLMの学習を進めていると、しばらくはあまり派手な性能向上が見られないのだが、ある時点でなぜか急に能力が跳ね上がり、それまでできていなかったような処理をできるようになる──それが10の23乗FLOPsだ。

つまり、LLMを開発するならスーパーコンピュータに1000垓回分の計算をさせることが一つの目標になる。

「この“急に”ということはある程度重要で、小さな計算量では意味がないということを逆に示している。米OpenAIのLLMのパラメーター数を見てみると、これまでにずいぶんと増えている。賢さを得るために相当に計算量を増やしているのは間違いない」(中島さん)

関連記事

「富岳」で大規模言語モデル開発へ 分散並列学習法を研究 成果はGitHubなどで公開予定

「富岳」で大規模言語モデル開発へ 分散並列学習法を研究 成果はGitHubなどで公開予定

理化学研究所と富士通、東京工業大学、東北大学が、スーパーコンピュータ「富岳」で大規模言語モデルの分散並列学習手法の研究を始める。 気象庁、線状降水帯の予測に「富岳」をフル活用 全国の気象をリアルタイムにシミュレート

気象庁、線状降水帯の予測に「富岳」をフル活用 全国の気象をリアルタイムにシミュレート

気象庁が線状降水帯の予測精度向上のため、気象レーダーやアメダス、スーパーコンピュータなどの強化、「富岳」を活用したより詳細な予報技術の開発を進めると発表した。 さくらのクラウド、AI意識の新プラン 仮想コア数・メモリ“マシマシ”

さくらのクラウド、AI意識の新プラン 仮想コア数・メモリ“マシマシ”

さくらインターネットが、クラウドサービス「さくらのクラウド」の新プランを発表。AIの開発や学術研究など、ハイパフォーマンスな計算資源が必要な用途での利用を見込むという。 さくらインターネット、GPUクラウド強化を前倒し 生成AI意識

さくらインターネット、GPUクラウド強化を前倒し 生成AI意識

さくらインターネットが、6月に発表したGPUクラウドサービスへの投資計画を前倒しで進めると発表。2024年に78億5000万円を投じると決めた。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR