好みのチャットbotを短い文章で作れるツール「Prompt2Model」 米カーネギーメロン大などが開発:Innovative Tech

Innovative Tech:

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Twitter: @shiropen2

米カーネギーメロン大学や中国の清華大学に所属する研究者らが発表した論文「Prompt2Model: Generating Deployable Models from Natural Language Instructions」は、短い文章(プロンプト)だけから、自然言語処理(NLP)モデルを自動で作り出すフレームワークを提案した研究報告である。

従来、NLPモデルの構築は非常に煩雑な作業であった。それは、対象とする課題(タスク)を定義し、適切なデータを収集し、モデルのアーキテクチャを選定し、訓練や評価を行い、実世界で使用できるようにデプロイするという一連の手続きを必要としたからである。

しかし、GPT-3などの大規模言語モデル(LLM)の登場により、プログラムコードを一行も書かずに試作モデルを短時間で作成できるようになった。その一方で、膨大な計算リソースまたは商用APIへのアクセスが必要であり、入力プロンプトの品質に依存するため、訓練済みモデルに比べて不安定である。またプライバシーの懸念も残る。

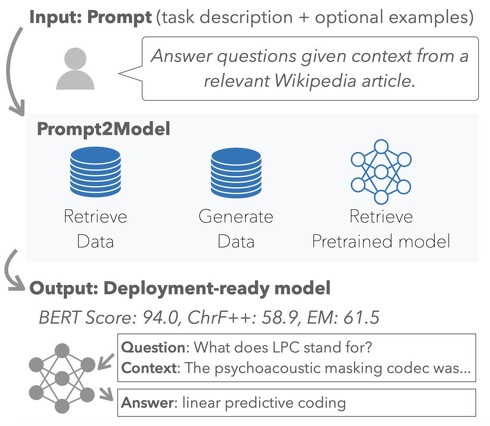

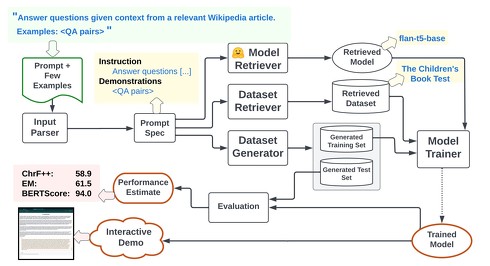

提案されたフレームワーク「Prompt2Model」はこれらの課題を解決する。短いプロンプトに基づき、データ収集からモデルの選定や微調整、評価に至るまでを自動化し、特定のタスクに適した小規模なモデルを生成する。

具体的には、プロンプトに応じたタスクに関連する既存のデータを集める。教師モデルとしてLLMを用い、疑似ラベルが付与された新しいデータセットを生成する。プロンプトに基づいて、事前に訓練された適切なモデル(生徒モデル)を選び、それを生成したデータセットで微調整および評価を行う。

このようにPrompt2Modelは、プロンプト一つで必要なデータを集め、適切なモデルを選び、訓練、評価まで行ってくれるわけだ。これにより、短い時間と少ない労力で特定のタスクに強い軽量なNLPモデルを作成できる。またこのフレームワークは拡張性が高く、新しいデータ収集手法やモデル訓練のアプローチを試す研究にも利用可能だ。

Source and Image Credits: Viswanathan, Vijay, Chenyang Zhao, Amanda Bertsch, Tongshuang Wu, and Graham Neubig. “Prompt2Model: Generating Deployable Models from Natural Language Instructions.” arXiv preprint arXiv:2308.12261(2023).

関連記事

「自社製品にチャットAIを組み込みたい」 企業が取るべきセキュリティ対策とは? “プロンプトインジェクション”の基本手口

「自社製品にチャットAIを組み込みたい」 企業が取るべきセキュリティ対策とは? “プロンプトインジェクション”の基本手口

ChatGPTの登場から、チャットAIをサービスに組み込んで提供する企業が増えてきた。一方、「プロンプトインジェクション」などチャットAIを狙う攻撃手法も考えられている。企業はどんなセキュリティ対策を取るべきか、NRIセキュアテクノロジーズが解説する。 Robloxの生成AIチャットbot「Roblox Assistant」で仮想世界構築

Robloxの生成AIチャットbot「Roblox Assistant」で仮想世界構築

ゲーム作成・共有プラットフォーム「Roblox」は、プロンプト入力で仮想環境を生成できるAIチャットbot「Roblox Assistant」を発表した。また、アバターを写真とプロンプトで生成するAIツールも発表した。 アニメキャラの口調や性格をまねるチャットbot「ChatHaruhi」 中国チームが開発

アニメキャラの口調や性格をまねるチャットbot「ChatHaruhi」 中国チームが開発

中国のSenseTimeや浙江大学などに所属する研究者らは、大規模言語モデル(LLM)を用いて特定のアニメやテレビキャラクターの性格を模倣するチャットbotを構築するシステムを提案した研究報告を発表した。 「マルウェア入り画像」で生成AIにサイバー攻撃 入力すると回答結果をハック、悪意サイトへの誘導も

「マルウェア入り画像」で生成AIにサイバー攻撃 入力すると回答結果をハック、悪意サイトへの誘導も

米Cornell Techに所属する研究者らは、画像や音声に悪意あるプロンプトを含ませたプロンプト・インジェクション(生成AIに対しての攻撃)を提案した研究報告を発表した。 AIチャットbotのPKSHA、14億円の特損 原因は「信託型SO」

AIチャットbotのPKSHA、14億円の特損 原因は「信託型SO」

AIチャットbotなどを提供するPKSHA Technology(パークシャテクノロジー)が、2023年9月期第3四半期(4〜6月)に14億6654万4000円の特別損失を計上したと発表した。原因は「信託型ストックオプション」(信託型SO)だ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR