NECの大規模言語モデルが一般初公開 現地の様子は:CEATEC 2023

NECの自社製大規模言語モデル(LLM)が、テクノロジー展示会「CEATEC 2023」(10月17〜20日、幕張メッセ)で初の一般公開となった。会場ではChatGPTのように使える利用環境「NEC Generative AI Framework」での動作を披露。会場から2時間程度たった正午ごろには、ブースに十数人程度の人だかりができる様子も見られた。

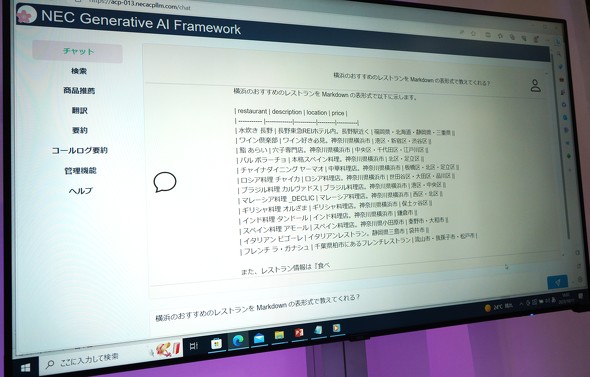

現地では、デモとして質問文にAIがテキストで返答する様子を公開。例えば「横浜のおすすめのレストランをMarkdownの表形式で教えてくれる?」という質問には、以下のように回答していた。返答にかかった時間は十数秒程度だった。

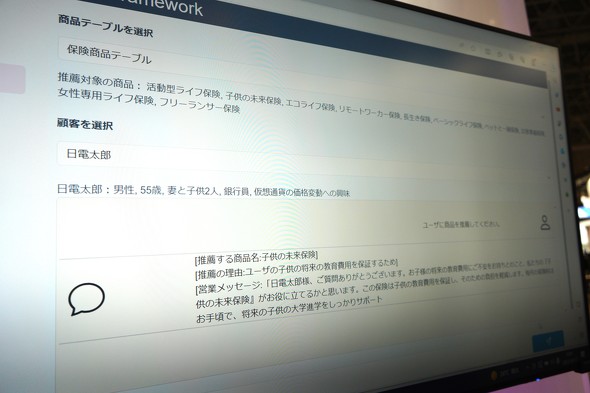

さらに「AIで保険の営業を支援する」というシチュエーションのデモも。紹介する保険商品の種別や、性別や年齢といった顧客の属性情報を入力すると、最初に紹介すべきプランを出力した。返答にかかった時間は同じく十数秒程度だった。

コンパクトさ武器に NECのLLM、特徴は

NECのLLMは、GPU928基・580PFLOPSの演算能力を備えたAIスーパーコンピュータを1カ月稼働して構築しており「世界トップクラスの日本語処理能力」をうたう。

パラメーター数は130億で、1750億の「GPT-3」や700億の「Llama2」などに比べると軽量だ。ただし、LLMはパラメーター数を増やすと、推論速度が低下しモデル運用に必要なGPUの数と消費電力が増える傾向にある。NECも「大ボリュームで高性能」ではなく、安さと精度の両立など、コンパクトさや取り回しの良さを強調している。

提供形態も複数用意。オンプレミスやNECのデータセンター、米Microsoftのクラウドサービス「Microsoft Azure」上で運用可能という。

併用も視野? 「Azure OpenAI Service」との差別化は

とはいえ、同様のサービスにはすでに競合がいる。「GPT-4」などのAPIをMicrosoft Azure経由で使える「Azure OpenAI Service」だ。すでに三井不動産やベネッセホールディングス、ソフトバンクなど、さまざまな企業が同サービスを使い、情報が外部に提供される心配なく生成AIを使える環境を整備している。まさしく強力な先行他社といえるだろう。

ただしNECは、Azure OpenAI Serviceなどの先行サービスと自社のAIサービスを対抗させるのではなく、併用・使い分けさせる考えだ。エバンジェリストの石川和也さんによれば、NECのLLMは日本語に強く、さらにオンプレミスで運用できるとして、個社ごとのカスタマイズを前提に「専門性・秘匿性の高い情報の処理はNECのサービスに、汎用的な情報の処理はAzure OpenAI Serviceに」といった利用形態を見込んでいるという。

そもそもNEC自身もAzure OpenAI Serviceと自社製LLMを利用した生成AIの利用環境を導入している。さらにAzure OpenAI Serviceの導入支援も手掛けているので、顧客の事情に合わせ柔軟に双方を提案する方針だ。さらなる選択肢として、パラメーター数が異なるLLMの開発も検討中という。

まずは製造・金融などターゲットに

石川さんによれば、NECはすでに10法人程度に自社製LLMを先行提供しており、今後は製造・金融など特定の業界向けに展開する方針という。当面はもちろん日本市場で展開するが、詳細な目標については回答を控えた。

なお、来場者からは「LLMとはそもそも何か、何ができるか、という粒度の問い合わせが多く、深く知られている方はあまりいなかった」と石川さん。中には1社での利用に特化した“マイLLM”の可能性についても聞かれることもあったというが、今回の展示については「直接商談につなげるというよりは、そもそもこの技術で何ができるのか、理解してもらえればと考えている」とした。

関連記事

三井住友海上、生成AIを全社員に 「Azure OpenAI Service」活用

三井住友海上、生成AIを全社員に 「Azure OpenAI Service」活用

三井住友海上火災保険が生成AIチャットを全社員で活用。「Azure OpenAI Service」を利用して環境構築した。 住信SBI銀、銀行業務にChatGPTなどLLMを活用する実証実験

住信SBI銀、銀行業務にChatGPTなどLLMを活用する実証実験

住信SBIネット銀行は6月19日、銀行業務においてChatGPTなどの大規模言語モデル(LLM)を活用する実証実験を行うと発表した。社内において、各専門部署への問い合わせや、書類作成、分析資料作成といった業務を行える社内ボットへの応用を検討する。 マイクロソフトの“ChatGPT基盤”、政府認定サービス入りか 早ければ8月末

マイクロソフトの“ChatGPT基盤”、政府認定サービス入りか 早ければ8月末

日本マイクロソフトは、「Azure OpenAI Service」を、政府のクラウドサービス認定制度「ISMAP」に登録する方針だ。早ければ8月末にもISMAPのリストに入る見込みという。 NEC、独自の日本語大規模言語モデルを開発 パラメータ数130億、クラウドで運用可能 性能も世界トップクラス

NEC、独自の日本語大規模言語モデルを開発 パラメータ数130億、クラウドで運用可能 性能も世界トップクラス

NECは、独自の日本語大規模言語モデル(LLM)を開発したと発表した。パラメータ数は130億で、クラウド/オンプレミス環境での運用も可能。性能面でも、世界トップクラスの日本語能力を実現しているという。 「自社版ChatGPT」をグループ全社導入 約1万5000人で2カ月使った手応えは? ベネッセに聞いた

「自社版ChatGPT」をグループ全社導入 約1万5000人で2カ月使った手応えは? ベネッセに聞いた

「自社版ChatGPT」をグループ全社に導入したベネッセ。導入から2カ月余り、現状の手応えをキーパーソンに聞いた。 IIJ、Microsoftの“自社版ChatGPT”導入支援を開始 初期費用150万円から

IIJ、Microsoftの“自社版ChatGPT”導入支援を開始 初期費用150万円から

IIJが、大規模言語モデル「GPT-3.5」などのAPIを米Microsoftのクラウド上で使える「Azure OpenAI Service」の導入支援サービスを始めた。Azure OpenAI Serviceそのものや、チャットAIを使った新事業などを検証したい企業の利用を見込む。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR