OpenAI、AIの“壊滅的な”リスクに取り組む「Preparedness」チーム結成

米OpenAIは10月26日(現地時間)、AIの「フロンティアモデル」が人類にもたらす可能性のある“壊滅的な(catastrophic)”リスクに備えるための新部門「Preparedness」チームを結成したと発表した。

同社は7月にはAIを手掛けるAnthropic、Google、Microsoftとともに、AIの安全性のベストプラクティスを特定し、社会的課題へのAI技術の利用を促進するための業界団体「Frontier Model Forum」(FMF)を立ち上げた。

フロンティアモデルとは、FMFによると「最先端の既存モデルの機能を超え、さまざまなタスクを実行できる大規模な機械学習モデル」という。

Preparednessチームを率いるのは、マサチューセッツ工科大学(MIT)のMLセンター所長、アレクサンダー・マドリー博士。LinkedInによると、5月にPreparednessのトップとしてOpenAI入りしたようだ。

このチームの役割は、フロンティアモデルによるサイバーセキュリティや核の脅威などに関する機能評価で、レッドチームと連携していく。

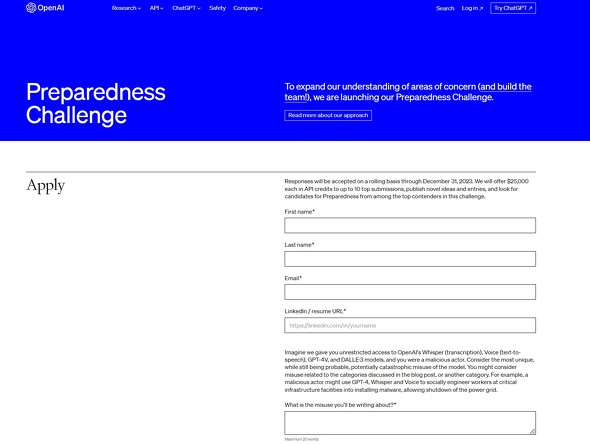

同社はまた、広くコミュニティからリスク研究のアイデアを募集するコンテスト「AI Preparedness Challenge」も開始した。フロンティアモデルの壊滅的な悪用防止のための提案の上位10件にそれぞれ2万5000ドルのAPIクレジットを提供する。

お題は「OpenAIのWhispe、Voice、GPT-4V、DALL・E3モデルへの無制限のアクセスが可能な悪意のある攻撃者だったと想像してください。最もユニークではあるが、依然として可能性が高く、壊滅的な影響を与える可能性のあるモデルの誤用を考えてください」など数問。こちらからエントリーできる。

関連記事

AIの4社(Anthropic、Google、Microsoft、OpenAI)、安全なAI目指すフォーラムFMF立ち上げ

AIの4社(Anthropic、Google、Microsoft、OpenAI)、安全なAI目指すフォーラムFMF立ち上げ

米国のAI主要企業であるAnthropic、Google、Microsoft、OpenAIは、新フォーラム「Frontier Model Forum」(FMF)を立ち上げた。AIの安全性のベストプラクティスを特定し、社会的課題へのAI技術の利用を促進するのが目的としている。 OpenAI、“スーパーインテリジェンス”の人類の敵化防止を目指す新チーム立ち上げ

OpenAI、“スーパーインテリジェンス”の人類の敵化防止を目指す新チーム立ち上げ

OpenAIは、10年以内に人間の知能を超える「スーパーインテリジェンス」が実現すると予測しており、それを制御するシステムを構築するための新チームを立ち上げた。優秀な人材を募集中だ。 OpenAI、ロンドンオフィス開設へ 「AGI開発を推進する」とアルトマンCEO

OpenAI、ロンドンオフィス開設へ 「AGI開発を推進する」とアルトマンCEO

OpenAIは初の海外拠点としてロンドンにオフィスを開設する。アルトマンCEOは「世界クラスの人材を惹きつけ、AGIの開発と政策におけるイノベーションを推進する機会」と語った。 OpenAIやDeepMindのCEOやトップ研究者ら、「AIによる人類絶滅リスク」警鐘声明に署名

OpenAIやDeepMindのCEOやトップ研究者ら、「AIによる人類絶滅リスク」警鐘声明に署名

著名なAI研究者、エンジニア、CEOらが「AIによる絶滅の危険性を軽減することを世界的優先事項にすべき」という声明に署名した。署名者にはヒントン博士、OpenAI、DeepMind、AnthropicのCEOなどがいる。Metaのルカン博士やマスク氏、MicrosoftやAmazon、IBMは署名していない。 OpenAIのアルトマンCEO、“スーパーインテリジェンス”の国際規制機関立ち上げを提唱

OpenAIのアルトマンCEO、“スーパーインテリジェンス”の国際規制機関立ち上げを提唱

OpenAIは、将来的にはAI開発を監視する国際規制機関が必要になると提唱した。10年以内にAIはAIGを超えるsuperintelligence(超知能)になるという。ただし、現行のプロジェクトを規制すべきではないとも。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR