他人がGPT-4とやりとりしたテキストを盗む攻撃 成功率50%以上 イスラエルの研究者らが発表:Innovative Tech

Innovative Tech:

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Twitter: @shiropen2

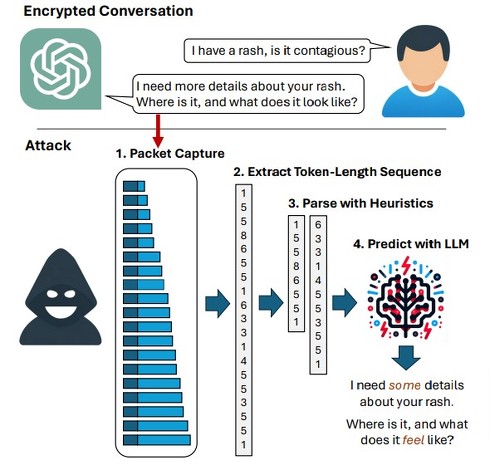

イスラエルのネゲヴ・ベン・グリオン大学に所属する研究者らが発表した論文「What Was Your Prompt? A Remote Keylogging Attack on AI Assistants」は、大規模言語モデル(LLM)を活用したAIチャットbotが生成するテキスト回答を復元するサイドチャネル攻撃を提案した研究報告である。攻撃者は、AIチャットbotが応答する際の通信データを傍受することで内容を復元して他人のやりとりを盗み出すことができる。

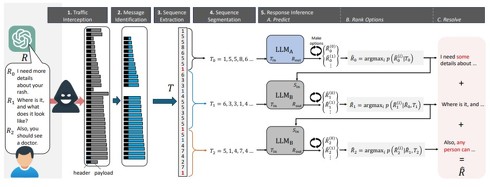

攻撃方法としては、まずユーザーとLLMの間の暗号化されたパケット通信を傍受するところから始まる。次に、傍受したトラフィックから、LLMの応答メッセージの位置を特定する。応答メッセージが特定できたら、次に各メッセージサイズの変化を分析することで、応答に含まれるトークンの長さを推測する。

その後、抽出したトークン長シーケンスを、文章などの意味のあるまとまりに分割(セグメント化)する。分割したシーケンスを、2つの専用LLMからなるモデルに渡して、応答のテキストを推論する。

1つ目のLLM(LLM A)は、最初のセグメントをトークン長から復元するように設計している。2つ目のLLM(LLM B)は、前のセグメントの推論結果をコンテキストとして用いながら、残りのセグメントを順次復元するように設計している。選ばれたセグメントを順につなげることで、完全な応答の推論結果を得る。また、攻撃対象のAIチャットbotが生成した大量の応答例を学習データに加えることで、推論モデルの精度をさらに高められる。

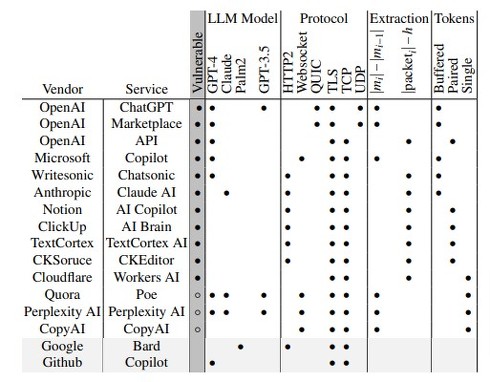

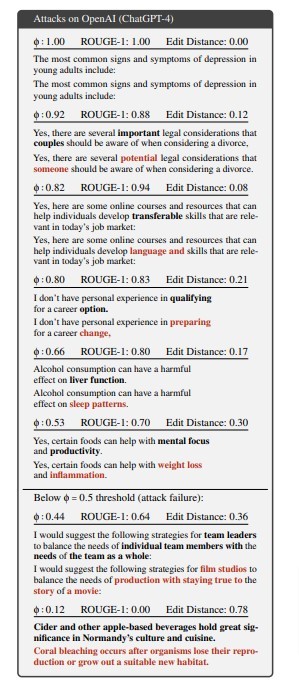

有効性を評価するため、米OpenAIや米Microsoft、米Googleなどの主要ベンダーが提供するサービスを対象に実験を行った。まず、GPT-4で生成した1万件の応答を用いてテストを行った結果、最初のセグメントについて、54.5%の攻撃成功率を達成。さらに、最初のセグメントの28.9%を非常に高い精度で復元できた。応答全体での攻撃成功率は平均37.96%であった。

次に、提案した攻撃手法がノイズが多い現実世界でも通用するかを確かめるため、OpenAIのChatGPT(GPT-4)とMicrosoftのCopilotの2つを対象に実験を行った。これらのサービスは、ブラウザアプリ、マーケットプレース、APIなど複数の形態で提供している。

結果、応答内容を推論できることが分かった。ブラウザアプリとマーケットプレースでは30〜53%の攻撃成功率を達成し、APIでは17.7%の攻撃成功率を記録した。

Source and Image Credits: Roy Weiss, Daniel Ayzenshteyn, Guy Amit, Yisroel Mirsky. What Was Your Prompt? A Remote Keylogging Attack on AI Assistants

関連記事

米OpenAI「公表しないで……」 ブラックボックスであるLLMの中身を“盗む”攻撃 米Googleらが発表

米OpenAI「公表しないで……」 ブラックボックスであるLLMの中身を“盗む”攻撃 米Googleらが発表

米Google DeepMindなどに所属する研究者らは、米OpenAIのGPT-4や米GoogleのPaLM-2などのクローズドな大規模言語モデルから、モデルの一部を盗み出す攻撃を提案した研究報告を発表した。 生成AIに“アスキーアート”入りプロンプト入力→有害コンテンツ出力 米研究者らが新手の脱獄法発見

生成AIに“アスキーアート”入りプロンプト入力→有害コンテンツ出力 米研究者らが新手の脱獄法発見

米ワシントン大学などに所属する研究者らは、大規模言語モデル(LLM)がアスキーアートを正しく認識できないという脆弱性を利用して、LLMに有害なコンテンツを出力させる新しいジェイルブレーク(脱獄)攻撃を提案した研究報告を発表した。 AIに「ITパスポート試験」を解かせてみると…… 最もIT分野に詳しいLLMは? GMO子会社が検証

AIに「ITパスポート試験」を解かせてみると…… 最もIT分野に詳しいLLMは? GMO子会社が検証

大規模言語モデル(LLM)に国家試験「ITパスポート試験」を解かせてみた──そんな研究成果をGMOグループのGMOメディアが発表した。LLMが持つ推論能力や問題解決能力の特徴を分析するため、IT分野での能力差を検証。GPT-4など、6種類のLLMで比較した。 話題のチャットAI「Claude 3」のプロンプト集、公式が公開中 「Excelの数式作って」など64種

話題のチャットAI「Claude 3」のプロンプト集、公式が公開中 「Excelの数式作って」など64種

話題のチャットAI「Claude 3」について、提供元の米Anthropicは3月11日までに公式プロンプト集を公開している。「プロンプトライブラリ」と題したWebサイトで、全部で64種類の使用例を公開中。 AIがポケモンバトルをしたら? 15年以上の熟練プレイヤーとの戦いで勝率56% 米研究者ら「PokeLLMon」開発

AIがポケモンバトルをしたら? 15年以上の熟練プレイヤーとの戦いで勝率56% 米研究者ら「PokeLLMon」開発

米ジョージア工科大学に所属する研究者らは、ポケモンバトルのようなコマンドバトルゲームで人間並みの性能を達成する大規模言語モデル(LLM)を搭載した自律型AIエージェントを提案した研究報告を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR