Microsoft、商用利用可のSLM「Phi-3」リリース スマホで動くモデルも

米Microsoftは4月23日(現地時間)、小規模言語モデル(SLM)の「Phi-3」を発表した。3サイズ(mini、small、medium)あり、最小モデルのminiは同日からAzure AI Studio、Hugging Face、Ollamaで利用可能になった。

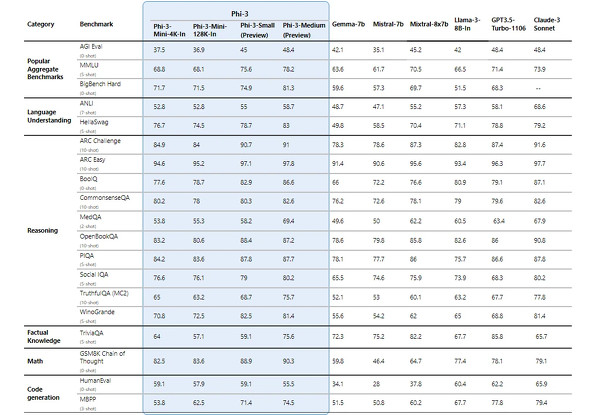

miniのトレーニングデータは38億パラメータ。smallは70億、mediamは140億と、大規模言語モデル(LLM)より少ないが、高品質なデータでトレーニングしているため、「主要なベンチマークにおいて、同じサイズまたはより大きなサイズの言語モデルよりも大幅に優れたパフォーマンスを示す」という。

例えばPhi-3-smallは、米OpenAIのGPT-3.5 Turbo(パラメータ数は公表されていないが、約175億とみられている)などの「はるかに大きなモデルよりも優れたパフォーマンスを発揮する」としている。

Microsoftは昨年12月に「Phi-2」をリリースした。これはベンチマークで、米MetaのLlama 2の700億パラメータモデルを幾つかの分野で上回っていた。Phi-2は200万回以上ダウンロードされた。

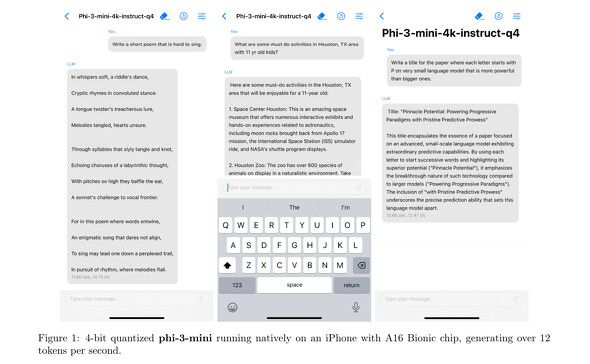

商用利用が可能なPhi-3-miniは、10倍のLLMに匹敵する機能を備える上、サイズが小さいため、LLMよりも実行コストも低くなる。Microsoftは関連論文で、パラメータを4ビットに圧縮したPhi-3-miniがiPhoneのA16 Bionicチップ上で1秒あたり12トークン以上を生成できたと紹介した。

米NVIDIAによると、Phi-3-miniは「RTX GPU」搭載のワークステーションや「GeForce RTX GPU」搭載のPCでローカルに実行可能という。

Microsoftは、Phi-3が「インターネットにアクセスしにくい可能性のある農業分野」などで低コストで活用できるとしている。

関連記事

Microsoft、Igniteで発表の小規模言語モデル「Phi-2」をAzureでリリース

Microsoft、Igniteで発表の小規模言語モデル「Phi-2」をAzureでリリース

Microsoftは、SLM(小規模言語モデル)の「Phi-2」をAzureでリリースした。27億パラメータだが、複数のベンチマークでMetaの「Llama 2」の700億パラメータモデルやGoogleの32億パラメータの「Gemini Nano 2」を上回った。 大規模言語モデルを選択→数秒後にAzure上で試せる「Models as a Service」登場 従量課金制の推論API、ファインチューニングも可能。

大規模言語モデルを選択→数秒後にAzure上で試せる「Models as a Service」登場 従量課金制の推論API、ファインチューニングも可能。

米Microsofthが、オープンソースの大規模言語モデルをMicrosoft Azure上でマネージドサービスとしてすぐに試せる「Models as a Service」を提供すると発表しました。 Apple、iPhone上でのLLM実行を可能にする手法の論文を発表

Apple、iPhone上でのLLM実行を可能にする手法の論文を発表

Appleは「LLM in a flash:Efficient Large Language Model Inference with Limited Memory」という論文を発表した。メモリ容量が限られた端末上でLLMを実行するための革新的な手法を編み出したとしている。 Google、オープンな生成AIモデル「Gemma」公開 商用利用OK、Geminiと同じ技術の軽量LLM

Google、オープンな生成AIモデル「Gemma」公開 商用利用OK、Geminiと同じ技術の軽量LLM

米Googleは、大規模言語モデル(LLM)「Gemma」を公開した。同社が開発するLLM「Gemini」に使ったのと同じ技術を活用して開発した軽量版LLMで、同社は「オープンなAIモデル」として位置付けている。商用利用も可能としている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR