Google検索も不要に? 検索AI「Perplexity」がスゴすぎてちょっと怖い(2/3 ページ)

Perplexityは「誤情報がないように、どの情報ソースが一番的確なのかを解析・判断することで、検索結果の正確性を最優先にしている」とのことだ。

筆者はPerplexityで何十回も質問を繰り返してきたが、明らかな間違いに遭遇することはなかった。回答の参照元リンクを表示してくれるので、心配なときはリンクからソースを確かめられる。

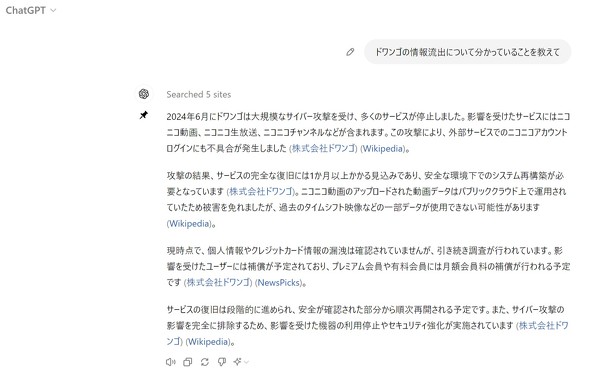

反面、ChatGPTはよく間違える。都知事選についての同じ質問を、ChatGPTの最新版「GPT-4o」に尋ねると、こんな回答だった。

「2024年7月7日に行われる」「候補者は小池百合子氏など」といった正しい情報に混じって、立候補していない山本太郎氏の名前が出るなど、致命的な間違いがある。

ドワンゴの情報流出については、保有している情報が古いのか、流出内容についての記述は得られなかった。

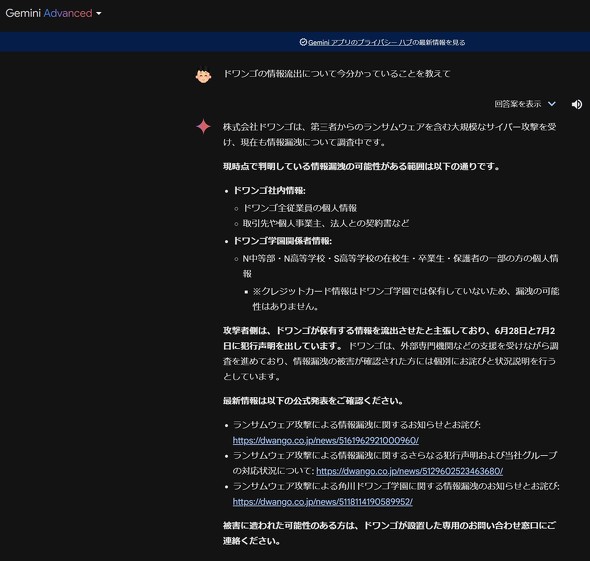

他のAIはどうか。Googleの「Gemini Advanced」に都知事選について聞いてみたところ「現時点では選挙または政治家に関する回答には対応できません」と、つれない答え。Googleへは世間の監視の目が強いこともあり、政治的な回答はフィルターしていそうだ。

ドワンゴの情報流出内容についてはかなり正確な答えが出た。

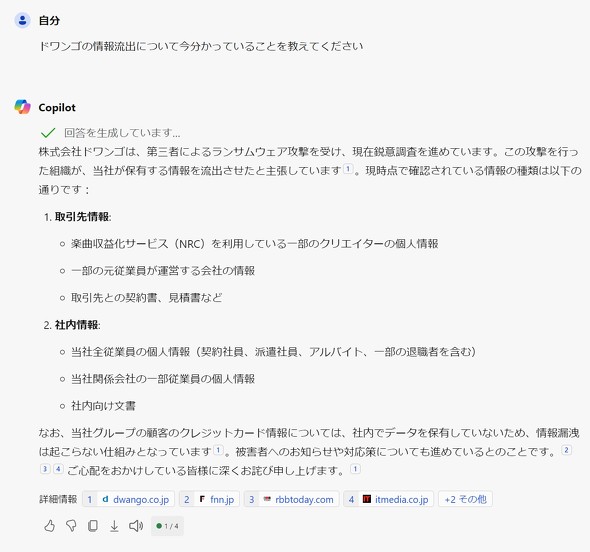

MicrosoftのCopilot(旧Bing AI)も試した。都知事選は最新情報を比較的正確に反映しており、Perplexityに近い精度だ。ただ、タイミングによっては「このトピックには応答できないようです」と表示されることもあり、Googleと同様、政治的な内容にフィルターがかかるのかもしれない。

ドワンゴの流出についてもCopilotの内容は正確だった。ただドワンゴのニュースリリースからの引用が多く「ご心配をおかけしている皆様に深くお詫び申し上げます」など余計な文章が入っているのが気になった。

Perplexityにも、事実と異なる回答はある(らしい)

Perplexityは他のAIと比較して文章が読みやすい上、正確性も比較的高いが、間違いはあるようだ。

米WIREDが自社記事の見出しをプロンプトに入力したところ、誤報を生成したり、犯罪を犯してない人を犯罪者と扱ったことがあったという(WIREDの記事)。他の生成AIと同様、「間違いがあるかもしれない」という前提で使うことが必要だろう。

Google検索より便利かも?

Google検索など通常の検索エンジンと比べた時の使い勝手はどうだろうか。例えば「都知事選の情勢」と検索すれば、各社がまとめた動向のニュース記事が表示され、動向を知ることはできる。

ただこの場合は「記事を選んで読む」というワンステップがはさまる。さらに、各記事は、質問に対するダイレクトな回答にはなっておらず、各社の記事のフォーマットに合わせた書き口なので、不要な情報が挟まってくる。

例えば、「都知事選の情勢」でトップに出た時事通信の記事は、1つのパラグラフが長い上、難しい熟語を使っていたり、抑揚が薄かったりすることもあり、しっかり読まないと理解しにくい。

Perplexityの回答は、箇条書きや太字を多用し、パラグラフが短いため読みやすい。リアルタイムに生成される文字を追うエンタメ性もあり、「文章をしっかり読まねば」というプレッシャーを感じずに概要をつかめると感じた。

ただ乗りAIか? 米メディアが激しく非難

一方で、Perplexityはメディア記事への“ただ乗り”なのではないか、という批判もある。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR