AIが生成する画像を「ネコ」にするサイバー攻撃 絵師らを守る技術「Nightshade」 米シカゴ大が開発:Innovative Tech(AI+)

Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

米シカゴ大学に所属する研究者らが発表した論文「Nightshade: Prompt-Specific Poisoning Attacks on Text-to-Image Generative Models」は、生成AIモデルの無断学習を抑止するために、学習されても予期せぬ動作をAIモデルに生成させる毒入りデータに画像を変換するツールを提案した研究報告である。

この攻撃は「Nightshade」と名付けられ、約200枚の細工画像をモデルの学習データに紛れ込ませるだけで、特定の単語に関連する画像生成を高確率で操作できてしまう。

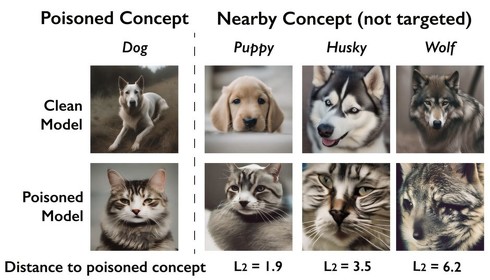

攻撃者は特定の単語(例えば「dog」)をターゲットに定め、モデルにその単語の入力があったとき、本来のdogとは無関係な別の画像(例えば「cat」)を生成させたいとする。そこで「dog」を含むテキストと、「cat」の画像を人工的にペアにした学習データを作り、それをモデルの学習データに混ぜ込む。するとモデルは「dog」と入力があっても「cat」の画像を生成するようになってしまう。

驚くべきはその効率の良さで、約200個程度の細工データでも攻撃が成功してしまう。さらに、細工画像は人間の目には自然な画像に見えるよう巧妙に最適化されているため、人手での検知は極めて困難である。

また、Nightshadeによる攻撃は関連語にも影響が波及する。例えば「dog」を攻撃すると、「puppy」や「husky」など意味的に近い単語の画像生成もおかしくなる。Nightshadeの効果は、画像の切り抜きや解像度の変更、圧縮、ノイズ付与などに対しても有効である。

さらに、異なる単語を大量に同時に攻撃することで、モデル全体の性能を大きく低下させることすら可能であるという。500〜1000個の単語を攻撃されたStable Diffusion XLモデルは、著しく精度が低下して全く無関係な単語の入力に対しても、意味不明の画像を出力するようになったと報告されている。

Nightshadeは、絵師や写真家などのアーティストがAIによる著作権侵害から自らの作品を守るために開発されたツールである。生成AIから人間のクリエイターを保護することを目標として技術ツールを開発する米シカゴ大学発の研究プロジェクト「Glaze」 の一環として開発された。

Source and Image Credits: Shan, Shawn, et al. “Prompt-specific poisoning attacks on text-to-image generative models.” arXiv preprint arXiv:2310.13828(2023).

関連記事

生成AI搭載アプリを狙うマルウェア「Morris II」 Gemini ProやGPT-4搭載アプリを介して個人情報窃取に成功

生成AI搭載アプリを狙うマルウェア「Morris II」 Gemini ProやGPT-4搭載アプリを介して個人情報窃取に成功

米Cornell Tech、イスラエル工科大学、米Intuitに所属する研究者らは、生成AIが組み込まれたアプリケーションを攻撃するマルウェアを提案した研究報告を発表した。 他人がGPT-4とやりとりしたテキストを盗む攻撃 成功率50%以上 イスラエルの研究者らが発表

他人がGPT-4とやりとりしたテキストを盗む攻撃 成功率50%以上 イスラエルの研究者らが発表

イスラエルのネゲヴ・ベン・グリオン大学に所属する研究者らは、大規模言語モデル(LLM)を活用したAIチャットbotが生成するテキスト回答を復元するサイドチャネル攻撃を提案した研究報告を発表した。 米OpenAI「公表しないで……」 ブラックボックスであるLLMの中身を“盗む”攻撃 米Googleらが発表

米OpenAI「公表しないで……」 ブラックボックスであるLLMの中身を“盗む”攻撃 米Googleらが発表

米Google DeepMindなどに所属する研究者らは、米OpenAIのGPT-4や米GoogleのPaLM-2などのクローズドな大規模言語モデルから、モデルの一部を盗み出す攻撃を提案した研究報告を発表した。 生成AIに“アスキーアート”入りプロンプト入力→有害コンテンツ出力 米研究者らが新手の脱獄法発見

生成AIに“アスキーアート”入りプロンプト入力→有害コンテンツ出力 米研究者らが新手の脱獄法発見

米ワシントン大学などに所属する研究者らは、大規模言語モデル(LLM)がアスキーアートを正しく認識できないという脆弱性を利用して、LLMに有害なコンテンツを出力させる新しいジェイルブレーク(脱獄)攻撃を提案した研究報告を発表した。 AIを使った“利益を出す馬券”の買い方とは? はこだて未来大の准教授がAIによる競馬予想法を指南

AIを使った“利益を出す馬券”の買い方とは? はこだて未来大の准教授がAIによる競馬予想法を指南

情報処理学会の学会誌「情報処理」の2019年1月発行分で「情報学者が競馬予想に踏み出すときに知っておくべきこと」と題した解説記事が掲載された。AIを活用して利益が出る馬券を買うために考慮しなければならない競馬予想に関することが記されている。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.