「RAGはそんなに簡単じゃない」──AIエンジニア主導でLLMを導入すると失敗に? 日本語特化のELYZA・曽根岡CEOに聞く、LLM開発&活用のいま(2/2 ページ)

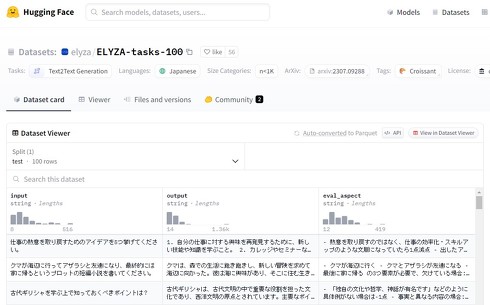

独自ベンチマーク「ELYZA Tasks 100」を開発

モデルの性能評価では、2023年に独自のベンチマークテスト「ELYZA Tasks 100」を作成・公開している。これは、生成AIのテキスト出力を評価する指標で、100個の質問に答えた結果を人間が評価するものだ。

「当時は文章から単語を抜き出すようなベンチマークしかなく、チャットボットに期待する性能とは違った。そこで物語作成や歴史、算数など幅広い100のタスクからなるベンチマークを開発した。問題と出力結果、スコアもすべて公開し、公平性と透明性を重視している」

「RAGはそんなに簡単じゃない」

2024年の生成AI活用において、企業が持つ固有の知識をLLMに学習させる「RAG」(Retrieval-Augmented Generation、検索拡張生成)という手法に注目が集まっている。RAGは、関連する情報をLLMに検索・抽出させ、その情報を用いて回答を生成させる手法だ。これにより、LLMを企業特有のタスクに適用しやすくなると期待されている。

しかし、曽根岡CEOは「感覚的にはRAGはそんな簡単ではない。一時期のチャットボットのような幻滅期に入るのではないか」と指摘する。

「RAGは検索システムの精度と、LLMの精度を両方のチューニングを要する2変数問題だ。検索システムの精度の改善は難しい。Googleのような最高の検索システムでも、ベストマッチの記事が出るのが6、7割程度。社内ドキュメントの検索システムであれば、50%あればいい方だろう。そう仮定すると、LLMが検索したテキストは、まず50%の確率で間違っていることになる。LLMが写し間違いや解釈ミスをする可能性があるので、正答率を50%に到達させるのは難しいということになる」

RAGにおいて実用的な精度を高めるには、検索システムの改善や検索内容を最適化など、柔軟なアプローチを取るべきという。

「ゴールは正しいドキュメントを検索し、適切に回答することだ。社内ドキュメントから有休取得の期間を知りたいケースなら、『就業規則に関する質問ですか?』といったクッションを挟んで探索範囲を狭めるなど、いろいろ工夫の余地はある」

日本語の効率的な処理に向けたトークナイザーの改良

RAGの改良と共に曽根岡CEOは、トークナイザーにも注目しているという。トークナイザーは文章をLLMで扱う上で必要になる前処理ツールの一つで、文章をトークンという単位に分割する。人間にとっての単語とは必ずしも一致しないが、機械にとっての単語というのが近い概念だ。

「例えばGPT-3では英語の『Hello』は1トークンだが、日本語の『こんにちは』は3トークンになる。専門用語である『大規模言語モデル』だと11トークンにもなる。文章生成には膨大な処理が必要になる。これを1トークンとして扱えば、LLMの処理は11倍高速化することになる」

曽根岡CEOは、特定領域に特化したトークナイザーの構築による効率化の可能性を指摘する。

「医療文章を書くのに特化したトークナイザーだと、とても効率がよくなるかもしれない。あるいは、AIの研究の文章を書くのに特化したトークナイザーだと、すごい少ない処理で済むかもしれない。パラメーター数が5000億あるモデルよりも、少ない処理でできてしまうこともあり得る」

「モデルのパラメータ数は大きいほど良いのは間違い無いが、効率よく処理するアーキテクチャだったり、トークナイザーだったり、そのほか諸々の工夫は、LLM研究開発の競争においては非常に重要だ」

曽根岡CEOは、日本語LLMの開発競争において、モデルの大規模化と並行して、処理の効率化が重要な課題になると指摘している。特定分野に特化したトークナイザーの開発は、その有力な解決策の一つとして期待されている。

現場主導のLLM活用を

曽根岡CEOは「LLMの競争軸は汎用性から特化性に移行しつつある。日本語や法律、医療、製造業など特定分野に特化したモデルで差別化することが求められるようになる」と今後の技術トレンドを展望する。

「LLMの開発競争も汎用モデルで競おうという時代は、少しだけ変わってきている気がしている。この後はどう特色を出すかが重要になる。その特色の出し方も、どのようなタスクの性能が高いのかが重要になる」

「例えば日本語の法律をちゃんと知っているモデルや、日本の医療について詳しいモデル、日本の製造業や自動車製造業に特化したマルチモーダルのモデル。ユーザー企業がそのモデルを選ぶ理由が存在するということが、今後のLLM開発の競争の中で重要になる」

また、LLMのアプリケーション開発においては、現場の評価を重視すべきだと指摘した。

「現場評価ドリブンのLLM活用が広まってほしい。AIエンジニアが『これいい感じの出力だよね、決裁者の方もいいって言ってるから導入しよう』と進めると、現場の人からすると全然使えないAIサービスになってしまう。結局、現場で使える評価をできる人は現場にしかいない」と述べ、LLMの導入検討では、実際に使う人の評価軸でPDCAを回していくことが肝要だと強調した。

この点で強みとなるのがKDDIとの提携だ。曽根岡氏は「これからはKDDIという5万人いるグループ会社の皆さんと一緒に、現場の人と二人三脚でいろんなプロダクトを作る体制ができた」と、KDDIの営業力とネットワークを活用して、現場主導のLLMの事業化を加速させる考えを示した。

関連記事

国産LLMが抱える“開発コスト”の課題 海外勢に安さで勝てるか、ELYZA代表の危機感

国産LLMが抱える“開発コスト”の課題 海外勢に安さで勝てるか、ELYZA代表の危機感

ELYZAは、「GPT-3.5やGeminiに匹敵する」という日本語特化型LLMを発表した。同社の曾根岡代表は「今回のニュースは日本国内の状況を踏まえると本当に喜ばしいこと」と語る一方、国内のLLM開発ビジネスにおいて“資金面”が大きな課題であると指摘する。 ELYZAが新たな日本語LLMを開発 「GPT-3.5 Turboにも匹敵」 チャット形式のデモサイトも公開

ELYZAが新たな日本語LLMを開発 「GPT-3.5 Turboにも匹敵」 チャット形式のデモサイトも公開

東大発のAIスタートアップ企業であるELYZAは、700億パラメータの大規模言語モデル(LLM)「ELYZA-japanese-Llama-2-70b」を開発したと発表した。日本企業のLLMの性能を大きく上回り、グローバルモデルの性能にも匹敵するという。 KDDI、東大発AIベンチャー・ELYZAを連結子会社化 春以降、生成AI関連サービスを提供へ

KDDI、東大発AIベンチャー・ELYZAを連結子会社化 春以降、生成AI関連サービスを提供へ

KDDIは、東大発のAIスタートアップ企業であるELYZAを連結子会社にすると発表した。資本業務提携を結び、4月1日をめどにKDDIグループがELYZAの株式の過半数を保有する。これにより、同社らは「生成AIの社会実装を加速させる」としている。

Copyright © ITmedia, Inc. All Rights Reserved.