物議を醸した「顔写真から自閉症を判別するアプリ」 医療分野でのAI活用に求められる倫理観を考える(2/4 ページ)

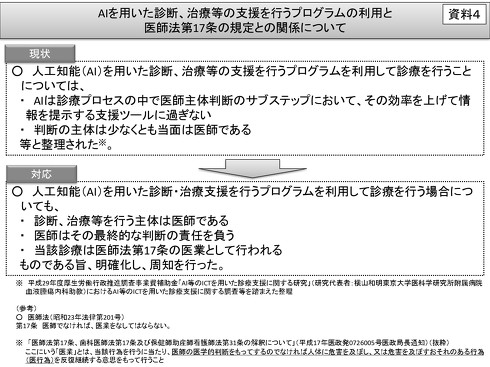

しかしこの17条を巡っては、こうした診断AIを人間の医師によって使用する場合、判断の主体は医師である(そのため診断AIを活用するのは問題ない)という見解が厚生労働省が提示している。今回の自閉症診断アプリは、医師でなくても誰でも使用できるものであったという点で、この見解には合致しない。

ただ少なくとも「AIに診断を行わせること」があらゆる場合において違法というわけではなく、実際にこれまでも多くの診断AIが研究・実用化されている(その中には今回のように、自閉症を診断するAIも存在する)。技術の進化と法律の解釈という関係は複雑な問題であるため、ここではいったん脇に置くとしよう。

なぜ医師法17条は「医業」を医師という専門家だけに限定しているのか、その理由は今回の自閉症診断AIを巡る批判と大きく関わっている。

医療行為を医師に限定しているのは、この行為がもたらすインパクトが極めて大きいためだ。1つのミスが患者の生死に直結する可能性があり、たとえ命を落とさなかったとしても、その後の人生や生活に大きな影響を及ぼすこととなる。そのような行為を軽々しくAIで自動化すべきではない、というのは極めてまっとうな考え方だろう。

今回の自閉症診断AIは、前述の開発者によるエントリによれば、オンライン上で入手可能な「自閉症(児)の顔画像データセット」を学習データとして使用したようだ。それだけでどれほど正確な診断ができたかどうかは疑問であり、ネット上で起きた批判の中にも、そうした精度の問題を指摘する声があった。

また精度という点に関連して「顔から自閉症を診断する」という行為が、社会の偏見を助長しかねないという指摘もあった。

現時点では、顔という外見だけで自閉症を診断できるという根拠は無く、前述の通り開発者自身が「医学的根拠は現状ない」と認めている。また今回使用した顔画像データセットの中に偏りがあり、それを基に開発したAIモデルにも偏りが生まれ、例えば指定の人種が自閉症と診断されやすい状態になっていたという可能性も考えられる。

しかし、特に「AIは万能である」という風潮が強い現代においては、AIが出す診断結果がうのみにされてしまう可能性が高い。そのため、誤った考え方が社会にまん延しかねず、その意味で不用意に提供される診断AIは、直接影響を受ける患者以外の人々についても、その人生を狂わせる恐れがあるといえるだろう。

診断結果の“言いっぱなし”で終わるAI

さらに、仮にその精度が十分に高いものだったとしても、それをどう告知するかという問題が残る。例えば日本では長らく、がん患者に対して、自身ががんであることを告知すべきではないという考え方があった。それはがん告知が、患者の精神に大きな負担を与えることを危惧したためである。

最近では医療技術が進化し、がんの有効な治療法が登場してきたこと、またいわゆる「インフォームド・コンセント」(患者に十分な説明をした上で、彼ら自身にどのような治療行為を受けるか決定してもらうという考え方)が定着してきたことから、がん告知を積極的に行うようになっている。

しかしあらゆる病気について、あらゆる患者が、その事実を正しく受け止められるというわけではない。人間の医師であれば、患者と同様に適切に対処できるだろう。しかしAI診断アプリの場合は、言いっぱなしで終わってしまい、患者の不安をいたずらにあおる結果になりかねない。

Copyright © ITmedia, Inc. All Rights Reserved.