物議を醸した「顔写真から自閉症を判別するアプリ」 医療分野でのAI活用に求められる倫理観を考える(1/4 ページ)

8月3日、技術者向け情報共有サービス「Qiita」に、「顔写真から自閉症を判別してみた」というエントリが載った(現在は削除済み)。タイトルの通り、顔写真から自閉症を判別するWebアプリを開発したという内容だった。

これは、AIプロダクトの開発などを手掛けるのアイデミー(東京都千代田区)が提供するオンラインプログラミングスクール「Aidemy Premium」の受講者が公開したもの。このスクールが提供する講座の受講修了要件を満たすためとして、機械学習技術を使ってアプリを開発し、その開発の過程などをまとめていたのだ。

しかしエントリが公開されると、すぐさまネット上で疑問の声が上がった。「倫理的にアウト」や「就職活動で利用されたりしたらこわい」「他人の顔写真を勝手に食わせて『こいつやっぱり自閉症だって』と言いふらすといった差別的な使われ方をされかねない」など、差別を助長するような使い方ができるのではという意見が相次いだ。

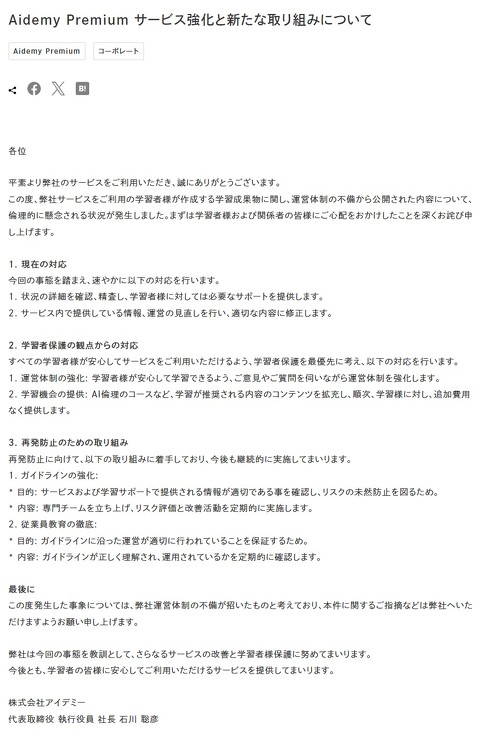

そして批判は、講座を開設していたアイデミーに対しても向けられることとなった。この受講者がアプリ開発のテーマの選定に当たって「チューターの後押しがあった」と記述が見られたことから「なぜ止めなかったのか」と非難されたのである。

結局、このエントリは削除され、アイデミーも7日に「弊社サービスを利用者が作成する学習成果物に関し、運営体制の不備から、倫理的に懸念される状況が発生した」と認めて「皆さまにご心配をおかけしたことを深くおわび申し上げます」と謝罪した。

ただこの受講者は、あくまで機械学習の知識が身に付いたことを示すためにアプリを開発しただけで、これで何か商売をしようとしていたわけではない。また、エントリ内にて「医学的根拠は現状ない」ことも追記しており、その精度に限界があることを認めていた。

今回の件は、テクノロジーの利用領域に対する倫理観を問われたわけだが、その中でも特に慎重にならなくてはいけないのが医療分野での利用だ。自閉症診断アプリに多くの批判が集まったように、医療分野でAIを活用する際には特有の論点が存在している。

「医療」という行為の重大性

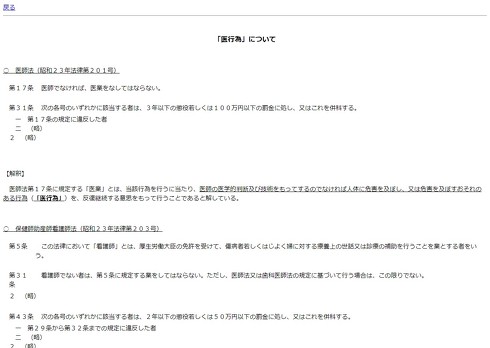

まず、こうした診断という医療行為をAIが行うこと自体が違法である、という議論がある。例えば日本では、医師法17条によって「医師でなければ、医業をなしてはならない」と定められている。

厚生労働省によれば、医業とは「医師の医学的判断及び技術をもってするのでなければ人体に危害を及ぼし、又は危害を及ぼすおそれのある行為を、反復継続する意思をもって行うこと」としている。難しい文章だが、これに基づいて考えた場合、人間の医師ではないAIが病気の診断を行うのは違法だと指摘しているのだ。

Copyright © ITmedia, Inc. All Rights Reserved.