リコー、低コスト・高速うたう新LLM 日英中対応で今秋提供

» 2024年08月21日 13時48分 公開

[ITmedia]

リコーは8月21日、日英中3言語に対応した、700億パラメータの大規模言語モデル(LLM)を開発したと発表した。米Metaが提供するLLM「Meta-Llama-3-70B」の日本語性能を高めた「Llama-3-Swallow-70B」をベースに、独自データによる追加学習などを実施。これにより、ベースモデルに比べ日本語の処理効率を43%向上させ、コスト効率や処理速度を高めたという。

今回のLLMは、米Amazon Web Servicesと共同で開発したスクリプトで訓練した他、独自データ約1万6000件による追加学習を実施。テキストをLLMが理解できるよう分割する「トークナイザー」の改良により、日本語の処理効率を向上させた他、さらなる追加学習による「破滅的忘却」(追加学習の際に過去に学習したタスクを忘れる現象)も抑制したという。これにより、企業独自の「プライベートLLM」のベースとしても利用しやすいとうたっている。

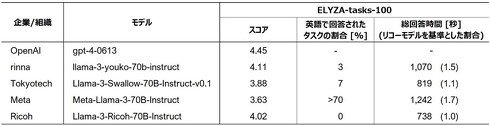

複雑な指示・タスク処理の能力を評価する日本語のベンチマーク「ELYZA-tasks-100」では、回答速度で「Meta-Llama-3-70B-Instruct」「Llama-3-Swallow-70B-Instruct-v0.1」などのLLMを上回った。他のLLMのように、英語で回答してしまうこともなかったという。

今回開発したLLMは、オンプレミス・クラウド双方の環境で利用できる形で、2024年秋に提供を始める。プライベートLLMとしての活用も視野に、まずは日本で提供し、その後海外への提供も目指す。

関連記事

GPT-4を超える日本語性能のLLM、PFN子会社がフルスクラッチで開発 無料トライアルを開始

GPT-4を超える日本語性能のLLM、PFN子会社がフルスクラッチで開発 無料トライアルを開始

AIスタートアップ・Preferred Networks(PFN)の子会社であるPreferred Elementsは8月7日、大規模言語モデル「PLaMo β版」の無料トライアルの申し込み受付を始めたと発表した。 Sakana AI、複数の画像を扱える“日本語視覚言語モデル”公開 非英語圏での先駆けに

Sakana AI、複数の画像を扱える“日本語視覚言語モデル”公開 非英語圏での先駆けに

AIスタートアップのSakana AIは、複数の画像について日本語で質疑応答できるAIモデル「Llama-3-EvoVLM-JP-v2」を発表した。 リコー、企業独自のAIモデル作成できるノーコード開発ツールを提供

リコー、企業独自のAIモデル作成できるノーコード開発ツールを提供

リコーは、Excelファイルをアップロードするだけで、企業固有のワードを学習したAIモデルを簡単に作成できるノーコード開発ツールを開発した。 リコー、AI活用のデータビジネスに参入 「ハード中心のビジネスを転換」

リコー、AI活用のデータビジネスに参入 「ハード中心のビジネスを転換」

リコーは6月17日、AIを活用したデータビジネスに参入すると発表した。企業から受け取った文書などを分析し、得られたデータを基に業務効率化などを支援するサービスを提供する。2025年度までに100億円の売上を目指すといい、山下良則CEOは「ハードウェアビジネスとデータビジネスを組み合わせ、これまでハード中心だったビジネスの転換を図る」としている。 企業のAI活用の“真打ち” 「プライベートLLM」の可能性から実践方法まで、専門家が解説

企業のAI活用の“真打ち” 「プライベートLLM」の可能性から実践方法まで、専門家が解説

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

SpecialPR

アイティメディアからのお知らせ

SpecialPR