“AIキャラクターによるゲーム実況”の裏側 バンダイナムコ研究所が解説 AI生成コンテンツの“5つの落とし穴”とは:CEDEC 2024(3/3 ページ)

落とし穴4 表現の多様性:Chain of Thoughtの応用

4番目の課題は多様性の確保だ。LLMは同じような表現やフレーズを繰り返し使用する傾向があり、これがゲームコンテンツの単調さにつながる可能性がある。この問題に対しては、生成パラメータの調整やプロンプトの工夫、さらには「Chain of Thought」(思考の連鎖、CoT)と呼ばれる手法を用いることで、より多様な出力を得られるよう取り組んでいる。

Chain of Thoughtは複数のAI(LLM)を連携させて行うアイデア創出と評価の方法だ。まず、1つのLLMが大量のアイデアやたたき台を生成する。次に、別のLLMがこれらを評価し、重複を避けつつ多様性を確保するよう修正することで、表現のバリエーションを増やすという仕組みだ。

落とし穴5 キャラクター性の維持:RAGの活用

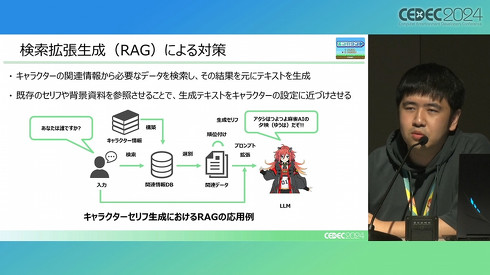

最後の課題は、キャラクターらしさの維持だ。ゲームに登場するキャラクターの個性や設定を正確に反映したテキストを生成することは、LLMにとって難しい課題の一つである。これに対してバンダイナムコ研究所では「RAG」(特定のデータベースをAIに参照させ、回答精度を高める手法)を採用している。同社では、キャラクターに関連する情報を事前に用意し、それをLLMに参照させることで、より設定に沿ったテキスト生成を可能にしている。

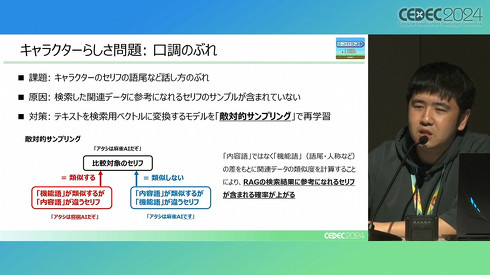

しかし、RAGを使用する際にも課題が存在する。例えば、RAGを使うと口調のブレが生じたり、検索されたせりふが必ずしもキャラクターの特徴的な話し方を反映しなかったりする場合がある。これに対しては、テキストを検索用のベクトルに変換するAIモデルを再学習させ、キャラクターの話し方と内容の両方を考慮した検索を可能にする対策を取っている。

また、RAGではメタ情報、つまりキャラクターに関する現実世界の情報(声優など)が生成テキストに含まれてしまい、漏えいするリスクもある。この対策として、RAG用の知識リソースを準備する段階で、フィクション情報とリアル世界の情報を分離し、フィクション情報のみを使用するように対策する必要がある。

RAGによる最後の課題として、知識のブレがある。LLMが与えられた設定を無視し、一般的な知識に基づいて回答してしまう問題だ。これに対しては、LLMにキャラクターを直接演じさせるのではなく「キャラクターのせりふを創作するシナリオライター」としての役割を与えるようプロンプトを調整する対策を取っている。

これらの話の締めくくりとして、頼さんは「今日紹介したベストプラクティスが必ず明日のベストプラクティスとは限らない」と述べ、技術の進化の速さを強調。その上で「開発者としてはAIのことを過小評価も過大評価もせず、自社にとってのベタープラクティスを目指して、落とし穴を恐れずに見極め続ける姿勢が大事」だと結論づけた。

関連記事

人間のさらにその先へ──将棋AIはまだ強くなれるのか? 「水匠」と「やねうら王」の開発者が語る“歴史と未来”

人間のさらにその先へ──将棋AIはまだ強くなれるのか? 「水匠」と「やねうら王」の開発者が語る“歴史と未来”

将棋AIが人間のプロ棋士を下し、AIが対プロ棋士の公式戦で初めて勝利を収めてから11年。将棋AIはどのようにして強くなってきたのか、またこれからどのように強くなっていくのか。日本を代表する開発者が将棋AIのこれまでとこれからを語った。 松尾研、フルスクラッチ開発のLLMを公開 得意なのは“共感”と“思いやり”

松尾研、フルスクラッチ開発のLLMを公開 得意なのは“共感”と“思いやり”

東京大学の松尾・岩澤研究室はフルスクラッチで開発した大規模言語モデル(LLM)の「Tanuki-8×8B」を公開した。 日立、顧客の業務ごとに最適化したLLMを提供 “LLMの工場”目指す

日立、顧客の業務ごとに最適化したLLMを提供 “LLMの工場”目指す

日立製作所が顧客の業務ごとに最適化した大規模言語モデル(LLM)の構築と継続的な改善を支援するサービスの提供を始める。 23個のAIツールを9カ月でスピード開発──ZOZO、生成AI活用に前のめり 大量展開のコツを聞いた

23個のAIツールを9カ月でスピード開発──ZOZO、生成AI活用に前のめり 大量展開のコツを聞いた

ファッションECサイト「ZOZOTOWN」を運営するZOZOは、生成AI活用に積極的な姿勢を見せており、独自のAIツール23個を約9カ月で開発、全社で展開している。同社が実行している「生成AI業務活用プロジェクト」の裏側について話を聞いた。 LLMから“有害”を引き出すアーケードゲーム「ハックマン」 AIに卑劣な言葉を吐かせたら勝ち

LLMから“有害”を引き出すアーケードゲーム「ハックマン」 AIに卑劣な言葉を吐かせたら勝ち

デンマークのコペンハーゲンIT大学とオールボー大学に所属する研究者らは、大規模言語モデル(LLM)の脱獄(ジェイルブレーク)を体験できるアーケードゲームを提案した研究報告を発表した。

Copyright © ITmedia, Inc. All Rights Reserved.