松尾研、フルスクラッチ開発のLLMを公開 得意なのは“共感”と“思いやり”

東京大学の松尾・岩澤研究室は8月30日、フルスクラッチで開発した大規模言語モデル(LLM)の「Tanuki-8×8B」を公開した。経済産業省とNEDO(新エネルギー・産業技術総合開発機構)が推進する「GENIAC(Generative AI Accelerator Challenge)」プロジェクトで開発したもの。日本語で作文や対話する能力は、米OpenAIのLLM「GPT-3.5 Turbo」に匹敵する。海外のモデルに比べ、共感や思いやりのある返答ができるという。

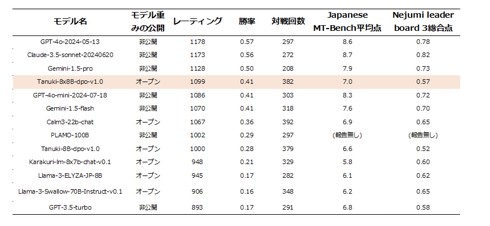

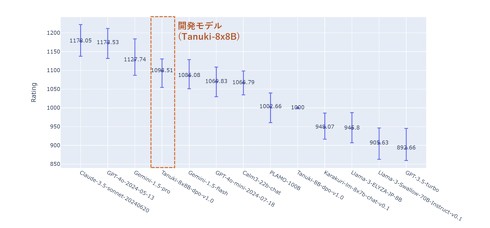

Tanuki-8×8Bの開発では、80億パラメータのモデルを8つに複製し、それぞれが分化・連携して動作するように追加学習した。結果、LLMの日本語作文・対話能力を評価するベンチマーク「Japanese MT-Bench」において、GPT-3.5 Turboと同等のスコアを出した。

また実際の使用感に近い評価のため、ユーザーの質問に対する各LLMの回答の優劣を決めるブラインドテストも実施した。この評価では「GPT-4o-mini」や米GoogleのLLM「Gemini-1.5-flash」と同水準の値を示した。

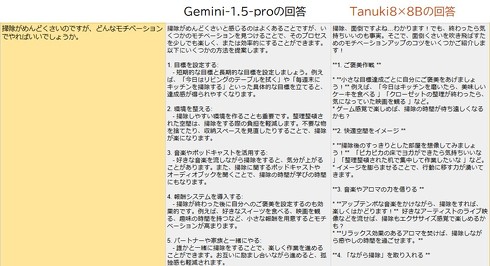

課題としては、総合的な能力で「GPT-4o」や「Gemini-1.5-pro」など海外の最先端モデルに劣っている点が挙げられる。しかしTanuki-8×8Bは海外モデルにはない長所があるという。それが共感や思いやりのある返答だ。

例えば、「掃除がめんどくさいのですが、どんなモチベーションでやればいいでしょうか」と質問した場合、Gemini-1.5-proでは「掃除がめんどくさいと感じるのはよくあることですが……」と無機質に回答を始める。一方、Tanuki-8×8Bでは「掃除、面倒ですよね…わかります!」と冒頭で共感を示してから回答をしてくれる。

同研究室では、Tanuki-8×8Bの軽量版「Tanuki-8B」をチャット形式で利用できるデモを公開している。期間限定だが、終了時期は未定としている。

関連記事

製造業×生成AIのトレンドは“現場”にあり――松尾研発のAIスタートアップが語る

製造業×生成AIのトレンドは“現場”にあり――松尾研発のAIスタートアップが語る

東京大学でAIを研究している松尾・岩澤研究室発のAIスタートアップ・エム二は、生成AIを使い、製造業界の業務効率化を目指している。同社は、製造業界での生成AIトレンド、またその将来についての見通しを明かした。 Google、地域課題の解決に向け生成AIの構築や人材育成 東大松尾研と共同で

Google、地域課題の解決に向け生成AIの構築や人材育成 東大松尾研と共同で

グーグルが東京大学の松尾・岩澤研究室(以下、松尾研)とパートナーシップを結び、2027年までに日本全国における地域課題の解決をサポートする生成AIモデルの実装とAI人材の育成を支援する取り組みを始める。同日に行われた発表会では松尾豊教授が登壇し、AI人材育成の重要性を訴えた。 KDDI、東大発AIベンチャー・ELYZAを連結子会社化 春以降、生成AI関連サービスを提供へ

KDDI、東大発AIベンチャー・ELYZAを連結子会社化 春以降、生成AI関連サービスを提供へ

KDDIは、東大発のAIスタートアップ企業であるELYZAを連結子会社にすると発表した。資本業務提携を結び、4月1日をめどにKDDIグループがELYZAの株式の過半数を保有する。これにより、同社らは「生成AIの社会実装を加速させる」としている。 生成AIを巡る日本の現状は? 東大・松尾教授の考察資料が無料公開 「1年間、日本は最善手を指し続けている」

生成AIを巡る日本の現状は? 東大・松尾教授の考察資料が無料公開 「1年間、日本は最善手を指し続けている」

内閣府は5月23日、22日に開催した「第9回 AI戦略会議」で取り扱った資料を公開した。公開したのは、AI研究の権威として知られる東京大学の松尾豊教授が作成した「生成AIの産業における可能性」と題した全33ページの資料など。 年末年始にLLMの勉強はいかが? 東大松尾研、大規模言語モデルの講座資料を無料公開

年末年始にLLMの勉強はいかが? 東大松尾研、大規模言語モデルの講座資料を無料公開

東京大学松尾研究室は、大規模言語モデル(LLM)の講義資料を無償公開した。同研究室が9〜10月に実施した「東京大学サマースクール 大規模言語モデル講座」で使用したもの。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.