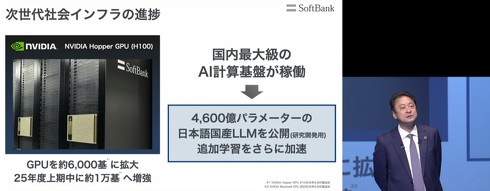

ソフトバンク、4600億パラメータの日本語特化LLMを公開 「日本でも大規模なAI作れると証明」

ソフトバンクは11月8日、4600億パラメータの大規模言語モデル(LLM)「Sarashina2-8x70B」を公開した。国内で開発しており、日本語に特化したモデルだという。2025年3月期第2四半期の決算説明に登壇した宮川潤一CEOは「日本でも大規模なAIを作れると証明した」と語った。

開発を担当したグループ会社・SB Intuitionsによると、Sarashina2-8x70Bは、複数のエキスパートモデル(特定の作業に強みを持つ小型モデル)を組み合わせ、より高い推論性能を実現する手法「Mixture of Experts」で開発。自然言語処理で使われるトランスフォーマーにおいて、8個のエキスパートモデルを使って訓練したという。

今回公開したのは、指示チューニングを施していない事前学習モデル。「人間の意図に沿った出力を行うようにチューニングを行ったものではないため、そのまま実用的なサービスに供することはできない」としている。研究開発の促進が目的のため、商用利用はできない。なお詳細は後日発表するとしている。

「1兆パラメータまで持っていける」発言も

Sarashina2-8x70Bを開発した背景について、ソフトバンクの宮川潤一社長執行役員兼CEOは「日本も4000億パラメータを超えるAIを作れると証明したかった」と語った。

「急に米OpenAIの『o1』に肩を並べるところまで行くとは思わない。けれど米Metaの『Llama 3』と同じくらいのパラメータ数のAIを作った。日本の企業だからAIを作ることはできないとか、アメリカと比べて日本は劣後しているとか、そうじゃないことを示したかった」(宮川CEO)

今後の展開についても言及。「2025年度には商用展開できるよう準備を進めていく」と説明した。

「10月末にはNVIDIAの『H100』を使った計算基盤が稼働。GPUが約6000機で稼働することになり、計算能力も従来の5倍になった。25年度上半期には、1万機まで増やす計画だ。これらを使ってLLMへの追加学習を加速させていく」(宮川CEO)として、「1兆パラメータまで持っていける」とさらなる目標を掲げた。

関連記事

生成AIで福岡のPR記事作成→“架空の祭りや景色”への指摘が続出 開始1週間で全て削除する事態に

生成AIで福岡のPR記事作成→“架空の祭りや景色”への指摘が続出 開始1週間で全て削除する事態に

Webで地方の魅力をPRする「つながり応援プロジェクト」は、福岡県でのキャンペーン「福岡つながり応援」の公式Webメディアで「誤った情報を発信した」と公式Xで謝罪した。生成AIを活用してPR用の記事を制作したところ、ユーザーから間違いを指摘する声が相次いだという。 富士通、AMDとタッグ 自社CPUと“H200超え”GPUで「低電力AI基盤」 27年初頭に投入

富士通、AMDとタッグ 自社CPUと“H200超え”GPUで「低電力AI基盤」 27年初頭に投入

富士通とAMDは低コスト・低電力なAIプラットフォームの実現に向け、戦略的協業を始めた。 GitHub Copilotが「Gemini 1.5 Pro」「o1-preview」「Claude 3.5 Sonnet」に対応

GitHub Copilotが「Gemini 1.5 Pro」「o1-preview」「Claude 3.5 Sonnet」に対応

AIプログラミング補助ツール「GitHub Copilot」が、新たに「Claude 3.5 Sonnet」「Gemini 1.5 Pro」「o1-preview」「o1-mini」などのLLM(大規模言語モデル)に対応する。 ChatGPTのo1は「ノーベル賞ものだと思う」──孫正義氏による“成年の主張”

ChatGPTのo1は「ノーベル賞ものだと思う」──孫正義氏による“成年の主張”

「これ(o1)はノーベル賞ものだと思う」──ソフトバンクグループの孫正義代表取締役社長兼社長による“成年の主張”。 企業のAI活用の“真打ち” 「プライベートLLM」の可能性から実践方法まで、専門家が解説

企業のAI活用の“真打ち” 「プライベートLLM」の可能性から実践方法まで、専門家が解説

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.