OpenAIの「o1」と同レベルうたうLLM「R1」登場、中国DeepSeekから 商用利用可

» 2025年01月21日 06時00分 公開

[ITmedia]

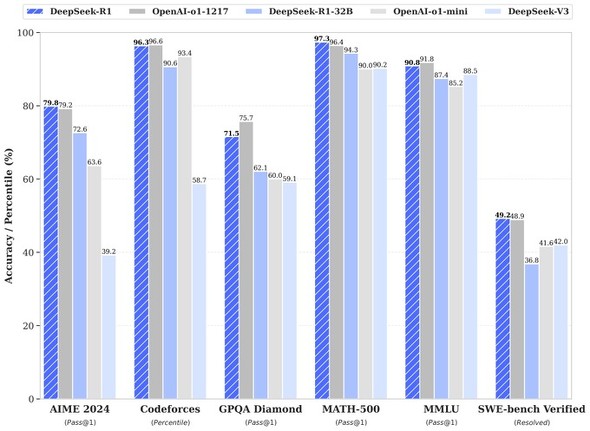

中国のAI企業DeepSeekは1月20日(日本時間)までに、米OpenAIの「o1」と同レベルの性能をうたう大規模言語モデル(LLM)「DeepSeek-R1」を公開した。いずれもMITライセンスで、商業利用なども認めている。

大規模な強化学習のみでトレーニングしたという「DeepSeek-R1-Zero」、教師あり微調整を行い、数学やコード生成などでo1に匹敵する性能を実現したとうたうDeepSeek-R1を公開。さらに、DeepSeek-R1をベースに、米MetaのLlamaや中国AlibabaのQwenなどを活用して調整した6つの蒸留(既存の大きなモデルを基に、近い性能を持ったより小さいモデルを開発する手法)モデルも公開した。このうち「DeepSeek-R1-Distill-Qwen-32B」は、複数のベンチマークでo1-miniの性能を上回ったという。

R1はAPIも提供。料金は、100万トークン(おおむね単語数の意)の入力当たり0.55ドル。ただしキャッシュされたトークンが入力された場合は同0.14ドル。出力は同2.19ドル。DeepSeekは他モデルのAPI料金を値引くセールを実施中だが、R1は対象にならない。

関連記事

中国テンセント、3890億パラメータのオープンソース大規模言語モデル「Hunyuan-Large」発表

中国テンセント、3890億パラメータのオープンソース大規模言語モデル「Hunyuan-Large」発表

中国Tencentに所属する研究者らは、TransformerベースのMixture of Experts(MoE)モデルであるオープンソース大規模言語モデル(LLM)を提案した研究報告を発表した。 NVIDIAから個人向け小型AIスパコン 1台3000ドル 最大2000億パラメータのLLMを実行可

NVIDIAから個人向け小型AIスパコン 1台3000ドル 最大2000億パラメータのLLMを実行可

NVIDIAが個人用のAIスーパーコンピュータ「Project DIGITS」を発表した。AI研究者や学生、データサイエンティストをターゲットにした製品で、5月に3000ドル(1ドル157円換算で約47万円)で発売する。 米国「中国にはAIチップを輸出規制」→テンセントら中国AI企業は回避 “4つの回避法”とは?

米国「中国にはAIチップを輸出規制」→テンセントら中国AI企業は回避 “4つの回避法”とは?

米カリフォルニア大学バークレー校に所属する研究者らは、中国のAI企業が米国の半導体輸出規制を回避して最先端のAIモデルを開発している実態を、テンセントの事例を中心に技術的・制度的な観点から分析した研究報告を発表した。 Sakana AI、AIの“多様性”を尊重した集団を開発する手法「CycleQD」発表 生物の“すみ分け”がヒント

Sakana AI、AIの“多様性”を尊重した集団を開発する手法「CycleQD」発表 生物の“すみ分け”がヒント

AIベンチャー「Sakana AI」は、自然界の生物の「すみ分け」の仕組みをヒントに、小規模なAIモデル(AIエージェント)を複数育て上げ、それぞれが得意分野を持ちながら協力し合える新しい開発手法を提案した研究報告を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

SpecialPR

SpecialPR

アイティメディアからのお知らせ

SpecialPR

あなたにおすすめの記事PR