AIモデル「Llama 3.3 Swallow」、東京科学大などのチームが公開 日本語能力は「GPT-4oに迫る」

東京科学大学情報理工学院の岡崎研究室と横田研究室、産業技術総合研究所の研究チームは3月10日、大規模言語モデル(LLM)「Llama 3.3 Swallow」を開発したと発表した。米MetaのLLM「Llama 3.3」をベースに日本語の能力を強化したAIモデル。日本語理解・生成タスクでは、米OpenAIのLLM「GPT-4o」にも迫る性能を記録したとしている。

今回公開したAIモデルは2種で、ベースモデルの「Llama 3.3 Swallow 70B v0.4」と、指示学習済みの「Llama 3.3 Swallow 70B Instruct v0.4」。どちらもLlama 3.3ライセンスで、これに従いつつ、米GoogleのGemma利用規約の利用制限に抵触しない範囲(学習用合成データにGemma2を使っているため)で、研究や商用などで利用できる。

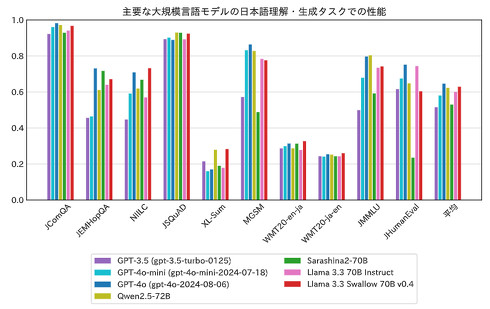

70Bベースモデルの日本語理解・生成性能については、GPTシリーズなどの他社モデルと比較したところ、平均スコア「0.629」を記録。これは、1位のGPT-4o「0.646」に次ぐ2位の成績であり、3位のQwen2.5-72B「0.623」を上回った。研究チームは「GPT-4oに迫る性能といえる」と説明している。

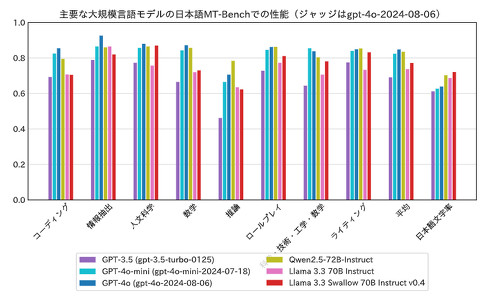

指示学習済みモデルの対話性能は、平均スコア「0.772」となり、GPT-4o(0.848)やQwen2.5-72B-Instruct(0.835)とは差がつく結果に。研究チームは「人文科学やライティングなど、知識や日本語に関するタスクは得意のようだが、コーディングや数学、推論などで差がついており、改善の余地がある」と述べている。

関連記事

米AMD、AIモデル「Instella」シリーズ公開 パラメータ数30億の小規模サイズ 同社製GPUを利用

米AMD、AIモデル「Instella」シリーズ公開 パラメータ数30億の小規模サイズ 同社製GPUを利用

米AMDは、AIモデル「Instella」シリーズを公開した。 32Bなのに「DeepSeek R1」フルモデルと同性能? アリババがAIモデル「QwQ-32B」公開

32Bなのに「DeepSeek R1」フルモデルと同性能? アリババがAIモデル「QwQ-32B」公開

中国Alibabaは、大規模言語モデル(LLM)「QwQ-32B」を発表した。パラメータ数が320億でありながら、中国DeepSeekのLLM「DeepSeek R1」(パラメータ数6710億)と同等の性能を達成したという。 ソフトバンクのAI開発企業、小規模言語モデルを公開 30億パラメータ以下の3種類 商用利用も可能

ソフトバンクのAI開発企業、小規模言語モデルを公開 30億パラメータ以下の3種類 商用利用も可能

ソフトバンクの子会社でAIの研究開発などを手掛けるSB Intuitionsは、小規模言語モデル(SLM)「Sarashina2.2」シリーズを公開した。 Microsoft、ゲームのアイデア出し支援AIモデル「Muse」を発表

Microsoft、ゲームのアイデア出し支援AIモデル「Muse」を発表

Microsoftは、ゲーム開発者向けのAIモデル「Muse」を発表した。7年分のゲームプレイデータでトレーニングされており、ゲームプレイを生成し、開発者を支援するとしている。 楽天、AIモデル「Rakuten AI 2.0」シリーズを無料公開 大規模言語モデル&小規模言語モデルの2形態で

楽天、AIモデル「Rakuten AI 2.0」シリーズを無料公開 大規模言語モデル&小規模言語モデルの2形態で

楽天グループは、大規模言語モデル(LLM)「Rakuten AI 2.0」と小規模言語モデル(SLM)「Rakuten AI 2.0 mini」の提供を始めた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.