ソフトバンクのAI開発企業、小規模言語モデルを公開 30億パラメータ以下の3種類 商用利用も可能

» 2025年03月05日 13時57分 公開

[松浦立樹,ITmedia]

ソフトバンクの子会社でAIの研究開発などを手掛けるSB Intuitions(東京都港区)は3月5日、小規模言語モデル(SLM)「Sarashina2.2」シリーズを公開した。パラメータ数5億、10億、30億の事前学習モデルの3種類を公開。いずれもMITライセンスで、商用利用なども可能だ。

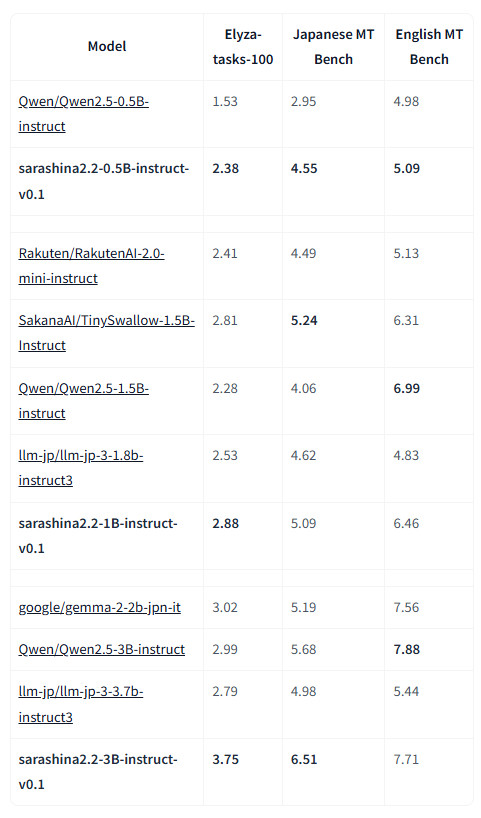

Sarashina2.2シリーズは、Webコーパスから抽出した日本語や英語、コードを含む10兆個のトークンで学習を行った。2.2-3Bモデルについては、同社が以前公開したAIモデル「Sarashina2-7B」よりも、日本語能力や数学、コーディング面で長けた性能を持つ。

また日本語処理性能においては、中国Alibabaが開発するAIモデル「Qwen」シリーズなど同等のパラメータ数を他社モデルと比較しても、Sarashina2.2はより優れた結果を示したとしている。

いずれのAIモデルも、同社のHugging Face上のページで公開している。

関連記事

“大は小を兼ねない”生成AI 注目集める「小規模言語モデル」(SLM) そのメリットとは?

“大は小を兼ねない”生成AI 注目集める「小規模言語モデル」(SLM) そのメリットとは?

先日行われた、米Microsoftの開発者向けイベント「Microsoft Build 2024」の目玉の一つだった「SLM」(Small Language Model)。そもそもSLMとは何か? 何が期待されているのか? SLMの基本を整理する。 楽天、AIモデル「Rakuten AI 2.0」シリーズを無料公開 大規模言語モデル&小規模言語モデルの2形態で

楽天、AIモデル「Rakuten AI 2.0」シリーズを無料公開 大規模言語モデル&小規模言語モデルの2形態で

楽天グループは、大規模言語モデル(LLM)「Rakuten AI 2.0」と小規模言語モデル(SLM)「Rakuten AI 2.0 mini」の提供を始めた。 iPhone 14で高速動作する軽量AIモデル、Sakana AIが開発 知識蒸留の新手法「TAID」採用

iPhone 14で高速動作する軽量AIモデル、Sakana AIが開発 知識蒸留の新手法「TAID」採用

AIベンチャーのSakana AIは、小規模言語モデル(SLM)「TinySwallow-1.5B」を開発したと発表した。大規模言語モデル(LLM)の知識を効率的にSLMに転移できる新技術「TAID」を開発し、これを利用し作成した。 話題の中華LLM「DeepSeek R1」の日本語追加学習モデル サイバーエージェントが無料公開

話題の中華LLM「DeepSeek R1」の日本語追加学習モデル サイバーエージェントが無料公開

サイバーエージェントは、大規模言語モデル(LLM)「DeepSeek-R1」を使った新たなAIモデルを公開した。 ソフトバンク、4600億パラメータの日本語特化LLMを公開 「日本でも大規模なAI作れると証明」

ソフトバンク、4600億パラメータの日本語特化LLMを公開 「日本でも大規模なAI作れると証明」

ソフトバンクは、4600億パラメータ大規模言語モデル(LLM)「Sarashina2-8x70B」を公開した。国内で開発しており、日本語に特化したモデルだという。宮川潤一CEOは「日本でも大規模なAIを作れると証明した」と語った。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

SpecialPR

アイティメディアからのお知らせ

SpecialPR