OpenAI、ChatGPTにGPT-4oベースの画像生成機能 セレブの画像も生成可能

米OpenAIは3月25日(現地時間)、マルチモーダルモデル「GPT-4o」を活用した新たな画像生成機能を「ChatGPT」にネイティブ統合したと発表した。従来の「DALL・E」シリーズと比較して大幅に性能が向上しており、よりリアルな画像の生成、画像を入力とした編集・変換、プロンプト内のテキストを正確に画像へ反映する能力などが特徴という。

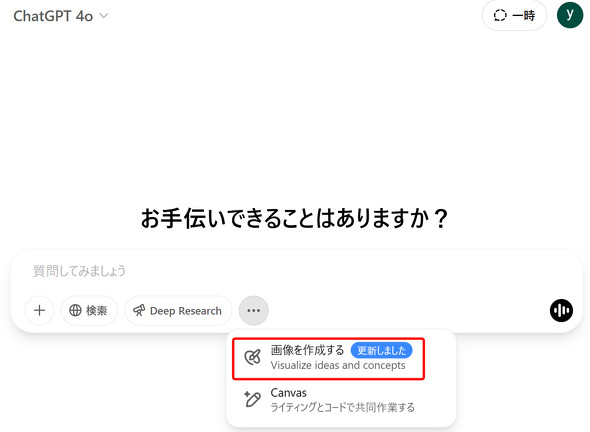

同日から、Plus、Pro、Team、無料プラン向けに展開され、EnterpriseおよびEduでも近日中に利用できるようになる予定だ。無料プランでの利用回数の制限などについてはまだ公表されていない。また、「Sora」でも使える。開発者向けのAPI経由の提供は、今後数週間以内に展開する。なお、従来の画像生成モデルDALL・Eは、ChatGPT内の専用GPTなどを通じて引き続き利用できる。

この新たな画像生成機能(発表文には名称は記載されていない)は、GPT-4oモデルのアーキテクチャ内に深く組み込まれており、GPT-4oの知識を活用することで、美しいだけでなく、文脈に即した微妙なニュアンスや実用的な側面を持つ画像を生成できるとしている。

DALL・Eよりも写真に近いリアルな画像を生成できる。また、既存の画像をベースに、関連性のある画像や修正を加えた画像を生成できる。詳細な指示を理解し、プロンプトに含まれるテキストを画像に正確に反映させる能力が向上した。

アーキテクチャ的には、DALL・EがDiffusion Model(拡散モデル)であるのに対し、GPT-4oの画像生成はAutoregressive Model(自己回帰モデル)として実装されている。この違いが、新たな機能と、それに伴うリスクの両方を生み出している。

OpenAIは、この新機能がもたらす潜在的なリスク(実在の人物画像の悪意ある改変、武器の設計図生成など)を認識しており、DALL・EやSoraの運用で培った経験と既存の安全インフラを基盤に対策を講じていると、System Card(PDF)で説明する。

System Cardによると、以下のような安全対策を行っているという。

- チャットモデルによる拒否:ChatGPTのチャットモデル自体が、ポリシーに違反するコンテンツ生成を指示するプロンプトを検知し、画像生成プロセスを開始させない

- プロンプトブロッキング:画像生成ツールが呼び出された後、入力されたテキストや画像を分類器が分析し、ポリシー違反と判断された場合は生成をブロックする

- 出力ブロッキング:画像が生成された後、CSAM(児童性的虐待コンテンツ)分類器や、安全ポリシーに特化して訓練されたマルチモーダル推論モニターなどが画像を評価し、違反コンテンツの出力を防ぐ

- 未成年者保護の強化:上記全ての対策を組み合わせ、18歳未満と推定されるユーザーに対しては、不適切な可能性のあるコンテンツ生成をさらに制限する

これらの安全対策の有効性は、外部のレッドチームによる手動テスト、自動化されたレッドチームテスト、実際の利用シナリオを想定したオフラインテストを通じて評価されている。

評価結果によると、システムによる緩和策とチャットモデルの拒否を組み合わせることで、ポリシー違反のコンテンツ生成を97%以上防ぎつつ、過剰な拒否をある程度抑えることができているとしている。

以下のような制限がある。

- リアルな子供が写った既存画像の編集は許可しない

- 生存中のアーティストの名前を指定してスタイルを模倣するリクエストは拒否

- セレブ(著名人)の画像生成は原則ブロックしないが、未成年や暴力的であるなどのポリシーに違反する場合は制限

- 性別、人種、肌の色に関する表現の多様性は改善が見られるものの、依然として課題は残る

- ディープフェイクや性的コンテンツなどは生成を制限・防止するが、芸術的、創造的、フィクションの文脈における暴力描写はある程度許容する

また、すべての生成画像に、C2PAメタデータを付与する。

OpenAIは、今回の画像生成機能のリリースを、AIシステムの安全性を確保するための厳格かつ反復的なアプローチの一環と位置付けている。実際の利用状況から学びつつ、今後も安全対策とポリシーを継続的に評価し、改善していく方針だ。

関連記事

OpenAI、「高度な音声モード」に割り込み減などの新機能

OpenAI、「高度な音声モード」に割り込み減などの新機能

OpenAIは、「ChatGPT」アプリの「高度な音声モード」で、ゆっくり考えながら話しても途中で割り込まないように改善したと発表した。有料ユーザー向けにはさらに、各モデルの個性を改善したとしている。 ChatGPT利用と孤独感の関係性──OpenAIとMITが共同研究結果を発表

ChatGPT利用と孤独感の関係性──OpenAIとMITが共同研究結果を発表

OpenAIとMITメディアラボは、ChatGPTなどのAIチャットbotの利用が人間に与える影響についての研究結果を発表した。利用時間の長さと孤独感の増加に相関関係があることなどが明らかになったとしている。 “暖かみのある会話”を実現――OpenAIの新言語モデル「GPT-4.5」は何が変わったのか?

“暖かみのある会話”を実現――OpenAIの新言語モデル「GPT-4.5」は何が変わったのか?

OpenAIの新言語モデル「GPT-4.5」のリサーチプレビュー版をリリースした。従来の「GPT-4」と何が変わったのか、実際に試しつつ解説する。【更新】 OpenAIの動画生成AI「Sora」、ついに一般提供開始 「ChatGPT」課金ユーザーなら追加負担なし

OpenAIの動画生成AI「Sora」、ついに一般提供開始 「ChatGPT」課金ユーザーなら追加負担なし

米OpenAIは12月9日(現地時間)、動画生成AI「Sora」を同日から提供すると発表した。 OpenAI、DALL・E 3で生成した画像にCP2Aの電子透かし追加

OpenAI、DALL・E 3で生成した画像にCP2Aの電子透かし追加

OpenAIは、画像生成AIモデル「DALL・E 3」で生成された画像にC2PAメタデータを含ませるようにしたと発表した。画像を「Content Credentials Verify」などにドロップすると発行元がOpenAIだと表示される。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.