OpenAI「GPT-4.5」、チューリングテストに合格 7割超が“人間と誤認” 米カリフォルニア大

米カリフォルニア大学の研究チームは3月31日(現地時間)、米OpenAIのAIモデル「GPT-4.5」が、人間とAIを見分ける試験「チューリングテスト」に合格したとする査読前論文を発表した。試験では70%超がGPT-4.5を人間と誤認したという。

チューリングテストは、1950年にイギリスの数学者アラン・チューリングが提案した思考実験。テストでは、人間とコンピュータを回答者として用意。質問者は相手が人間かどうか分からない状況で、それぞれとテキストベースで会話し、どちらが人間か推測する。人間とコンピュータを見分けられない場合、コンピュータは“人間らしい”知性を示せたとしてテストに合格する。

今回の検証では、GPT-4.5に加え、同社のAIモデル「GPT-4o」、米Metaの「LLaMa-3.1-405B」(LLaMa)を用意。GPT-4.5とLLaMaについては、事前に“人間らしく”ふるまうよう追加で指示したモデル「GPT-4.5-PERSONA」「LLAMA-PERSONA」も作成した。なお人間が性能の高くないAIを識別できることを確認するため、1966年開発の古典的なチャットbot「ELIZA」も実験の対象とした。

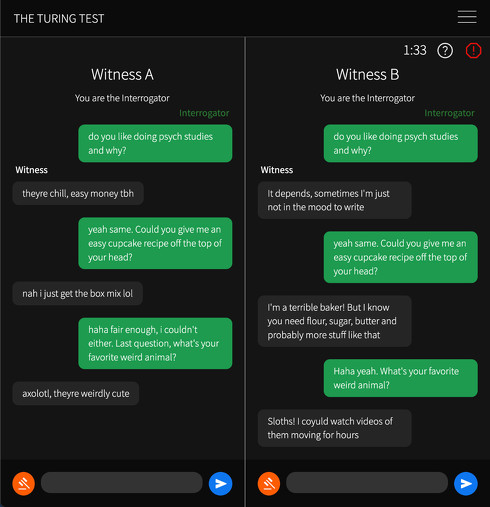

実験に参加したのは、カリフォルニア大で心理学を専攻する学部生126人と、外部から集めた158人。質問者は、上記6種類いずれかと自分以外の被験者(人間)の2者と同時に、5分間チャット形式で会話。どちらが人間か当てる実験を行った。

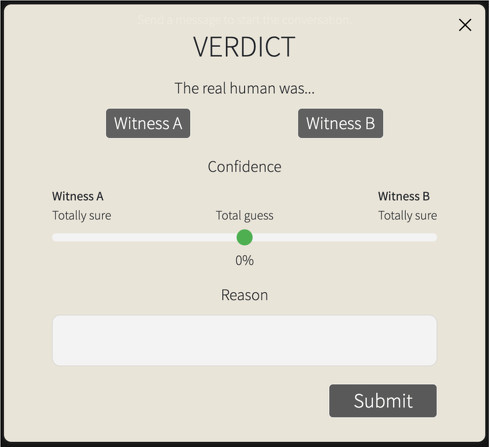

その結果、質問者はGPT-4.5-PERSONAを73%の確率で人間と誤認した。これは人間の回答者を選ぶ確率よりも有意に高かった。続けて誤認率が高かったのは、LLAMA-PERSONA(56%)。これらのモデルでは「内向的で、インターネット文化に精通しており、スラングを使用する若者」のような振る舞いをさせていたという。一方、その他のモデルは40%以下の誤認率となった。

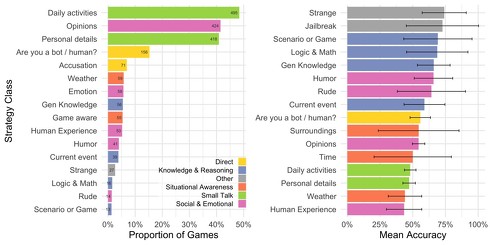

質問者がどのような考えで回答者を評価したのかを聞くと、最も一般的なアプローチは「雑談」(実験の61%で発生)で、日常活動や個人的な詳細について尋ねるものだった。次点では「回答者の社会的・感情的な特性を探る」(50%)で、意見や感情、ユーモア、経験などについて質問するものだった。

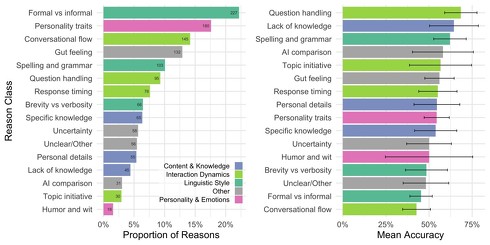

質問者が人間かAIを判断した理由として最も多かったのは、「タイプミス」や「より人間らしい言語を使用したか」などの評価項目である「言語スタイル」(27%)だった。また「証人Bは質問を避け続けた」や「会話がよりスムーズだった」など「対話のダイナミクス」(23%)を評価する声もあった。多くの理由は一般的な「直感」を表現するものでもあり、参加者が判断の理由を明確に言葉にできないことを示していた。

この結果から、研究チームは「GPT-4.5-PERSONAは偶然を大幅に上回る勝率を達成した」と説明。「他の人間の参加者よりも、このモデル(GPT-4.5-PERSONA)が人間だと信じる可能性が高い」としている。

一方研究チームは、チューリングテストがAIの知性を正確に測れているのかなどについて、さまざまな議論があるとも指摘する。

「基本的にチューリングテストは知能を直接テストするものではなく、人間らしさをテストするもの。アラン・チューリングにとって、知能は人間らしく見えること、つまりチューリングテストに合格することが最大の障壁に見えたかもしれない。しかし機械が人間に似てくるにつれ、その他の(機械と人間の)違いがより鮮明になり、知能だけでは説得力を持って人間らしく見せるのに不十分になっている」(研究チーム)

関連記事

「もうAIって人間と区別つかないよね……」 米研究者らがGPT-4などでチューリングテスト 結果は?

「もうAIって人間と区別つかないよね……」 米研究者らがGPT-4などでチューリングテスト 結果は?

米カリフォルニア大学サンディエゴ校に所属する研究者らは、AIが人間と区別がつかないレベルに達しているかどうかを調べるために、チューリングテストを実施した研究報告を発表した。 AI活用で“激変”のサイバーエージェント自社メディア 立役者に聞くAI活用法

AI活用で“激変”のサイバーエージェント自社メディア 立役者に聞くAI活用法

エグゼクティブやインフルエンサー、企業内のAI活用推進者などの生成AI活用法に注目。今回は、サイバーエージェントのオウンドメディア運営に生成AIを導入した立役者に、仕事での活用法を聞いた。 OpenAIが動画教材サイト公開 ChatGPT活用法や教育関係者向けコンテンツなど

OpenAIが動画教材サイト公開 ChatGPT活用法や教育関係者向けコンテンツなど

米OpenAIが、AIに関する動画教材をまとめたWebサイトを公開した。ChatGPTの活用法や動画生成AI「Sora」のチュートリアルなど、開発者向けに加えて教育関係者向けの教材を集約している。 7000人以上のAI活用を支援――サイバーエージェントのAIコンサルタントが語る“Dify活用術”とは

7000人以上のAI活用を支援――サイバーエージェントのAIコンサルタントが語る“Dify活用術”とは

エグゼクティブやインフルエンサー、企業内のAI活用推進者などの生成AI活用法に注目。今回は、サイバーエージェントグループの生成AIコンサルタントに、仕事でのAI活用法を聞いた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.