Meta、ネイティブマルチモーダルAI「Llama 4」発表 最小モデルは「H100」1枚で利用可能

米Metaは4月5日(土曜日、現地時間)、マルチモーダルなLLMファミリー「Llama 4」を発表した。よりパーソナライズされたマルチモーダル体験を構築できるようになるとしている。

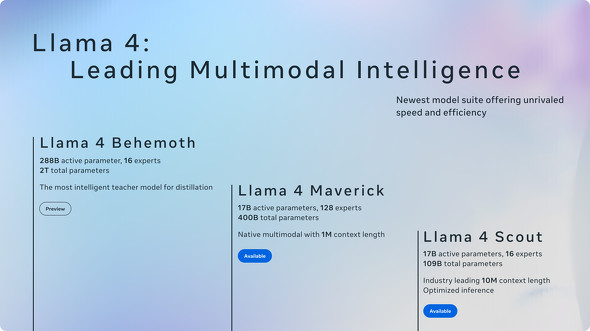

サイズの小さいものから、「Scout」(偵察者というような意味)、「Maverick」(一匹狼というような意味)、「Behemoth」(巨大な怪物というような意味)の3種類あり、ScoutとMaverickは同日からllama.comとHugging Faceでダウンロードできる。マルチモーダル機能は、まずは米国の英語版でのみ利用可能だ。

Llama 4の主な特徴

Llama 4の大きな特徴の1つは、ネイティブなマルチモーダル機能。「初期融合」(early fusion)を採用したことにより、大量のラベルなしテキスト、画像、動画でモデルを共同で事前学習できるようになった。初期融合は、テキストと視覚的なトークンを統合されたモデルバックボーンにシームレスに組み込む手法だ。

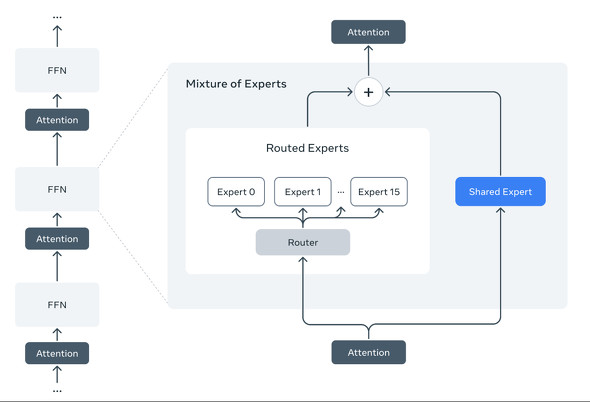

Llamaシリーズで初めて、トレーニングとクエリへの回答で計算効率の高い、「Mixture of Experts」(MoE)アーキテクチャを採用した。MoEアーキテクチャは、基本的にデータ処理タスクをサブタスクに分割し、それをより小さく専門化された「エキスパート」モデルに委任するというもの。

また、100以上の言語でそれぞれ10億以上のトークンを含む、「Llama 3」の10倍以上の多言語トークンで事前学習されており、オープンソースのファインチューニングの取り組みを強化したという。

3つのモデルの違い

Scoutは、16のエキスパートを持つ170億のアクティブパラメータモデルで、コンテキストウィンドウは1000万トークン(先代の「Llama 3」は12万8000トークン)。ドキュメントの要約や大規模なコードベースでの推論で威力を発揮する。米NVIDIAのGPU「H100」1つで利用可能としている。すべての旧世代Llamaモデルより強力という。広範なベンチマークで米Googleの「Gemma 3」と「Gemini 2.0 Flash Lite」、仏Mistral AIの「Mistral 3.1」よりも優れた結果を示した。

Maverickは、128のエキスパートを持つ170億のアクティブパラメータモデルで、コンテキストウィンドウは100万トークン。ネイティブマルチモーダルに対応する。「H100 DGX」システムが必要だ。広範なベンチマークで米OpenAIの「GPT-4o」、Googleの「Gemini 2.0 Flash」を上回った。推論とコーディングでは、中国DeepSeekの「DeepSeek v3」と同等の結果を、アクティブパラメータが半分以下で達成した。

Behemothは、16のエキスパートを持つ2880億のアクティブパラメータモデルで、「Meta史上最も強力」。コンテキストウィンドウについては記載がない。「蒸留用の最も知的な教師モデル」という。現在もトレーニング中だ。複数のSTEMベンチマークでOpenAIの「GPT-4.5」、米Anthropicの「Claude Sonnet 3.7」、Googleの「Gemini 2.0 Pro」を上回る性能を示した。Behemothは、ScoutとMaverickの教師モデルとして利用されている。

セーフガードと保護

Metaは、Llama 4をAI保護に関する開発者向け利用ガイドに概説されているベストプラクティスに従って構築していると説明した。

システムレベルでは、潜在的に有害な入力と出力を特定し、防御するのに役立つ幾つかのセーフガードをオープンソース化している。

例えば、MLCommonsと共同で開発したハザードタクソノミーに基づく入力/出力安全性大規模言語モデルである「Llama Guard」や、悪意のあるプロンプト(Jailbreak)と入力インジェクションの両方を検出できる「Prompt Guard」、生成AIのサイバーセキュリティリスクを理解し軽減するのに役立つ評価「CyberSecEval」などだ。

また、LLMが抱える政治的、社会的トピックでのバイアス問題に対処するための取り組みも進めている。Llama 4はLlama 3と比較して、議論の余地のある政治的および社会的なトピック全体での拒否を減らし、応答を拒否するプロンプトのバランスを劇的に改善しているという。

関連記事

MetaのAIモデル「Llama」、10億ダウンロード突破

MetaのAIモデル「Llama」、10億ダウンロード突破

Metaは、AIモデル「Llama」のダウンロード数が10億回を突破したと発表した。独自ライセンスによるオープンソース化がダウンロードを促進しているとしている。 日本語能力を強化した「Llama 3.3 Swallow」はGPT-4oに迫る性能/AppleがmacOSやiPadOSなどでのWebKit脆弱性を修正

日本語能力を強化した「Llama 3.3 Swallow」はGPT-4oに迫る性能/AppleがmacOSやiPadOSなどでのWebKit脆弱性を修正

うっかり見逃していたけれど、ちょっと気になる――そんなニュースを週末に“一気読み”する連載。今回は、3月9日週を中心に公開された主なニュースを一気にチェックしましょう! Meta、「Llama」を「国家防衛のために米政府機関に提供している」

Meta、「Llama」を「国家防衛のために米政府機関に提供している」

Metaは、“オープンな”LLM「Llama」シリーズを防衛のために米国政府機関に提供していると発表した。利用規約では軍事利用を禁じているが、例外を設けているとメディアに語った。 Meta、無料で商用可のLLM「Llama 3.2」リリース マルチモーダルモデルも

Meta、無料で商用可のLLM「Llama 3.2」リリース マルチモーダルモデルも

MetaはLLMの最新版「Llama 3.2」を発表した。初のマルチモーダルモデルと、エッジデバイス対応の軽量モデルがある。開発者は無料で利用可能だ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.