Meta、動画内アイテム識別AI「SAM 3」と3Dモデル「SAM 3D」を公開

米Metaは11月19日(現地時間)、動画内のアイテムも識別できるAIモデル「Segment Anything Model 3」(SAM 3)を発表した。コードとモデルの重みを独自の「SAM License」の下、GitHubで公開した。このリリースには、SAM 3とともに、単一画像からの3D物体、人体再構築のためのオープンソースモデル群「SAM 3D」も含まれている。

SAM 3は、画像と動画のプロンプト可能なセグメンテーションのための統一基盤モデル。テキスト、例示、ボックスやマスクなどの視覚的プロンプトを使ってオブジェクトを検出し、セグメント化し、追跡できるというものだ。

前身である「SAM 2」と比較して、短いテキストフレーズや例示で指定されたオープンボキャブラリーの概念のすべてのインスタンスを網羅的にセグメント化する能力を導入した点で進歩している。従来のモデルが「人」のような広範囲な概念をセグメント化するのに対し、SAM 3は「赤いストライプの傘」のような、より微妙な概念に対応できる。

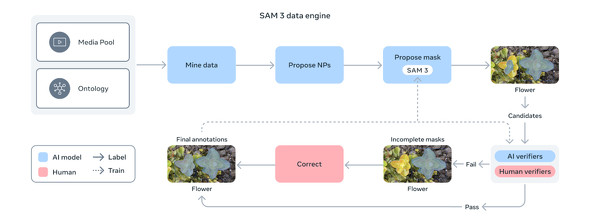

このモデルは、既存のベンチマークよりも50倍以上多い27万のユニークな概念を含むという新ベンチマーク「SA-Co」で、人間のパフォーマンスの75〜80%を達成し、既存システムに比べて2倍の性能向上を示したという。この進歩は、400万以上のユニークな概念を自動的にアノテーションしたデータエンジンによって支えられているという。

これらのモデルの応用として、SAM 3とSAM 3Dは、Facebook Marketplaceの新しい「View in Room」機能を強化しており、ユーザーが購入前に自宅の空間でランプやテーブルなどの家具類のスタイルやフィット感を視覚化できるようにしている。

また、SAM 3は、Instagramの動画作成アプリ「Edits」に間もなく導入される新しいエフェクトを可能にし、クリエイターが動画内の特定の人やオブジェクトにダイナミックなエフェクトを適用できるようにする。

SAM 3は、マルチモーダルLLMのための知覚ツール「SAM 3 Agent」としても利用でき、「手を挙げていない座っている人」などのより複雑なテキストクエリをセグメント化することができる。科学分野では、野生生物モニタリング用の公開ビデオデータセット「SA-FARI」の構築に使用されている。これらのモデルの機能は、誰でも「Segment Anything Playground」で体験できる。

関連記事

MetaチーフAIサイエンティストのルカン博士が辞任し、AI企業立ち上げへ

MetaチーフAIサイエンティストのルカン博士が辞任し、AI企業立ち上げへ

MetaチーフAIサイエンティストのヤン・ルカン博士は、同社を退社して先端機械知能研究(AMI)を継続するためのスタートアップを立ち上げると発表した。新企業は「Metaとパートナーになる」としている。 「Meta AI」との会話、広告のパーソナライズに利用へ

「Meta AI」との会話、広告のパーソナライズに利用へ

Metaは、AIアシスタント「Meta AI」との会話内容を、広告のパーソナライズに利用すると発表した。12月16日から適用する。宗教や性的指向など、一部のセンシティブな話題は対象外にするとしている。 「Meta AI」が「ChatGPT」や「Gemini」同様の単体アプリに

「Meta AI」が「ChatGPT」や「Gemini」同様の単体アプリに

Metaは、これまでInstagramなどで提供していたAIアシスタント「メタAI」を単体アプリとして公開した。日本語にはまだ対応していないが、日本でもApp StoreとGoogle Playストアからダウンロードできる。 Instagram、動画編集アプリ「Edits」を発表 TikTok運営「CapCut」対抗か

Instagram、動画編集アプリ「Edits」を発表 TikTok運営「CapCut」対抗か

米Metaが運営する「Instagram」から動画編集アプリが登場する。Instagram責任者のアダム・モッセーリ氏がThreadsなどにポストした投稿によると、アプリ名は「Edits」と呼ばれており、単なる動画編集アプリではなく総合的なクリエイティブツールになるという。明言はしていないが「TikTok」を運営する中国ByteDance製アプリ「CapCut」の対抗になると見られる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.