LINEヤフー、日本語マルチモーダル基盤モデル「clip-japanese-base-v2」を開発 商用利用もOK

» 2025年12月18日 18時52分 公開

[松浦立樹,ITmedia]

LINEヤフーは12月18日、日本語マルチモーダル基盤モデル「clip-japanese-base-v2」を開発したと発表した。前モデル「clip-japanese-base」から、学習データと学習方法を改善することによって高性能化したモデル。商用利用可能なライセンス「Apache-2.0」のもと、同社のHugging Faceページで公開中だ。

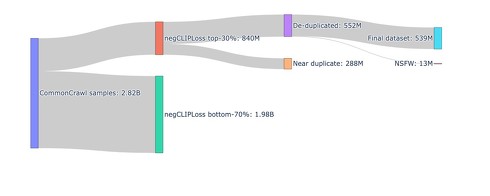

LINEヤフーの研究チームが今回着目したのは、学習データと学習方法だ。clip-japanese-baseでは、データセット「Common Crawl」の10億件分の画像データを収集していたが、v2モデルではこれを28億件まで増加。またデータのフィルタリングも改善し、データ内のノイズを取り除き、データ品質の向上にも努めた。最終的には5億4000万件の高品質な画像・テキストペアを学習データとして使用した(前モデルは約2億件)。

学習方法については、新たに知識蒸留(教師モデルの出力を生徒モデルに模倣させることで、新たなモデルを開発する手法)による高精度化にも取り組んだ。こうして構築したv2モデルと、4種類の日本語CLIPモデルと性能比較したところ、v2モデルはほとんどのベンチマークでもっとも高い性能を記録した。

LINEヤフーは、v2モデルを使用しての意見や感想を募っており、より多くの人に使ってほしいと案内している。

関連記事

“目”を持つAIの新モデル「Sarashina2.2-Vision-3B」、SB Intuitionsが開発 MITライセンスで公開

“目”を持つAIの新モデル「Sarashina2.2-Vision-3B」、SB Intuitionsが開発 MITライセンスで公開

ソフトバンクの子会社でAIの研究開発などを手掛けるSB Intuitionsは、大規模視覚言語モデル(VLM)「Sarashina2.2-Vision-3B」を開発した。その性能は、同サイズ帯で日本語ベンチマークでのトップクラスのスコアを達成したという。 中国DeepSeekから新LLM「V3.2-Speciale」 「GPT-5超え、Gemini-3.0-Proに匹敵」うたう

中国DeepSeekから新LLM「V3.2-Speciale」 「GPT-5超え、Gemini-3.0-Proに匹敵」うたう

AIスタートアップの中国DeepSeekが、新しい大規模言語モデル(LLM)として、10月に発表した「DeepSeek-V3.2-Exp」の後継版「DeepSeek-V3.2」と、その高性能版「DeepSeek-V3.2-Speciale」をHugging Faceで公開した。 富士通、LLMの軽量化技術を発表 1ビット量子化でも約9割の精度を維持 3倍に高速化も

富士通、LLMの軽量化技術を発表 1ビット量子化でも約9割の精度を維持 3倍に高速化も

富士通は、大規模言語モデル(LLM)を軽量化・省電力化する技術「生成AI再構成技術」を開発したと発表した。 NVIDIA、日本語データセットを公開 日本文化など反映した合成ペルソナ600万件 商用利用も可能

NVIDIA、日本語データセットを公開 日本文化など反映した合成ペルソナ600万件 商用利用も可能

米NVIDIAは、日本語の合成データセット「Nemotron-Personas-Japan」を、Hugging Face上で公開した。ライセンスは、商用利用も可能な「CC BY 4.0」。 OpenAI、オープンなAIモデル「gpt-oss」発表 性能は“o4-mini”に匹敵 軽量版含む2種類を公開

OpenAI、オープンなAIモデル「gpt-oss」発表 性能は“o4-mini”に匹敵 軽量版含む2種類を公開

米OpenAIは、オープンウェイトのAIモデル「gpt-oss」を発表した。データセンターやハイエンドPC向けの大規模モデル「gpt-oss-120b」と一般向けのPCでも稼働する中規模モデル「gpt-oss-20b」の2種類を公開している。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

SpecialPR

アイティメディアからのお知らせ

SpecialPR