“目”を持つAIの新モデル「Sarashina2.2-Vision-3B」、SB Intuitionsが開発 MITライセンスで公開

» 2025年11月25日 18時35分 公開

[松浦立樹,ITmedia]

ソフトバンクの子会社でAIの研究開発などを手掛けるSB Intuitions(東京都港区)は11月25日、大規模視覚言語モデル(VLM)「Sarashina2.2-Vision-3B」を開発した。その性能は、同サイズ帯での日本語ベンチマークでトップクラスのスコアを達成したという。同社はMITライセンスのもとで、このAIモデルを公開中だ。

SB Intuitionsでは今回、LLM「Sarashina2.2-3B-Instruct」をベースにVLMを開発。多くの日本語圏のデータを学習に使用したことで、日本の文化・地理知識に詳しいAIモデルになった。例えば、日本の重要有形民俗文化財である「かずら橋」の画像について、「これはどんな橋ですか?」と質問すると、その特徴や見どころなどを解説してくれる。

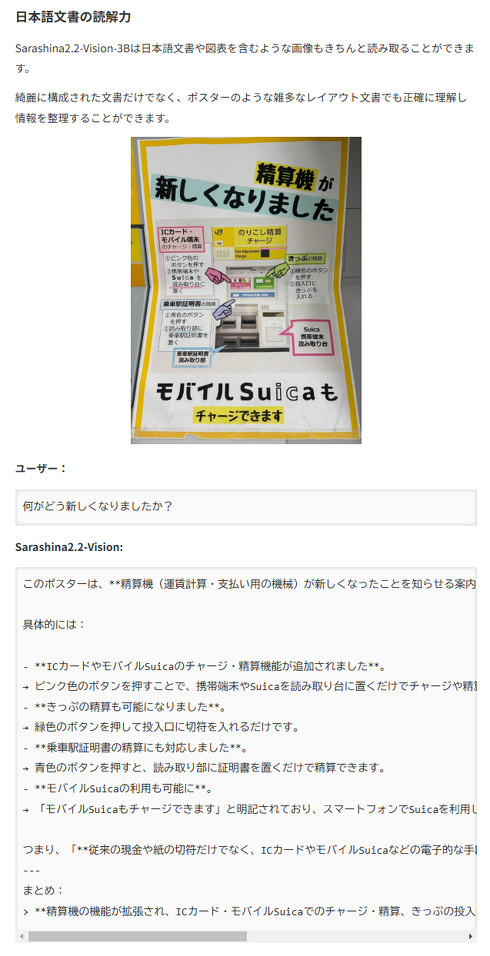

他にも、日本語文書や図表を含む画像の読み取り精度も向上。ポスターのような雑多なレイアウトの文書でも正確に理解し、情報を整理することが可能となった。他にも、文書中の英語の部分だけを読み取って和訳するなど、より現実の利用例に沿うような複雑な指示にも対応できる。

このVLMは、SB IntuitionsのHugging Face上のページで公開中だ。他にも同社のテックブログで、このVLMのモデル構成や各ベンチマークの評価結果なども掲載している。

関連記事

日本語に強いVLM「Sarashina2-Vision」 ソフトバンクのAI開発企業が公開 MITライセンスで商用利用OK

日本語に強いVLM「Sarashina2-Vision」 ソフトバンクのAI開発企業が公開 MITライセンスで商用利用OK

ソフトバンクの子会社でAIの研究開発などを手掛けるSB Intuitionsは、日本語に強い大規模視覚言語モデル(VLM)「Sarashina2-Vision(8B・14B)」を公開した。 “目”を持つAI「VLM」のまとめ資料、ソフトバンクのAI開発企業が公開 基礎やトレンドを全95ページで紹介

“目”を持つAI「VLM」のまとめ資料、ソフトバンクのAI開発企業が公開 基礎やトレンドを全95ページで紹介

ソフトバンクの子会社でAIの研究開発などを手掛けるSB Intuitionsは、大規模視覚言語モデル(VLM)の基礎などをまとめた資料「大規模視覚言語モデルの開発」を無料公開した。 “目を持つAI”は「犬がいる/いない」を区別できない? 否定表現を無視する傾向、OpenAIの研究者らが発表

“目を持つAI”は「犬がいる/いない」を区別できない? 否定表現を無視する傾向、OpenAIの研究者らが発表

米MITや米OpenAIなどに所属する研究者らは、最新の視覚・言語モデル(VLM)が「no」や「not」といった否定表現を理解する能力に深刻な欠陥があることを発見した研究報告を発表した。 LLMの開発効率化に革新? 中国DeepSeekが「DeepSeek-OCR」発表 “テキストを画像化”でデータ圧縮

LLMの開発効率化に革新? 中国DeepSeekが「DeepSeek-OCR」発表 “テキストを画像化”でデータ圧縮

中国のDeepSeek-AIに所属する研究者らは、本や画像などをスキャンして書いてある文字をデジタルテキストデータに変換するOCR(光学文字認識)を用い、長文を画像に圧縮する技術を発表した。 Googleの「Gemini」に、ロボット向け新モデル 自律的にタスクを分解して動作、“雑な指示”にも対応

Googleの「Gemini」に、ロボット向け新モデル 自律的にタスクを分解して動作、“雑な指示”にも対応

米Googleは、ロボット向けのAIモデル「Gemini Robotics 1.5」と「Gemini Robotics-ER 1.5」を発表した。複雑な手順が必要なタスクに対し、自律的にタスクを分解してロボットを駆動できるという。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

SpecialPR

アイティメディアからのお知らせ

SpecialPR