“目を持つAI”は「犬がいる/いない」を区別できない? 否定表現を無視する傾向、OpenAIの研究者らが発表:Innovative Tech(AI+)

Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

米MITや米OpenAIなどに所属する研究者らが発表した論文「Vision-Language Models Do Not Understand Negation」は、最新の視覚・言語モデル(VLM)が「no」や「not」といった否定表現を理解する能力に深刻な欠陥があることを発見した研究報告だ。

研究チームは、視覚・言語モデルの否定理解能力を体系的に評価するために「NegBench」という新しいベンチマークを開発した。このベンチマークは、画像や動画、医療データセットにまたがる18種類のタスクと7万9千以上のサンプルを含み、2つの主要タスクから構成される。

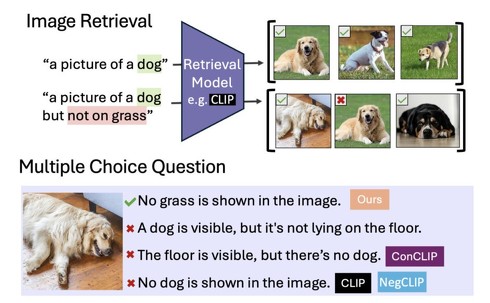

1つ目は「Retrieval-Neg」と呼ばれる、キャプション否定表現を含む画像探索タスクで、モデルは「窓のない建物」「人のいないビーチの画像」などの条件に合致する画像を検索する。2つ目は「MCQ-Neg」と呼ばれる選択問題で、モデルは画像に対する正しい記述を選ぶ際に否定表現を正確に理解する必要がある。

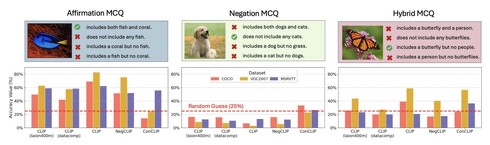

評価の結果、CLIPをはじめとする現代の視覚・言語モデルは否定理解において深刻な問題を抱えていることが判明した。多くのモデルは否定を含む多肢選択問題でランダム回答程度の精度しか示さなかった。

特に注目すべきは、モデルサイズをViT-B/32(8600万パラメータ)からViT-L/14(3億700万パラメータ)、ViT-H/14(6億3200万パラメータ)にスケールアップしても否定理解が向上しなかった。また最新のSigLIP(ViT-L/14)やAIMV2(LiT)といった発展的なモデルを使用しても、この問題は改善されなかった。

さらに詳細な分析により、これらのモデルが「肯定バイアス」と呼ばれる傾向を持つことが明らかになった。肯定バイアスとは、AIが文章中の「〜ない」という否定的な単語のみを無視してしまうことを指す。

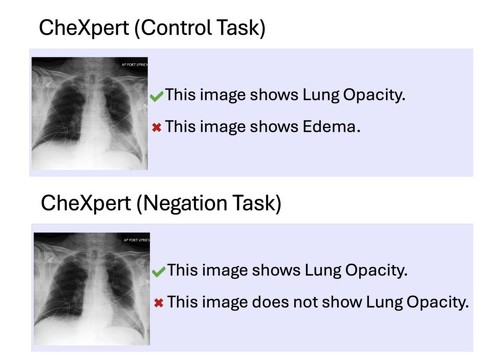

例えば、CLIPベースのモデルは「画像に犬がいる」と「画像に犬がいない」を区別できず、否定を表す単語を実質的に無視する傾向がある。また、医療画像の解釈においても同様の問題が観察され、BioMedCLIPやCONCHといった医療特化型モデルでも「肺不透明性がある」と「肺不透明性がない」の区別において大幅な性能低下が見られた。これは胸部X線写真やCTスキャンなどの画像診断の精度に直結する重大な問題である。

この問題に対処するため、研究チームは大規模な合成データセットを作成し、否定理解を向上させるデータ中心のアプローチを提案した。CC12M-NegCapとCC12M-NegMCQという2つのデータセットを生成し、これらを用いてCLIPモデルをファインチューニングした。結果、否定を含むクエリでのリコールが10%向上し、否定キャプションを含む多肢選択問題の精度が約28%向上した。

Source and Image Credits: Alhamoud, Kumail, et al. “Vision-language models do not understand negation.” arXiv preprint arXiv:2501.09425(2025).

関連記事

Sakana AI、“査読通過”した論文執筆AIシステムをオープンソース化 機能を解説する資料も公開

Sakana AI、“査読通過”した論文執筆AIシステムをオープンソース化 機能を解説する資料も公開

Sakana AIは、論文執筆AIシステム「The AI Scientist-v2」をオープンソース化し、その機能を解説した資料を公開した。 日本語に強いVLM「Sarashina2-Vision」 ソフトバンクのAI開発企業が公開 MITライセンスで商用利用OK

日本語に強いVLM「Sarashina2-Vision」 ソフトバンクのAI開発企業が公開 MITライセンスで商用利用OK

ソフトバンクの子会社でAIの研究開発などを手掛けるSB Intuitionsは、日本語に強い大規模視覚言語モデル(VLM)「Sarashina2-Vision(8B・14B)」を公開した。 Sakana AI、複数の画像を扱える“日本語視覚言語モデル”公開 非英語圏での先駆けに

Sakana AI、複数の画像を扱える“日本語視覚言語モデル”公開 非英語圏での先駆けに

AIスタートアップのSakana AIは、複数の画像について日本語で質疑応答できるAIモデル「Llama-3-EvoVLM-JP-v2」を発表した。 サイバーエージェント、新たな日本語特化LLMを一般公開 「Llama-3-70B」と同等の日本語能力 商用利用も可

サイバーエージェント、新たな日本語特化LLMを一般公開 「Llama-3-70B」と同等の日本語能力 商用利用も可

サイバーエージェントは、大規模言語モデル(LLM)「CyberAgentLM3」を一般公開した。225億パラメータの日本語AIモデルで、既存モデルをベースに使わずスクラッチで開発した。 会話中、相手の“ウソ”をこっそり教えてくれるスマートウォッチ AIが瞬時にファクトチェック

会話中、相手の“ウソ”をこっそり教えてくれるスマートウォッチ AIが瞬時にファクトチェック

ニュージーランドのオークランド大学やシンガポール国立大学に所属する研究者らは、日常会話の中で事実と虚偽を瞬時に判別するスマートウォッチを提案した研究報告だ。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.