Google、「Gemma 3」ベースの翻訳特化モデル「TranslateGemma」公開 日本語含む55言語に対応

» 2026年01月16日 10時32分 公開

[ITmedia]

米Googleは1月15日(現地時間)、オープンなAIモデル「Gemma 3」をベースにした翻訳特化モデル群「TranslateGemma」を発表した。高品質な翻訳を、より小さなモデルサイズで実現することを狙ったオープン翻訳モデルの新しいスイートと位置付けている。日本語を含む55言語をサポートし、4B、12B、27Bの3サイズを用意した。

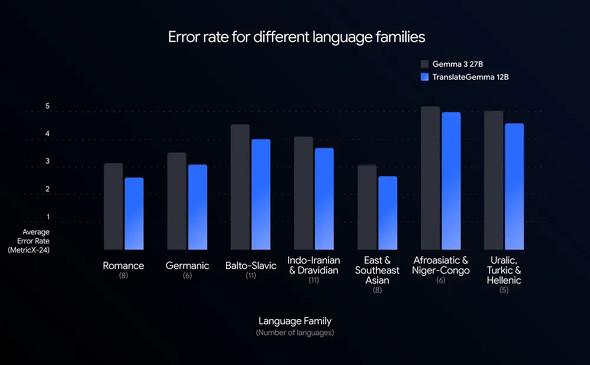

翻訳エラーを追跡する指標である「MetricX」を用いて品質を測定(スコアが低いほど高精度)したところ、12B TranslateGemmaのスコアは3.60で、27BのGemma 3ベースモデルの4.04を上回った。同じサイズのGemma 3の12Bベースモデルと比較すると、エラー率は約26%低下した。

特徴の1つは、Gemma 3が持つマルチモーダル能力を維持している点だ。テキスト翻訳の改善が画像内テキストの翻訳精度向上にも寄与しており、マルチモーダル翻訳ベンチマーク「Vistra」では、既存のオープンモデルを上回る性能を示したとしている。

研究者や開発者が自前の環境やクラウドでのデプロイを想定しており、用途に応じてモデルサイズを選べる。4Bはモバイルやエッジ向け、12Bはコンシューマ向けノートPCでのローカル実行を想定し、27Bは米NVIDIAのGPU「H100」や自社の「TPU」搭載のクラウドで実行できる「最大忠実度」モデルという。KaggleとHugging Faceで入手できる他、Google CloudのAI開発基盤「Vertex AI」上での利用にも対応する。

関連記事

Google翻訳、会話を“リアルタイムでAI翻訳”する新機能 米国などで先行提供

Google翻訳、会話を“リアルタイムでAI翻訳”する新機能 米国などで先行提供

米Googleは8月26日(現地時間)、アプリ「Google Translate(Google翻訳)」に会話をリアルタイムで翻訳できる新機能を追加したと発表した。AIモデル「Gemini」を活用したもので、まずは米国、インド、メキシコのユーザー向けに提供を始めた。 Google、“超小型”AIモデル「Gemma 3 270M」公開 スマホで動き、省電力性能に優れる

Google、“超小型”AIモデル「Gemma 3 270M」公開 スマホで動き、省電力性能に優れる

米Googleは、2億7000万パラメータの小型AIモデル「Gemma 3 270M」を公開した。エッジデバイス向けで、マルチモーダルに対応。省電力性能に優れるという。 Googleが軽量AIモデル「Gemma 3n」を発表 スマホ上で高性能マルチモーダルAI Claude 3.7 Sonnetに肉薄

Googleが軽量AIモデル「Gemma 3n」を発表 スマホ上で高性能マルチモーダルAI Claude 3.7 Sonnetに肉薄

米Googleが、モバイルデバイス向けの新しいAIモデル「Gemma 3n」を発表した。スマートフォンやタブレットなどのモバイルデバイス上で直接動作する高性能なマルチモーダルAIで、テキスト、画像、音声、動画を理解・処理できる能力を備える。 Google、オープンなAIモデル「Gemma 3」リリース マルチモーダル対応 モデルサイズは4種類

Google、オープンなAIモデル「Gemma 3」リリース マルチモーダル対応 モデルサイズは4種類

米Googleは、オープンな大規模言語モデル「Gemma 3」をリリースした。新しくマルチモーダルに対応。軽量かつ高性能をうたっており、スマートフォンやノートPCなどエッジデバイス上でも動作するという。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

SpecialPR

アイティメディアからのお知らせ

SpecialPR