KDDI傘下のELYZA、日本語特化の「拡散言語モデル」公開 商用利用も可

KDDIの子会社で、AIを研究開発するELYZA(東京都文京区)は1月16日、日本語に特化した拡散大規模言語モデル(dLLM)「ELYZA-LLM-Diffusion」シリーズを公開した。dLLMは、主に画像生成AIで使われる拡散モデルを言語生成に活用したもの。同シリーズはHugging Faceで公開しており、商用利用もできる。

一般的に言語生成で使われる自己回帰モデルはテキストを冒頭から順に出力する一方、dLLMはテキスト全体を扱いながら出力する。処理の回数を減らして推論を効率化できるため、テキストの生成速度を上げられるほか、将来的にはAIによる電力消費の低減を期待できる。

そこでELYZAは、電力効率の良い日本語LLM実現に向けた取り組みの一環として、KDDIのGPU基盤を利用し、ELYZA-LLM-Diffusionシリーズを開発した。中国の香港大学が公開しているdLLM「Dream-v0-Instruct-7B」に、約620億トークンの日本語データを学習させて「ELYZA-Diffusion-Base-1.0-Dream-7B」を開発。同モデルに特定のタスクの精度を高める指示学習を実施して「ELYZA-Diffusion-Instruct-1.0-Dream-7B」も開発した。

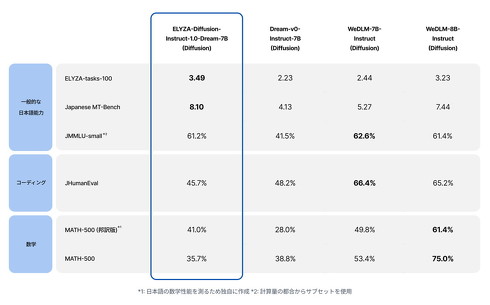

ELYZAによると、ELYZA-Diffusion-Instruct-1.0-Dream-7Bは、ベースとなったDream-v0-Instruct-7Bや、中国Tencentが公開するdLLM「WeDLM-7B-Instruct(Diffusion)」などに比べ、高い日本語性能を示したという。一方、コーディングや数学を解く一部のタスクでは、他のモデルの性能に及ばなかったとしている。

ELYZA-Diffusion-Base-1.0-Dream-7Bと、ELYZA-Diffusion-Instruct-1.0-Dream-7Bは共にHugging Faceで公開しており、商用利用もできる。また、チャットAIのUIを模したデモも公開している。

関連記事

“複雑な思考ができるAI”、ELYZAが公開 性能は「o1-mini」に匹敵、商用利用も可能 「非リーズニングモデルから開発」

“複雑な思考ができるAI”、ELYZAが公開 性能は「o1-mini」に匹敵、商用利用も可能 「非リーズニングモデルから開発」

東大発のAIベンチャーELYZAは、新たなAIモデル「ELYZA-Thinking-1.0-Qwen-32B」を公開した。米OpenAIのAIモデル「o1」「o3」シリーズのような、推論性能に優れているのが特徴だ。 国内最大規模のコールセンター事業に生成AI 東大発AIベンチャー・ELYZAが協力 専用LLMを共同開発

国内最大規模のコールセンター事業に生成AI 東大発AIベンチャー・ELYZAが協力 専用LLMを共同開発

東大発のAIベンチャーELYZAとアルティウスリンクは、生成AI分野での協業を始めたと発表した。 “GPT-4超え性能”の日本語特化型LLM AIスタートアップ・ELYZAが開発 国外プレイヤーとの競争も「諦めない」

“GPT-4超え性能”の日本語特化型LLM AIスタートアップ・ELYZAが開発 国外プレイヤーとの競争も「諦めない」

東大発のAIスタートアップ企業であるELYZAは、GPT-4を超える性能を持つ日本語特化型の大規模言語モデル(LLM)「Llama-3-ELYZA-JP-70B」を開発したと発表した。 国産LLMが抱える“開発コスト”の課題 海外勢に安さで勝てるか、ELYZA代表の危機感

国産LLMが抱える“開発コスト”の課題 海外勢に安さで勝てるか、ELYZA代表の危機感

ELYZAは、「GPT-3.5やGeminiに匹敵する」という日本語特化型LLMを発表した。同社の曾根岡代表は「今回のニュースは日本国内の状況を踏まえると本当に喜ばしいこと」と語る一方、国内のLLM開発ビジネスにおいて“資金面”が大きな課題であると指摘する。 Metaの生成AI担当者が来日 Llamaが「オープンモデル」にこだわる理由を語る

Metaの生成AI担当者が来日 Llamaが「オープンモデル」にこだわる理由を語る

「Llamaのミッションは全ての人にオープンインテリジェンスを届けること」――Metaで大規模言語モデル(LLM)の「Llama」を担当するマノアール・パルーリさんが来日し、報道陣にオープンモデルであるLlamaの狙いと展望について語った。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.