「リベンジポルノ」にもAI 新技術との正しい距離感は? 各国のAI政策と規制のいま:よくわかる人工知能の基礎知識(4/5 ページ)

人材育成は、研究者の育成と企業で働く実務者の育成という2つの側面がある。前者は前述の基礎・応用研究の支援という枠組みの中で進められるケースが多い。さまざまな分野でAIを普及させたいなら、研究者の数をはるかに上回る規模の実務者が必要だ。

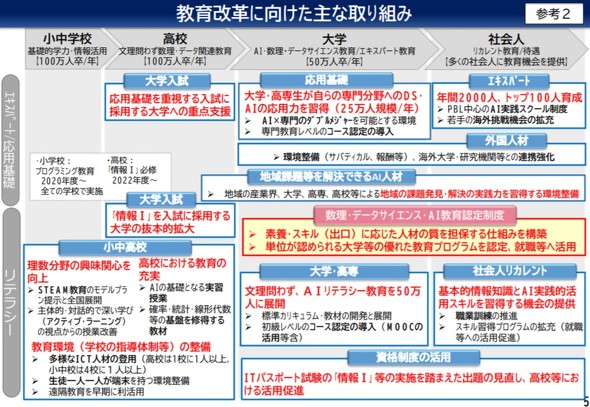

日本のAI戦略2019では、人材育成の提言もある。例えば「教育改革」と題されたセクションで「多くの社会人(約100万人/年)が、基本的情報知識と、データサイエンス・AI等の実践的活用スキルを習得できる機会をあらゆる手段を用いて提供」「地域課題等の解決ができるAI人材を育成(社会人目標約100万人/年)」という目標を立てている。実現可能性はさておき、いずれも年間100万人単位での育成を掲げている。

次にAIの規制とその緩和について。これにはさまざまな可能性が考えられる。プライバシーや個人情報保護に関する施策ではデータの収集や利用を制限するだろうし、医療行為など命に関わる分野についてはAIアプリの利用を制限する場面もあるだろう。

新しいテクノロジーが登場したとき、その存在を想定していない古い法規制が実質的なハードルになることはこれまでも繰り返されてきた。AIにおいても規制緩和は必要になってくるはずだ。

例えば米トランプ政権は、2018年5月にGoogleやFacebookなど40社以上のテクノロジー企業を集めて、AI研究に関する規制緩和を進めると約束した。英政府は、2017年11月に自動運転車に関する規制緩和の方針を示している。このように一種の産業政策として、特定分野における規制の撤廃が進められている現状がある。

「ガイドラインの整備」にも注目

AI活用に向けた政策の裏で、各国政府はガイドラインの整備にも力を入れている。

世間では、「AIが人間の雇用を奪うのではないか」「想定外の事故を引き起こすのではないか」「監視目的にAIが悪用されるのではないか」などの声が根強い。こうした不安にこたえる形で、研究者や企業が自主規制するケースが出てきているのだ。

ガイドラインの多くは拘束力のある法規制ではなく、単に政府の姿勢を表したものに過ぎないことが多い。それでも「AIに求められること」「AIがすべきでないこと」を明確に示すのは重要だ。

例えばオーストラリアの産業イノベーション科学省は、2019年4月に「豪州AI倫理フレームワーク」(Australia's Ethics Framework)案を発表し、5月末まで意見募集を行った。名前の通り、これは政府や企業がAIを活用する際の倫理原則を定めたものだ。

具体的には、(1)純利益を生み出すこと、(2)人々に危害を与えないこと、(3)規制および法令を順守すること、(4)プライバシーを保護すること、(5)公平であること(差別をしない)、(6)透明性と説明可能性を実現すること、(7)(AIが自分に重大な影響を及ぼす行動をした際に)異議の申し立てができること、(8)(AIの開発と実装をする人たちが)説明責任を果たすこと――という原則を掲げる。

またAIの影響評価やレビュープロセス、問題発生時の申し立てのプロセスなど、原則を実行に移す際に求められる手続きのあり方も提案している。

日本でも、2019年3月に統合イノベーション戦略推進会議が「人間中心のAI社会原則」(PDF)を定めた。

この中では、社会(特に国などの立法・行政機関)が留意すべき基本原則として、(1)人間中心の原則、(2)教育・リテラシーの原則、(3)プライバシー確保の原則、(4)セキュリティ確保の原則、(5)公正競争確保の原則、(6)公平性、説明責任、及び透明性の原則、(7)イノベーションの原則――が挙がっている。

こうしたガイドラインがあれば、企業も具体的な対策をとれるなどのメリットがある。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR