読唇術で音声入力 スマホで口パクを自撮りし音声に変換「LipType」:Innovative Tech

Innovative Tech:

このコーナーでは、テクノロジーの最新研究を紹介するWebメディア「Seamless」を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

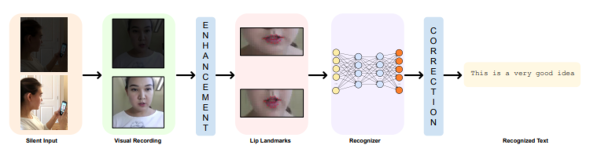

米カリフォルニア大学マーセド校の研究チームが開発した「LipType」は、音のない口パク映像を音声に変換する、深層学習を用いた読唇システムだ。スマートフォンのインカメラで口パクを自撮りして、話者の唇の動きを読み取る。

音声認識は、周囲が騒がしい場合には信頼性が低く、図書館や電車内などではプライバシーやセキュリティが損なわれる。声が出せない障害のある人はそもそも音声認識が使えない。

解決策としては、口パクのような無声発話による音声入力が挙げられる。無声発話時に動く顎の動きを捉えて音声に変換するものや、無声発話時に顎の下に設置したセンサーから皮膚が変動する顎運動と舌筋の運動を計測し音声に変換するものなど、さまざまな角度から研究されている。

今回の手法では、唇の動きだけの音声なし映像を、意図した音声に変換する。既存の深層学習読唇モデル「LipNet」を最適化して速度と精度を向上させ、照明条件が悪い状況でも処理が行える修復モデルを開発し組み合わせた。

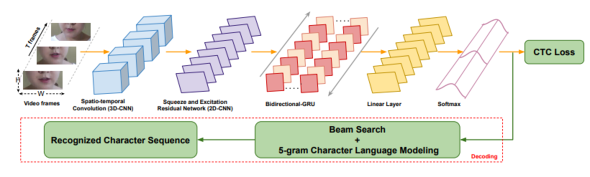

読唇モデルは、エンドツーエンドの深層学習ネットワークを用い、唇の配列を自動的に分割しテキストに分類。唇が映るビデオフレームのシーケンスを受け取りフレームごとに特徴ベクトルを出力するモジュールと、フレームごとの特徴ベクトルのシーケンスから1文字ずつ出力するモジュールの2段階で構成する。

データセットには発話しているときの人の顔で構成する短いビデオクリップ、訓練用2万1635本、テスト用7140本を用いた。学習したモデルを比較した結果、入力速度、精度、計算時間のいずれにおいても、LipTypeがLipNetを上回ったという。

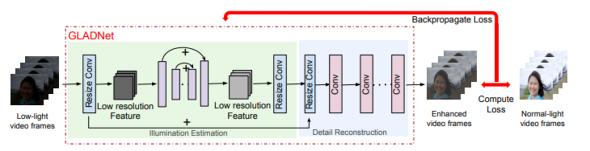

修正モデルは、入力映像の照明条件の悪さと認識における潜在的なエラーを考慮した複数段階にわたるパイプラインで、照明条件の悪い映像を補正する前処理ステップと、潜在的なエラーを自動的に検出・修正する後処理ステップを含む。

この修正モデルはLipType以外の音声認識モデルにも適応できるのが特徴。主要な音声認識モデルで試したところ、全てのモデルのエラー率を大幅に低減したという。

関連記事

背面からジェスチャー操作できる半透明黒板ディスプレイ「HoloBoard」 Lenovoなど開発

背面からジェスチャー操作できる半透明黒板ディスプレイ「HoloBoard」 Lenovoなど開発

教師はHTC Viveコントローラーでジェスチャー操作できる。 スマホゲームで手指のしびれを早期発見 東京医科歯科大と慶應大が研究

スマホゲームで手指のしびれを早期発見 東京医科歯科大と慶應大が研究

手根管症候群を早期発見するために、スマホゲームを利用する。 “iPhoneを手持ちで自撮りするだけ”の全身モーションキャプチャー センサーをフルに使い全身姿勢をリアルタイム推定

“iPhoneを手持ちで自撮りするだけ”の全身モーションキャプチャー センサーをフルに使い全身姿勢をリアルタイム推定

カーネギーメロン大学が開発したモーションキャプチャーは、iPhoneだけで、外部カメラやセンサーも必要としない。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR