なぜ人々は、ChatGPTという“トリック"に振り回されるのか? Google「Bard」参戦、チャットAI戦争の行方:清水亮の「世界を変えるAI」(6/8 ページ)

イライザとChatGPTの「トリック」はどう違うのか?

イライザ、およびイライザの延長上にあるチャットボットを体験した今の世代だからこそ、ChatGPTは頭ひとつ飛び抜けたものに見えているのは無理もない。

特にChatGPTは、聞いた側が知らないことまですらすらと答えてくれる。しかし多くの人が指摘しているように、ChatGPTも、おそらくGoogleのBardも、それ以外の似たようなものも、根本的には「決して答えが信用できるというわけではない」という問題をはらんでいる。

あまり専門的になると難しい話になってしまうので、まずはなぜChatGPTが「こちらが知らないことまで答えてくれるのか」というトリックを解き明かしてみよう。

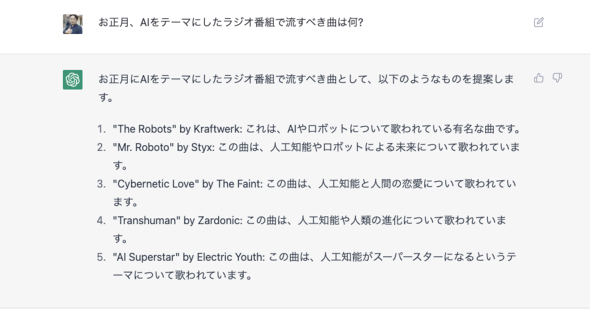

例えば、筆者が出演した今年の元旦のニッポン放送のラジオ番組「生放送!AIくんと遊ぼう」で、ChatGPTに「お正月の人工知能をテーマにしたラジオ番組で流すべき曲は?」と聞くと、こんな答えが返ってきた。

これを見て筆者は「はーなるほどね」と思ったのだが、横で見ていた放送作家の方がすごく驚いていた。「AIと聞いたのにロボットの曲が返ってくるとか、凄すぎないですか?」

そうなのだ。これが「トリック」の正体である。

人間が驚くとき、というのは、「あまり関係性を意識していなかったけど、もともとは知っていた複数の概念が、なにかのきっかけで結びつくとき」である。この放送作家の先生でいえば、「AIとロボット」はまったく別の概念として捉えられており、その関係性を示されたことでびっくりした、いわば「AHA体験」につながった。

しかし、原理を知っていると、これはそれほど驚くべきことではないことが分かる。

まず、AIの学習方法について。GPT3のような自然言語系のAIの学習方法は、大量の文章を読むことである。大量の文章を読むと、そこに一緒に現れる単語は、「近い概念」として学習される。例えば「りんご」を説明する文章には「赤い」という言葉と一緒に現れる頻度が高い。

「AI」という言葉と「ロボット」という言葉が一緒に現れる頻度が高いのは、AIの研究者にとっては当然だが、専門外の人にとっては全く別のものと考えている人もいる。例えば「ドラえもん」をAIだと思っている人は少ない。

ChatGPTを含む、最近の深層学習チャットボットのトリックの大部分は、この「知らないはずのことを知っていた!」という驚きである。人間が聞いて納得するような関係性ならば、その単語は必ず一緒に出てくるはずので、これは全く驚くべきことではない。むしろ、原理に忠実に考えると当然そのようになるはずなのだ。

次の驚きは、「同じ答えを返さない」または「同じことを別の表現で言い換えられる」ということ。

深層学習系チャットボットは、文章を生成するときに、「この単語の次に出てきそうな単語はどれ?」というのをランダムに選択する。だから、同じセリフを二度返すことが少ない。これは従来のAIML的なチャットボットにはできなかった芸当で、これで人は勝手に「知性がある!」と感じ取ってしまう。

しかし、実際には「確率的に意味が通りそうなランダムな言葉の候補を取ってきているだけ」なので、別に内容を理解しているというわけでは全くない。ChatGPTが「それっぽいことを言うだけの実は何も考えてない人」みたいな回答をするのがそれが原因だ。

実際に何も考えていないのだから。

関連記事

有能な秘書か、大ぼら吹きか 「ChatGPT」をスプレッドシートで使えるアドオンを試してみた

有能な秘書か、大ぼら吹きか 「ChatGPT」をスプレッドシートで使えるアドオンを試してみた

ビジネスツールであるスプレッドシートからChatGPTが呼び出せると、景色はちょっと変わる。行列の見出しを入力するだけで、自動で無限に欲しい情報が手に入る。 GoogleのChatGPT競合「Bard」のデモ回答に誤り──天文学者らが指摘

GoogleのChatGPT競合「Bard」のデモ回答に誤り──天文学者らが指摘

Googleが発表したChatGPT競合の会話型AIサービス「Bard」の発表時に披露したサンプル回答に誤りがあったと複数の専門家が指摘した。太陽系外惑星の画像をとらえたのはジェームズ・ウェッブ宇宙望遠鏡が初という部分だ。 日本を画像生成AIで再現する 「自分の見た景色」を学習したAIは強力な思い出再生装置に

日本を画像生成AIで再現する 「自分の見た景色」を学習したAIは強力な思い出再生装置に

AIで漫画を書こうとするとひとつ不便なことがある。StableDiffusionの元になっている学習データは「全世界」の画像を使っているので、日本人がイメージするような「郵便局」とはまったく異なるイメージになってしまう。そこで街のあちこちの景色を写真に撮った。これをAIに学習させて、独自の日本的な画像生成AIを作ろうというのだ。 会話で検索できる「新しいBing」、Microsoftがプレビュー公開 ChatGPT開発元の次世代モデル採用

会話で検索できる「新しいBing」、Microsoftがプレビュー公開 ChatGPT開発元の次世代モデル採用

MicrosoftはOpenAIの言語モデル採用の新モデル「Prometheus」採用のチャットbot付き「新しいBing」を発表した。英語版Bingで限定プレビューを試せる。同時に発表の「新しいEdge」には、AIを使って表示内容を要約したり新たなコンテンツ作成を支援する機能も搭載する。 Google、OpenAIの「ChatGPT」競合「Bard」を限定公開

Google、OpenAIの「ChatGPT」競合「Bard」を限定公開

Googleは、「ChatGPT」と競合する“実験的な会話型AIサービス”の「Bard」の提供を開始する。まずは限定公開だが、「向こう数週間中により広く公開する」。また、Google検索にクエリにテキストで答える新AI機能を間もなく追加する。 AIでどこまでできる? 絵心のないプログラマーが「ChatGPT」と「作画AI」でマンガを描いてみた

AIでどこまでできる? 絵心のないプログラマーが「ChatGPT」と「作画AI」でマンガを描いてみた

クリスタにAI作画機能搭載が見送られたと聞いて、なるほどなあと思いつつ、では絵が全く描けない筆者が、AIを使って漫画を書くことはできるのか、実際にやってみることにした。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR