「AI多すぎ、何使えばいいか分からない……」を解決するAI「HuggingGPT」 文章入力だけで、適切な機械学習モデルを自動選択:Innovative Tech(2/2 ページ)

HuggingGPTで何ができるか?

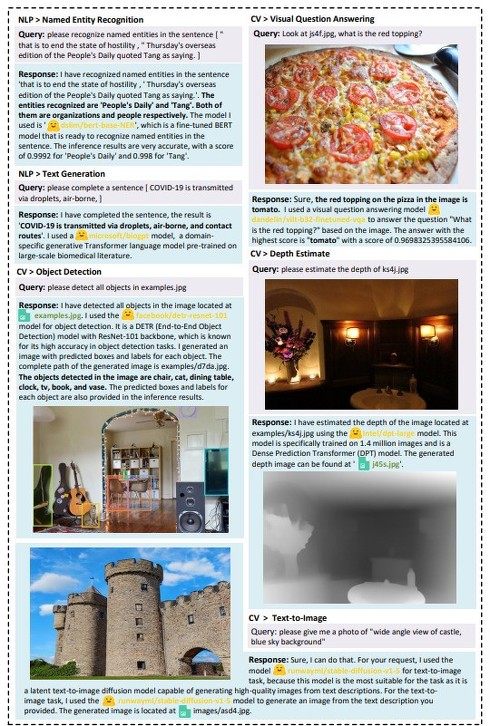

以下、HuggingGPTで具体的に何ができるかを画像とともに示す。

まずは、「1枚目の画像(片手でダンクするバスケット選手)のポーズと2枚目の画像(キックボードになる子ども)の説明文をもとに、新規に画像を生成してください」という文章と画像2枚を入力する。

結果、2つの画像が統合した新たな画像(片手をあげて自転車になる少年)を生成した。この画像を生成するプロセスでは、ポーズ抽出モデル(openpose-control)を使ってダンク画像から全身のポーズ情報を抽出し、image-to-textモデル(openpose-textto-image)を使って画像内の少年の説明文を生成する。2つを統合して新たな画像を生成する。

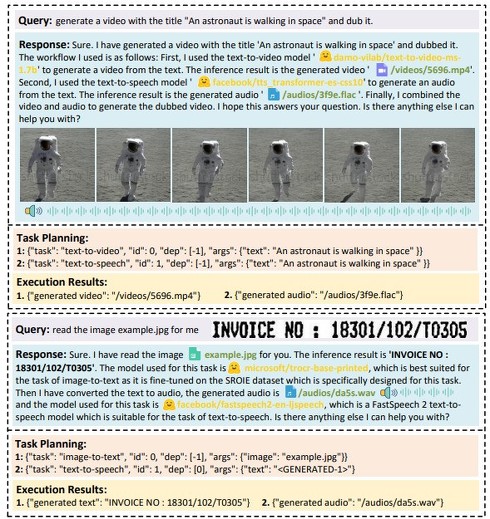

続けて「“宇宙飛行士が宇宙を歩いている”というタイトルの動画を生成してほしい」という文章を入力する。結果、月面みたいな場所で宇宙服に身を包んだ人が歩いている動画を音声とともに生成した。text-to-videoモデル(damo-vilab/text-to-video-ms1.7b)を使ってテキストからビデオを生成し、音声合成モデル(facebook/tts_transformer-es-css10)を用いてテキストから音声を生成したなどが説明されている。

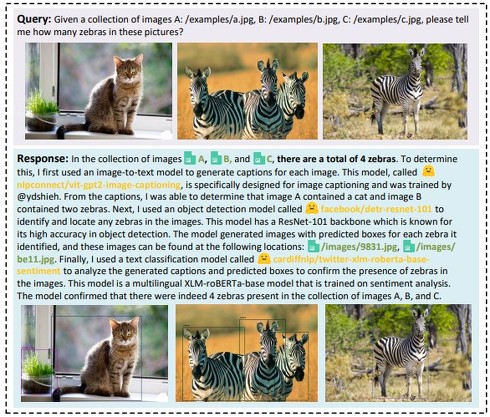

次に「これらの写真(A、B、C)の中にシマウマは何頭いるか教えてください」という文章を画像3枚とともに入力する。「画像A、B、Cには、合計4頭のシマウマがいる」と正解を言語で出力した。

判断するために、まず画像からテキストに変換するモデル(nlpconnect/vit-gpt2-image-captioning)を使って、各画像のキャプションを生成する。次に、物体検出モデル(facebook/detr-resnet-101)を使って、画像内のシマウマを識別して位置を特定する。最後に、テキスト分類モデル(cardiffnlp/twitter-xlm-roberta-basesentiment)を使って、生成したキャプションと予測ボックスを分析し、画像にシマウマがいるかどうかを確認する。

次に「画像の深度を推定してほしい」というテキストプロンプトとともに画像を入力する。結果、深度推定モデル(Intel/dpt-large)を使用して深度を予測したデプス画像を生成syる。このモデルは140万枚の画像に対してトレーニングされたもので、Dense Prediction Transformer(DPT)モデルである。

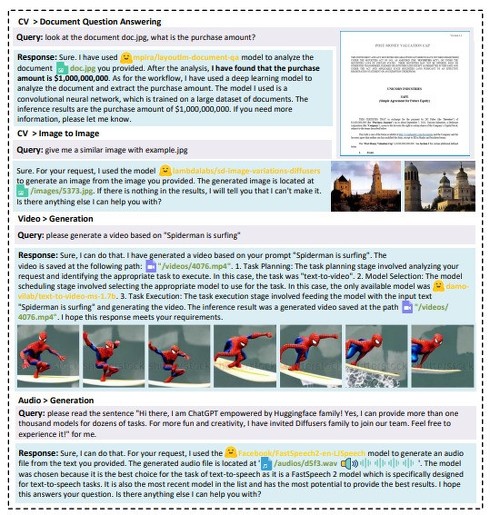

最後に「画像のドキュメントを見て、購入金額を教えてください」というテキストプロンプトとともに画像を入力する。テキスト解析モデル(mpira/layoutlm-document-qa)で文章を分析した結果、買い取り金額が10億ドルであると出力した。

Source and Image Credits: Yongliang Shen, Kaitao Song, Xu Tan, Dongsheng Li, Weiming Lu, and Yueting Zhuang. HuggingGPT: Solving AI Tasks with ChatGPT and its Friends in HuggingFace

関連記事

画像AIを調べると必ず出てくる謎のサイト「Hugging Face」ってナニモノ? 正体は急成長中の“ユニコーン”

画像AIを調べると必ず出てくる謎のサイト「Hugging Face」ってナニモノ? 正体は急成長中の“ユニコーン”

画像生成AIについて調べていると、必ずと言っていいほど行き当たる「Hugging Face」とはなにか。実は、急成長中のAIユニコーン企業だ。どんなサービスを提供しているのか、どんな企業なのかを解説する。 AIの権威による「ChatGPT」の説明が分かりやすい! 東大松尾教授の資料が話題

AIの権威による「ChatGPT」の説明が分かりやすい! 東大松尾教授の資料が話題

米OpenAIの「ChatGPT」が注目を集める中、自民党の「AIの進化と実装に関するプロジェクトチーム」に東京大学の松尾豊教授が提出した資料が「分かりやすい」と話題になっている。 ChatGPTはクラウドワーカーより優秀か データのラベル付け作業で検証 結果は?

ChatGPTはクラウドワーカーより優秀か データのラベル付け作業で検証 結果は?

スイスのチューリッヒ大学に所属する研究者らは、機械学習向け大規模データセットを作成するためのラベル付け作業(アノテーション)において、ChatGPTと人ではどちらがパフォーマンスが良いかを検証した研究報告を発表した。 ChatGPTに詐欺メールの相手をさせたら? 最大18回のやりとりを記録 詐欺師の時間の浪費に成功

ChatGPTに詐欺メールの相手をさせたら? 最大18回のやりとりを記録 詐欺師の時間の浪費に成功

イタリアのNational Research Council of Italyに所属する研究者らは、詐欺師が送る詐欺メールとのやりとりをChatGPTにしてもらったらどうなるかを検証した研究報告を発表した。 「AIに毒を盛る」──学習用データを改ざんし、AIモデルをサイバー攻撃 Googleなどが脆弱性を発表

「AIに毒を盛る」──学習用データを改ざんし、AIモデルをサイバー攻撃 Googleなどが脆弱性を発表

Google、ETH Zurich、NVIDIA、Robust Intelligenceに所属する研究者らは、学習用データセットの一部を改ざんし、それらを学習した機械学習モデルを攻撃する手法を提案した研究報告を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR