“AI合成写真”が秒で AdobeのAIがスゴい、けど……「爆発できない」フェイク対策の是非(2/2 ページ)

進化する“AI偽画像” 「写真が証拠になる時代」は終わるか

AIの進化で、フェイク画像問題はいっそう深刻になりつつある。

2023年5月22日には、「米国防省(ペンタゴン)で爆発があった」とかたる偽の画像が出回り、米株価が一時、大きく下落する騒動があった。この画像は「AI生成では」といわれている。また日本でも昨年の22年9月、静岡県で水害が起きた際、「ドローンで撮影した静岡の水害画像」と称し、画像生成AIで作った偽画像がTwitterで拡散して物議をかもした。

写真にはこれまで、証拠能力が期待されてきた。「ペンタゴンが爆発しているように見える写真は、ペンタゴンが爆発した証拠になる」と思われていたのだ。

だがAIにより、自然な合成画像を、誰でも簡単に生成できる時代が来た。写真は“偽の証拠”、フェイク画像に悪用され、その真正性が疑われる時代が来てしまった。

「爆発しない」Adobeの生成技術

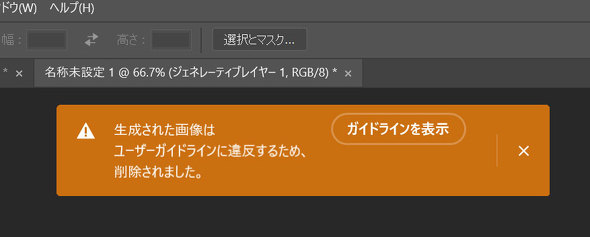

「安全な生成AI」を掲げるAdobeは、「ジェネレーティブ塗りつぶし」にフェイク画像対策を施している。

例えば「ペンタゴンの爆発画像」は、ジェネレーティブ塗りつぶしでは作ることができなかった。「爆発」と入力すると、画像生成が拒否されるからだ。「米国防省(ペンタゴン)」「火災」「煙」などのワードの他、「女性の裸」もNGワードだった。

AdobeのAIユーザーガイドラインによると、「ポルノ素材」「現実世界に害を及ぼす可能性のある、誤解を招く、詐欺的、または欺瞞(ぎまん)的なコンテンツの拡散」「暴力または流血表現」などが違反になるという。

とはいえ、爆発や炎といったイメージは、コンテンツ制作現場で必要とされることも多いだろう。「悪用の可能性が少しでもあれば、機能の提供をやめる」という考え方では、何もできなくなり、ツールそのものの意味がなくなってしまう。

「安全な」AIも重要だが、安全側に倒すほど自由度は狭まる。「問題なく使えるケースも多いが、悪用もできる」コンテンツの生成について、どこで線を引くか。AI生成ツール各社とも、悩んでいると思われる。

生成AIの悪用対策としてAdobeは、「コンテンツ認証機能」も提供している。コンテンツを制作したのが人間かAIか、どのタイミングでAI加工を施したのかなど、コンテンツの来歴情報を、メタデータとして付与できるのだ。ただ、今後すべての画像にこのデータが付くわけではないだろう。

AI生成偽画像が激増していく時代。フェイク画像はますます課題になっていきそうだ。1社のツールが対策していても、別のツールが未対策なら意味が薄い。生成AI全体で、共通の規範やルール、または国際的な法規制が必要になるのかもしれない。

関連記事

アドビの生成AI、β版を一般公開 Adobe IDがあれば無料で使える

アドビの生成AI、β版を一般公開 Adobe IDがあれば無料で使える

米Adobeが同社の生成AI「Adobe Firefly」を一般公開した。無料のAdobe IDさえあればウェイトリストなしで誰でも利用できる。なお、正式版ではなく引き続きβ版としての提供であり、商用目的では利用できないとしている。 AI生成? 「ペンタゴンで爆発」画像で株価下落 Twitterで青バッジアカウント複数が投稿

AI生成? 「ペンタゴンで爆発」画像で株価下落 Twitterで青バッジアカウント複数が投稿

Twitter上で一時「ペンタゴンで爆発があった」とする画像付きツイートが拡散した。この画像はAIによって生成された可能性が高いと指摘された。ツイートは数時間で削除されたが、この影響で株式市場は一時下落した。 迫るエイプリルフール、AI画像があふれる予感……? ネットの“フェイク”との向き合い方は

迫るエイプリルフール、AI画像があふれる予感……? ネットの“フェイク”との向き合い方は

4月が近づき、2023年もエイプリルフールが迫りつつある。一方、22年から急成長を遂げて話題になっている生成AIによる“フェイク”がまん延するのではないかと懸念する声もネット上で話題になっている。 「写真付きフェイクニュース」大量発生時代の幕開けか 静岡水害の“偽画像”問題を考える

「写真付きフェイクニュース」大量発生時代の幕開けか 静岡水害の“偽画像”問題を考える

「ドローンで撮影した静岡県の水害の画像」と称し、画像生成AIで作った偽の水害画像がTwitterで拡散。フェイクニュースにオリジナルの「フェイク画像」を簡単に添付できる時代が到来している。 静岡県の水害巡りフェイク画像が拡散 画像生成AIを利用 投稿者はデマと認めるも「ざまあw」と開き直り

静岡県の水害巡りフェイク画像が拡散 画像生成AIを利用 投稿者はデマと認めるも「ざまあw」と開き直り

台風15号による水害被害が発生している静岡県を巡って、フェイク画像がTwitter上で拡散されている。「ドローンで撮影された静岡県の水害」という画像という画像は、画像生成AIで作成したフェイク画像だった。 ディープフェイクはどう作られる? 技術資料を無償公開 東大発ベンチャー

ディープフェイクはどう作られる? 技術資料を無償公開 東大発ベンチャー

東京大学発のベンチャー企業NABLASが、「ディープフェイクと生成ディープラーニング」と題した技術資料を無償公開した。「ディープフェイク」を中心に、技術背景や実際に起きた事件などを解説している。 10万人以上の女性のディープフェイクヌード、Telegram上で拡散──Sensity調べ

10万人以上の女性のディープフェイクヌード、Telegram上で拡散──Sensity調べ

女性の画像を送ると数分でディープフェイクヌードに変換するbotがSNSのTelegram上で稼働しており、10万人以上の女性の画像が変換されたとセキュリティ企業が報告した。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR