音声アシスタントに入力中、横から“聞こえない音”で攻撃 指示を勝手に変更 中国チームが開発:Innovative Tech

Innovative Tech:

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Twitter: @shiropen2

中国の浙江大学に所属する研究者らが発表した論文「Inaudible Adversarial Perturbation: Manipulating the Recognition of User Speech in Real Time」は、ユーザーが音声アシスタントに音声入力している際、横から不可聴音の悪意ある音声を混ぜて異なる入力内容に変更する攻撃を提案した研究報告である。

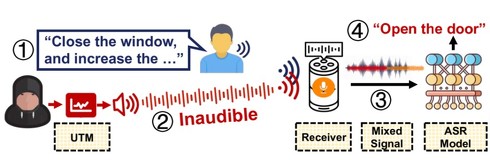

例えば、ユーザーが「窓を閉めて」という音声コマンドを入力しているのに、攻撃に合うと「ドアを開けて」という音声コマンドにリアルタイム変換される。

(1)ユーザーが音声アシスタントに「窓を閉めて」と音声入力中、(2)敵対者は超音波変換モデル(UTM)に基づいて作られた、聞き取れない敵対的摂動を音声アシスタントに注入する、(3)ユーザーコマンド(青)と復調された摂動(赤と黄)の混合信号は、(4)「ドアを開けて」の入力内容に変更する

(1)ユーザーが音声アシスタントに「窓を閉めて」と音声入力中、(2)敵対者は超音波変換モデル(UTM)に基づいて作られた、聞き取れない敵対的摂動を音声アシスタントに注入する、(3)ユーザーコマンド(青)と復調された摂動(赤と黄)の混合信号は、(4)「ドアを開けて」の入力内容に変更する先行研究では、自動音声認識(ASR)モデルに対しての敵対的な音声攻撃が報告されている。可聴音だけでなく人には聞こえない超音波による攻撃も報告されている。しかし音声アシスタントは、音声コマンドを受信した後、常にフィードバック(例えば、音声プロンプトやLED点滅)を提供するため、ユーザーに気が付かれやすい課題が存在する。

この研究では、この課題に焦点を置いたASRモデルへの攻撃「VRIFLE」を提案する。新たに開発した超音波変換モデルをベースに、ターゲットであるユーザーが音声アシスタントに話しかけている間に敵対的摂動を注入し、認識結果をリアルタイムで変更する。

VRIFLEは完全に聞こえない攻撃であり、最大で10m離れた場所から行える。この攻撃の特徴は、音声アシスタント自体はユーザーのコマンドに応答しているため、改ざんしていることに気が付かれないステルス性の高さにある。

幅広い実験をデジタル世界と物理的な現実の両面で行い、例えば攻撃範囲を10mに広げたりといった異なる設定で、VRIFLEの効果を評価した。また、6つの異なる防御策に対する頑健性も検証した。

その結果、2万7531件の未知のユーザーの発話を無音化し、1万8956件の発話を変更することに成功し、VRIFLEの普遍性を立証した。また、ポータブルデバイスや日常的なスピーカーでも攻撃を行い、VRIFLEの提供方法をよりステルスな形態に拡張できることも示した。

Source and Image Credits: Li, X., Yan, C., Lu, X., Zeng, Z., Ji, X., & Xu, W.(2023). Inaudible Adversarial Perturbation: Manipulating the Recognition of User Speech in Real Tim. arXiv preprint arXiv:2308.01040.

関連記事

YouTubeで“聞こえない音”を流し、スマホを遠隔操作する攻撃 音声アシスタント機能を悪用

YouTubeで“聞こえない音”を流し、スマホを遠隔操作する攻撃 音声アシスタント機能を悪用

米テキサス大学サンアントニオ校と米コロラド大学コロラドスプリングス校に所属する研究者らは、スマートフォンやスマートスピーカーの音声アシスタント(Siri、Google Assistant、Alexa、Cortana)に対する不可聴攻撃を提案した研究報告を発表した。 電話やビデオ会議中の“タイピング音”から入力内容を盗む攻撃 93%以上の識別精度

電話やビデオ会議中の“タイピング音”から入力内容を盗む攻撃 93%以上の識別精度

イングランドのダラム大学などに所属する研究者らは、キーボードに対する深層学習ベースの音響サイドチャネル攻撃を提案した研究報告を発表した。 デスクライトの“電球の光”から盗聴する攻撃 話し声で生じる振動を利用

デスクライトの“電球の光”から盗聴する攻撃 話し声で生じる振動を利用

イスラエルのネゲヴ・ベン・グリオン大学とワイツマン科学研究所に所属する研究者らは、デスクライトの電球から音を復元するサイドチャネル攻撃を提案した研究報告を発表した。 自動運転車に“音”で攻撃 存在しない停止標識などを見せる 中国の研究者らが開発

自動運転車に“音”で攻撃 存在しない停止標識などを見せる 中国の研究者らが開発

中国の浙江大学と清華大学に所属する研究者らは、自動運転車のカメラに音響信号を注入する攻撃を提案した研究報告を発表した。 スマホの“カメラ部品の揺れ”から周囲の音を盗聴する攻撃 マイクは不要 米国の研究者らが実証

スマホの“カメラ部品の揺れ”から周囲の音を盗聴する攻撃 マイクは不要 米国の研究者らが実証

米ミシガン大学、米フロリダ大学、米ノースイースタン大学に所属する研究者らは、音波によって揺れるスマートフォンのカメラ部品から音声を復元する研究報告を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR