やっぱり、AIチャットへの入力は“英訳した方が良い結果”に スペインの研究者らが検証:Innovative Tech

Innovative Tech:

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高い科学論文を山下氏がピックアップし、解説する。

Twitter: @shiropen2

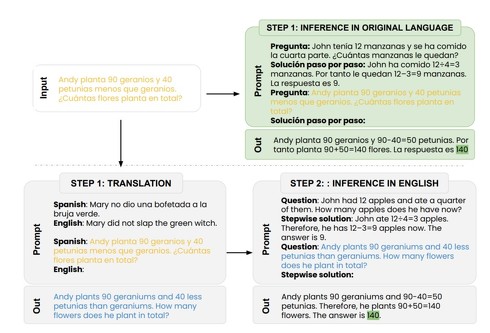

スペインのバスク大学に所属する研究者らが発表した論文「Do Multilingual Language Models Think Better in English?」は、英語以外の言語で大規模言語モデル(LLM)駆動のAIチャットに入力するよりも、英語に翻訳してから入力する方が高い精度で回答されることを示した研究報告である。

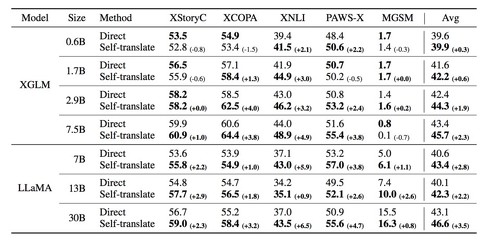

実験ではLLM「XGLM」の564M、1.7B、2.9B、7.5Bモデルと、LLM「LLaMA」の7B、13B、30Bモデルを使用する。各モデルについて、原語(英語以外)入力をモデルに与える直接推論と、入力をまず英語に翻訳し、この翻訳された入力を同じモデルに与えてタスクを解く自己翻訳の2つの方法を比較する。

入力するタスクは、算数問題や常識問題、言い換え問題など5つのデータ(XCOPA、XStoryCloze、XNLI、PAWS-X、MGSM)を使用する。

結果は、全てのモデルにおいて、原語で直接タスクを解くよりも、英語に翻訳してからプロンプトとして入力する方が精度が高かった。LLaMAに関しては、全てのモデルサイズと問題で英語に翻訳した方が良い結果になった。また、この現象はタスク間で一貫しており、大規模モデルや高リソース言語ほど顕著であることが分かった。

これらの結果から、多言語モデルは、英語以外の言語でプロンプトが表示された場合、その潜在能力をフルに活用できないことを示している。

Source and Image Credits: Etxaniz, Julen, Gorka Azkune, Aitor Soroa, Oier Lopez de Lacalle, and Mikel Artetxe. “Do Multilingual Language Models Think Better in English?.” arXiv preprint arXiv:2308.01223(2023).

関連記事

生成AIに“性格診断テスト”実施 GPTやLlamaに個性はある? 中国ByteDanceの研究者らが検証

生成AIに“性格診断テスト”実施 GPTやLlamaに個性はある? 中国ByteDanceの研究者らが検証

中国のByteDanceに所属する研究者らがは、大規模言語モデル(LLM)に個性があるかを検証した研究報告を発表した。 「ChatGPT vs. Google」どっちで検索する? 95人を対象に米研究者らが違いを調査

「ChatGPT vs. Google」どっちで検索する? 95人を対象に米研究者らが違いを調査

米マイアミ大学に所属する研究者らは、情報探索タスクに検索エンジン(Google)とAIチャットツール(ChatGPT)を使用する際のユーザーにおける行動や考え方の違いを調査した研究報告を発表した。 「もしよろしければ……」VS「やれ」 ChatGPTは丁寧にほめたほうがパフォーマンスがいい? 対応を変えて接してみた

「もしよろしければ……」VS「やれ」 ChatGPTは丁寧にほめたほうがパフォーマンスがいい? 対応を変えて接してみた

AIチャットサービス「ChatGPT」に、人間には答えにくい質問や、答えのない問い、ひっかけ問題を尋ねてみたらどんな反応を見せるのか。その反応からAIの可能性、テクノロジーの奥深さ、AIが人間に与える“示唆”を感じ取ってほしい。 ChatGPTに人格を与えるとどうなる? スティーブ・ジョブスになりきってEUに毒舌、有害性が増大

ChatGPTに人格を与えるとどうなる? スティーブ・ジョブスになりきってEUに毒舌、有害性が増大

AIチャット「ChatGPT」に人格を持たせると、性差別や人種差別など不穏当な発言を連発するようになって有害性が増大する──米国の非営利研究機関「アレン人工知能研究所」はそんな研究結果を発表した。 GPT-4の精度は悪化している? 3月に解けた数学の問題解けず GPT-3.5にも敗北──米国チームが検証

GPT-4の精度は悪化している? 3月に解けた数学の問題解けず GPT-3.5にも敗北──米国チームが検証

「GPT-4の精度は時間と共に変わっている」──そんな研究成果を米スタンフォード大学と米カリフォルニア大学バークレー校の研究チームが発表した。3月と6月時点のGPT-4の精度を比較したところ、一部タスクでは精度が大きく悪化していたという。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR