大手クラウドはクラウド専用チップで戦う時代へ 各社がクラウド基盤に専用SoC、サーバにArm、AI処理に独自プロセッサを相次いで採用

この記事は新野淳一氏のブログ「Publickey」に掲載された「大手クラウドはクラウド専用チップで戦う時代へ。各社がクラウド基盤に専用SoC、サーバにArm、AI処理に独自プロセッサを相次いで採用」(2023年11月20日掲載)を、ITmedia NEWS編集部で一部編集し、転載したものです。

今から10年以上前にクラウドが登場した当時、その中味は米Intelのプロセッサを搭載したサーバとその上で実行される仮想化ハイパーバイザを中心に構成されていました。

しかしその後、2017年には米Amazon Web Services(AWS)は、クラウド基盤に独自開発したSystem on a Chip(SoC)を載せたNitro Systemを2013年から採用していることを明らかにします。

同じ2017年、米Googleも機械学習に最適化した専用プロセッサを利用したサービス「Cloud TPU」を発表するなど、大手クラウド事業者はその規模を活かしてクラウドに最適化したチップを開発し採用することで、他社との差別化を図ろうとしていることが明らかになってきました

そして今月(2023年11月)、米Microsoftがクラウドインフラ専用SoCを採用した「Azure Boost」を正式版とし、高電力効率を実現するArmベースの独自プロセッサ「Azure Cobalt」と独自設計のAIチップ「Azure Maia」を相次いで発表したことで、AWS、Microsoft Azure、Google Cloudの3大クラウド事業者は本格的にクラウド専用チップで戦う時代に入ったように見えます。

AWS、Microsoft、Googleの各社におけるチップレベルの取り組みをまとめてみましょう。

AWS:クラウド基盤にNitro System

前述の通り、AWSは2017年11月のイベント「AWS re:Invent 2017」で、同社クラウド独自の基盤技術である「Nitro System」(ナイトロシステム)の存在を明かし、2013年から採用していると説明しました。

Nitro Systemは、もともとAmazon EC2を実現するためにホストサーバで稼働していたソフトウェアを、AWSが独自に開発したハードウェアにオフロードしたものです。

処理がオフロードされたことで、ホストサーバの能力のほとんどすべてがユーザーのインスタンスに振り分けられるようになり、Amazon EC2と関連するネットワークやストレージ性能の向上にも寄与しています。

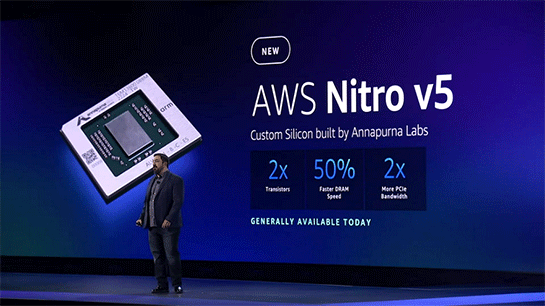

2022年に開催された「AWS re:Invent 2022」では、このNitro Systemの最新版として「AWS Nitro v5」が発表され、さらなる性能向上が図られています。

AWS:サーバにArmベースのGraviton

2018年に開催された「AWS re:Invent 2018」で、AWSは2015年に買収したASICベンダであるイスラエルAnnapurna Labsが設計と製造を担当した16コアの64ビットARMプロセッサである「AWS Graviton Processor」を発表。高効率なプロセッサとして、従来のIntel製Xeonプロセッサと比較してワークロードあたり45%の低コストで利用できると説明しました。

2019年には第2世代となる「Graviton 2」を発表。初代と比較してコア数で4倍、メモリの速度で5倍、全体として 7倍の性能向上を実現し、x86世代のインスタンスと比較して40%の価格性能比があると説明。

2021年に発表されたGraviton 3プロセッサは、Graviton 2と比較して浮動小数点演算で2倍、機械学習で3倍の能力を備え、最大で60%の電力消費量削減を実現しています。

AWS:機械学習と推論にInferentiaとTrainium

「AWS re:Invent 2018」ではGravitonだけでなく、機械学習用プロセッサ「AWS Inferentia」も発表されています。

「AWS Inferentia」は推論を高速かつ効率よく実行することに特化したプロセッサで、TensorFlow、MXNET、PyTorch、Caffe2、ONNXなど主要な機械学習フレームワークに対応します。

2020年に開催された「AWS re:Invent 2020」で、AWSは機械学習のトレーニング処理に最適化した独自プロセッサ「Trainium」を発表しました。

Trainiumは、TensorFlow、PyTorch、MXNetなどの主要な機械学習ライブラリに対応し、機械学習のトレーニング処理でテラフロップス級の性能を発揮。従来のプロセッサやGPUを用いた場合よりも高速で安価なトレーニング処理を実現すると説明されています。

Microsoft Azure:クラウド基盤にAzure Boot

AWSに続いてMicrosoft Azureの動向を見ていきます。

MicrosoftはMicrosoft Azureの基盤システムとして、ハイパーバイザとホストOSが行っていた処理を専用のシステムオンチップ(SoC)を用いたNICにオフロードし、より高性能なクラウド基盤によるインスタンスを提供する「Azure Boost」を今年(2023年)7月にプレビュー公開し、11月に正式版になったと発表しました。

参考:マイクロソフト、クラウド専用チップでAureの仮想マシンを強化する「Azure Boost」が正式版に

Microsoft Azure:サーバにArmベースのAzure Cobalt

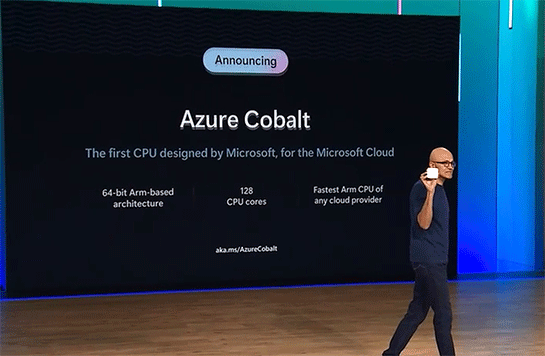

今月(2023年11月)開催されたイベント「Microsoft Ignite 2023」で、Microsoftが突如発表したのが、クラウド向けに最適化したArmベースの独自設計プロセッサ「Microsoft Azure Cobalt」です。

同社CEOのサティア・ナデラ氏はこの64ビット・128コアのArmベースチップがあらゆるクラウドプロバイダの中で最速だと説明し、AWS Gravitonよりも優れているとの自信をにじませています。

Microsoft Azure:機械学習と推論にAzure Maia

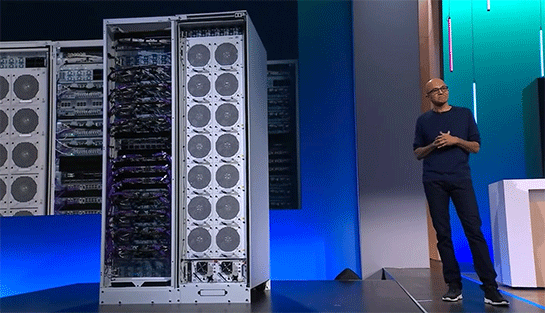

「Microsoft Ignite 2023」では、AIの学習や推論処理を高速に実行可能な独自設計のAIアクセラレータチップ「Azure Maia」も発表されました。

専用の冷却機構を備えたラックに組み込まれたAzure Maiaは、すでにGitHub Copilotを含む同社のAIサービスに使われており、今後外部にも公開されていく予定です。

こうしてMicrosoftは、AWSが独自に開発したNitro System、Graviton、Inferentia、Trainiumにそれぞれ対抗するシステムやチップを揃えたことになります。

これらを見ると、Microsoftはとにかく顧客から見てAWSとほぼ同等の性能とコストを備えたクラウドインフラを実現したうえで、少なくとも現時点で同社がAWSよりも明らかに優位だと考えられる開発者向けツールやCopilotによるAIサービスをMicrosoft Azureと密に連携させることで優位性を実現する、という戦略をとっているのではないかと推測されます。

Google Cloud:クラウド基盤にIPU

大手クラウドの3社目はGoogle Cloudのクラウド専用チップへの取り組みです。

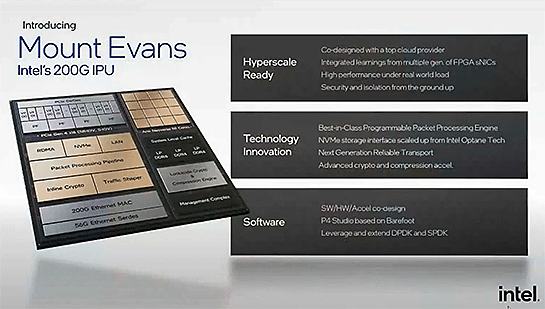

2022年10月、Google CloudとIntelは両社が共同開発したクラウド基盤用のASIC「Intel Infrastructure Processing Unit」(Intel IPU)のGoogle Cloudでの採用を明らかにしました。採用されたのは、コードネーム「Mout Evans」として開発されたSoC(System on a Chip)です。

Intel IPUもNitro SystemやAzure Boostと同じように、ホストサーバからさまざまな処理をオフロードすることで、高速かつセキュアなI/O処理の実現と、ホストサーバの負荷軽減などを実現します。

Google Cloud:サーバにAmpere Altra

2022年7月、Google Cloudは、Arm Neoverse N1コアを搭載したAmpere Altraプロセッサベースの仮想マシンやKubernetesのノードの提供を発表しました。

このAmpere Altraはクラウド専用というわけではなく、Amperer Computingによる汎用プロセッサとなります。

Google Cloud:機械学習と推論にCloud TPU

2017年、Googleは5月に開催したイベント「Google I/O 2017」で、機械学習に最適化した独自ASICであるTensorFlow Processing Unit(TPU)を用いたクラウドサービス「Cloud TPU」を発表しています。

Google Cloudもクラウド基盤、インスタンス、機械学習のいずれもクラウドに最適化したプロセッサの採用を始めていますが、TPU以外のIntel IPU、Ampere Altraについてはインテル、Ampere Computingという外部ベンダから調達する製品である点が、AWSやMicrosoft Azureと異なる特徴だといえます。

大手クラウドはチップレベルから再構築されようとしている

このように、Google Cloudが採用したAmpere Altraを除くすべてのチップがクラウド専用に設計され製造されたものです。

大手クラウドが提供するクラウドサービスは、そのサービス提供を継続しながらも、チップのレベルからクラウドサービスに最適化されたハードウェアによってさらに高性能で高効率なシステムへと再構築されようとしているところだといえるでしょう。

関連記事

Google、AWS Nitro対抗のクラウド基盤システム「Google Titanium」投入

Google、AWS Nitro対抗のクラウド基盤システム「Google Titanium」投入

米Google Cloudが、同社専用に開発したカスタムチップやソフトウェアなどにより構成されるクラウド基盤システム「Titanium」の投入を、発表した。 「Azureのこの機能、AWSで例えると何?」を簡潔に知る方法 実は公式サイトに……

「Azureのこの機能、AWSで例えると何?」を簡潔に知る方法 実は公式サイトに……

「Azureのこの機能、AWSで例えると何?」──その疑問、実は答えがまとまってます。 Google CloudがArmプロセッサを採用 “3大クラウド”全てでArmプロセッサが利用可能に

Google CloudがArmプロセッサを採用 “3大クラウド”全てでArmプロセッサが利用可能に

米Google Cloudが、Arm Neoverse N1コアを搭載したAmpere Altraプロセッサベースの仮想マシンやKubernetesのノードの提供を、「Google Compute Engine」などでプレビュー版として開始する。 「Red Hat OpenShift Service on AWS」発表 AWS上でのフルマネージドサービス AWSとRed Hatが手を組む理由とは?

「Red Hat OpenShift Service on AWS」発表 AWS上でのフルマネージドサービス AWSとRed Hatが手を組む理由とは?

AWSとRed Hatが「Red Hat OpenShift Service on AWS」を発表。クラウドネイティブ基盤ソフトウェア「Red Hat OpenShift」を、AWS上でフルマネージドサービスとして提供する。両社はなぜ手を組むのか。 AWS、クラウド基盤用のカスタムチップ「AWS Nitro v5」発表 パケット処理能力など向上 AWS re:Invent 2022

AWS、クラウド基盤用のカスタムチップ「AWS Nitro v5」発表 パケット処理能力など向上 AWS re:Invent 2022

AWSがクラウド基盤用のカスタムチップ「AWS Nitro v5」を発表。パケット処理能力が60%向上し、レイテンシは30%減少、電力当たりの能力は40%改善したという。Nitro v5を用いた新しい「C7gn」インスタンスも発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR