インテル、生成AI時代の新CPU“Core Ultra”発表 ローカルでの画像生成やLLM活用を披露

「現在はAIモデルの構築から機械学習、チューニングまでクラウド上で行っている。しかし多様なニーズに応えるため、今後はエッジやローカル側でも処理する必要がある」──インテル新規事業推進本部の大野誠本部長は、12月18日の発表会でそう語った。

【修正履歴:2023年12月19日午後1時20分 発表会の日付を修正しました】

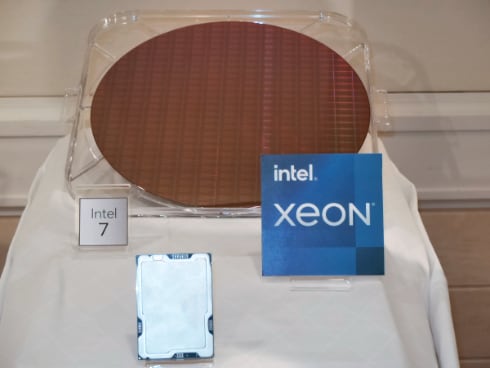

この日、お披露目したのは米国で14日に発表したモバイル向けCPU「インテルCore Ultraプロセッサー」(以下、Core Ultra)と「第5世代 インテルXeonスケーラブル・プロセッサー」(以下Xeon)。Core Ultraには初めてNPU(Neural Processing Unit)を搭載し、生成AIでは従来の約1.7倍のパフォーマンスを発揮するとしている。

一方のXeonは最大64コアで、全てのコアにAIアクセラレーションを実装した。第4世代とはピン互換のため、「載せ替えるだけでより高い演算性能を体感できる」(インテル技術本部の町田奈穂本部長)という。

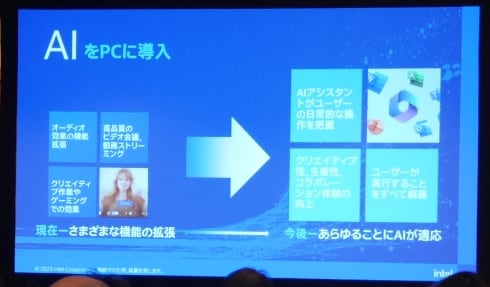

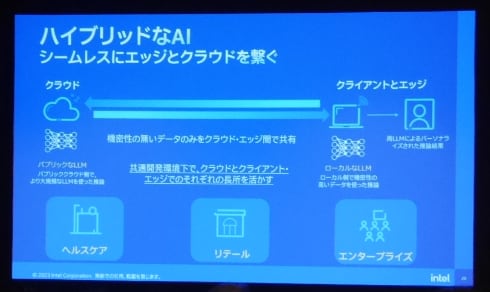

インテルが掲げる新ビジョン「AI Everywhere」は、クライアントからエッジ、データセンター、クラウドまでプラットフォームを問わずAIを利用できるようにするというものだ。そのために多様なハードの選択肢が必要で、新製品はその要素となる。

PC上でAIを動かすメリットについて大野氏は、「クラウド側で推論処理するよりローカルで処理した方が遅延は少ない。クラウド上に置いた個人情報の規制等もいかに順守するか考えていく必要もある。一方で(米Metaの)『Llama 2』のような“小ぶりなLLM”も出てきた。医療機関のような機密性の高い場所などでニーズが高まっている」としている。ただしクラウドを否定するわけではなく、「今後はハイブリッドなモデルに進化していくだろう」とした。

ノートPCでどのくらい“使える”?

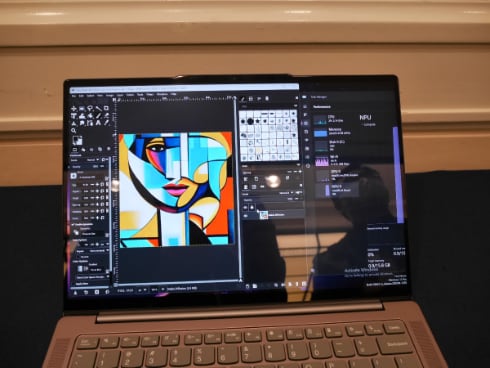

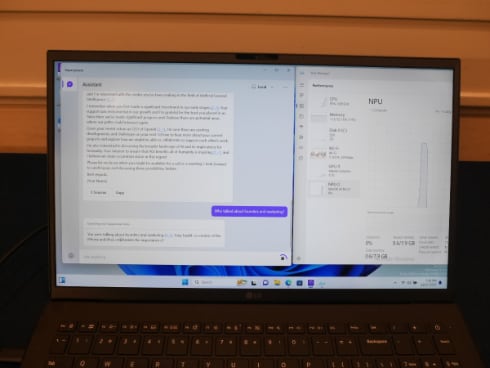

Core Ultraを搭載したノートPCのデモンストレーションでは、画像編集ソフトの「GIMP」からローカルで動く英Stability AIの画像生成AI「Stable Diffusion」を操作した。英語でプロンプトを入力すると10秒ほどで画像が出力される。

これはどの程度の実力なのか。インテル技術本部の安生健一朗部長によると「第13世代Coreプロセッサーに比べると出力に掛かる時間は半分程度になっている。既存PCに“それなりのGPU”を使えば、2〜3秒で出力できる処理」と話す。つまりGPUにコストを掛けたPCには及ばないものの、生成AIを従来より格段に高いパフォーマンスで活用できる。それもノートPCで。

もう1つのデモは、AIアシスタントソフト「SuperPower」から“小ぶりなLLM”であるLlama 2をやはりローカルで動かすというもの(開発版のためネットワーク接続は必要)。SuperPowerは、PCに蓄積している議事録やWebページなどを利用し、パーソナライズされた作業支援を行うというもので、自然言語で質問すると6〜7秒ほどで回答を表示した。

インテルによると、今後はこうした“普段の作業”を支援するためのAIアプリケーションが数多く登場するという。同社は「AI PCアクセラレーションプログラム」を通じて100社以上のISV(独立系ソフトウェアベンダー)にAIの採用を働きかけており、今後300以上のAIアプリとフレームワークが出てくる見通し。それを2025年までに1億台のPCに導入すると意気込む。

関連記事

ChatGPT(3.5)に匹敵する「Llama 2」をローカルPCで動かしてみた

ChatGPT(3.5)に匹敵する「Llama 2」をローカルPCで動かしてみた

生成AIのトップランナーといえば、米OpenAIが提供するGPT-4などを使ったChatGPTですが、その対抗馬として期待されているのが米Metaが提供する大規模言語モデル「Llama 2」です。Llama 2ならば自宅のローカルPCでも動作させられるかもしれません。ということで、Text Generation web UIを使って、Llama 2を試してみました。 Stable Diffusionを手元で動かしたい! 画像生成AIを動かすならどんなPCを選んだらいい?

Stable Diffusionを手元で動かしたい! 画像生成AIを動かすならどんなPCを選んだらいい?

どんなPCがあれば、Stable Diffusionのような画像生成AIを動かせるのか? 画像生成用にPCを選ぶなら、何に注意したらいいのか? そんなことを、マウスコンピューターに聞いた。 「イナズマイレブン」「妖怪ウォッチ」で画像生成AIを活用 レベルファイブのAI利用例が公開に

「イナズマイレブン」「妖怪ウォッチ」で画像生成AIを活用 レベルファイブのAI利用例が公開に

「イナズマイレブン」「レイトン教授」シリーズなどで知られるゲーム会社・レベルファイブは、画像生成AIの業務利用例を紹介した資料を公開した。 性的同意サービス「キロク」提供開始 公式キャラ登場、LINEスタンプも

性的同意サービス「キロク」提供開始 公式キャラ登場、LINEスタンプも

性交渉に同意した記録を残すサービス「キロク」が14日、Webサービスとして正式に提供を始めた。公式キャラクターも公開し、LINEスタンプの提供も予定している。 映画「ゲゲゲの謎」クチコミで異例のヒット 劇場でマンガ家が見た“女性に人気”の理由とは?

映画「ゲゲゲの謎」クチコミで異例のヒット 劇場でマンガ家が見た“女性に人気”の理由とは?

「ゲゲゲの鬼太郎」の前日譚ともいえる映画「鬼太郎誕生 ゲゲゲの謎」が、口コミでじわじわと人気が出て、興行収入は11億5000万円を超えました。しかも女性に人気だそうです。一体なぜ?

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR