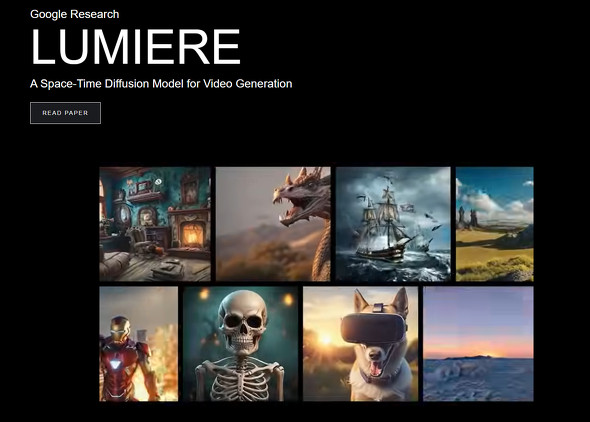

Google Research、かなり自然なテキスト→動画生成AI「Lumiere」発表

米Googleの研究部門Google Researchは1月23日(現地時間)、「リアルな動画生成のための時空拡散モデル」と呼ぶ動画生成AIモデル「Lumiere」(仏語で光という意味)を発表した。テキストや画像からリアルな動画を生成する。生成できるのは、1024×1024ピクセルの5秒間の動画だ。

論文によると、Lumiereは独自のアーキテクチャを利用して、動画の時間全体を一度に生成するという。キーフレーム間をつないで合成する従来のモデルとは異なり、「モデル内の単一パスを通じて、動画の時間的継続全体を一度に生成する時空間U-Netアーキテクチャを導入」した。大まかに言うと、空間と時間の両方を同時に処理できるように設計されており、多数のフレームを組み合わせるのではなく、1つのなめらかなプロセスで動画全体を生成する。

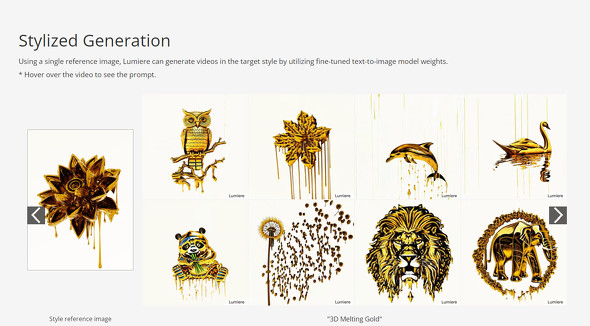

また、生成した動画のスタイルを参照画像で変更したり、動画修復機能で、例えば動画の中の人物のドレスだけ変更したりすることもできる。

論文によると、「3000万本の動画とそれに対応するテキストキャプションを含むデータセットでテキストから動画を変換するモデル(T2V)をトレーニングした」という。Googleは、トレーニングデータの入手方法は明らかにしていない。

Googleは「この研究の主な目標は、初心者ユーザーでも創造的かつ柔軟な方法でビジュアルコンテンツを生成できるようにすることだ。だが、われわれの技術には、偽コンテンツや有害コンテンツを作成できてしまうというリスクがあり、安全で正しい使用を確保するには、悪意ある使用法を検出するツールを開発・適用することが重要だと考えている」という。

GoogleはLumiereを一般公開していない。

関連記事

“AI生成の文章/画像だけ”でデータを学習する手法 人間が作るものは一切使わず GoogleとMITが開発

“AI生成の文章/画像だけ”でデータを学習する手法 人間が作るものは一切使わず GoogleとMITが開発

Google ResearchやMIT CSAILに所属する研究者らは、合成画像と合成キャプションから視覚表現を学習するアプローチを提案した研究報告を発表した。 Stability AI、テキスト→動画の「Stable Video Diffusion」をGitHubで公開

Stability AI、テキスト→動画の「Stable Video Diffusion」をGitHubで公開

Stability AIは、テキストから動画を生成するAIモデル「Stable Video Diffusion」のリサーチプレビュー版をGitHubで公開した。テキスト入力のためのWebツールを入手するにはウェイティングリストに登録する必要がある。 Meta、独自の動画生成AI「Emu Video」と編集AI「Emu Edit」を紹介

Meta、独自の動画生成AI「Emu Video」と編集AI「Emu Edit」を紹介

Metaは、9月に発表した独自の画像生成基盤モデル「Emu」に基づく2つのモデルを発表した。4秒のリアルな動画を生成できる「Emu Video」とプロンプトで画像を編集する「Emu Edit」だ。 Google、文章から動画を生成するAI「Imagen Video」を紹介 Metaに続き

Google、文章から動画を生成するAI「Imagen Video」を紹介 Metaに続き

Google Researchは、短い文章から短い動画を生成するAIシステム「Imagen Video」を発表した。Metaの「Make-A-Video」と同様にまだ不自然でぼやけてはいるが、テキストレンダリングや3D表示などが可能。悪用軽減対策ができるまではモデルとコードは公開しない。 映像内の犬を猫に変えられるAI テキストのみで動画編集が可能 Googleなど「Dreamix」開発

映像内の犬を猫に変えられるAI テキストのみで動画編集が可能 Googleなど「Dreamix」開発

Google ResearchとイスラエルのThe Hebrew University of Jerusalemに所属する研究者らは、テキストに応じた動画編集ができる拡散モデルを提案した研究報告を発表した。 Google、テキストから音楽を生成する「MusicLM」発表 リリースはせず

Google、テキストから音楽を生成する「MusicLM」発表 リリースはせず

Googleは、テキストから音楽を生成するAIモデル「MusicLM」を発表した。多数のサンプルを聞くことができるが、著作権侵害などの恐れがあるため、現時点では公開はしない。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR