生成AIで一発お手軽に……ではなかったアニメ「ツインズひなひま」 “職人技”が光る制作の舞台裏を聞く:まつもとあつしの「アニメノミライ」(1/3 ページ)

3月29日に異色の手法で制作されたTVアニメが放送された。AIを積極的に活用したことを全面に打ち出した「ツインズひなひま」だ。

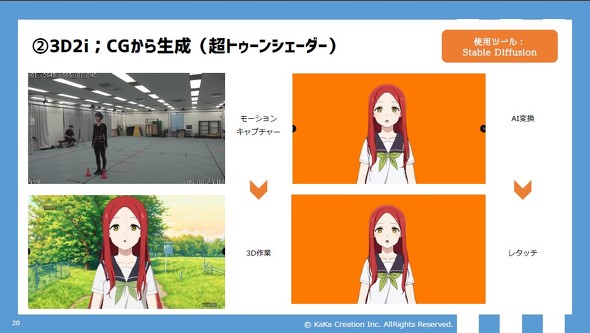

「動画生成AIを用いて簡易に作ったのでは?」という誤解もあるようだが、この作品はそんな方法で生まれたものではない。モーションキャプチャー、ゲームエンジン、セルルックキャラクターの強化学習から生まれた膨大な静止画画像を、手作業で組み合わせた大規模な工程によるものだ。

昨今AIを用いているだけで批判される風潮もあるなか、あえてAIを全面に押し出したのはなぜなのか? 制作にあたってどんな苦労があったのか? 今後さらなる展開はあるのかなど気になるポイントについて関係者に話を聞いた。

AIでアニメを作る――そのきっかけは?

――ツインズひなひまはどういった経緯で企画がスタートしたのでしょうか?

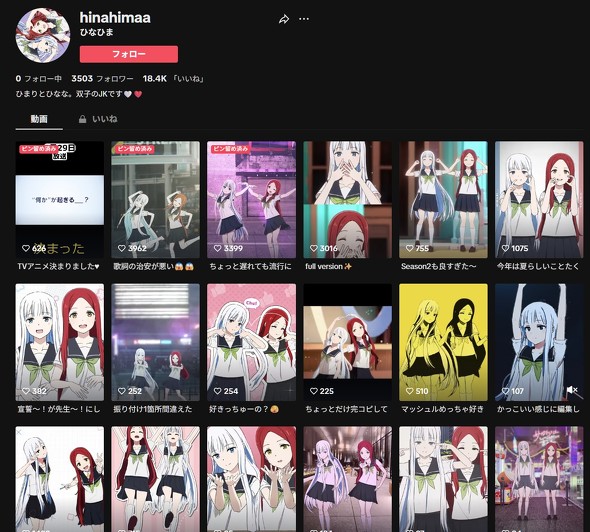

黒澤:もともとはKaKa CreationさんがスタートさせていたTikTok上でのAIアニメプロジェクトに関するプレスリリースを拝見し、私たちフロンティアワークスが問い合わせした流れで、TVアニメについて一緒に展開していこうということになりました。

黒澤典弘(フロンティアワークス映像事業部)

2009年にフロンティアワークスに入社。アニメ制作・ビデオグラム商品制作などを担当。主な担当作品はTVアニメ「落第騎士の英雄譚」、TVアニメ「治癒魔法の間違った使い方」など。

飯塚:2023年6月に「AIを使ってアニメを作る」ことを目的に創業メンバーの一人として起業し、TVアニメの原作となったツインズひなひまをスタートさせています。当時は「Stable Diffusionがすごいぞ」と話題になっていたような時期です。とはいえ、静止画やごく短い動画の生成が中心で、当時「コンテンツ」として完成させている人はほとんどいなかったと思います。そこで、AIなどの技術を用いて「仕上げる」ことには意義があるだろうと考えたのです。

飯塚直道(KaKa Creation CCO/プロデューサー)

2016年にサイバーエージェントへ新卒入社。Abema「にじさんじのくじじゅうじ」などの番組を担当後Production I.Gで「ULTRAMAN」FINALや「攻殻機動隊 SAC_2045」劇場版のラインプロデューサーを務める。KaKa CreationではCCOとして企画や品質管理を担い、現在も複数のアニメ作品をプロデュース中。

そこで、まずは最小限の構成内容、つまりストーリーや音声、カメラワークを必要としない内容でコンテンツが完成する「踊ってみた」動画からはじめようと発案しました。「アニメTiktoker」と銘打って、踊るというアニメーションだけに焦点を絞ってコンテンツを制作・運用していく方向で23年の11月にYouTubeチャンネルに動画を公開し、TikTokにも動画投稿を始めています。

――バーチャルTikTokerとしての活動が当初はメインだったわけですね。そこからTVアニメへ、というのは、プロジェクトとしても大きな跳躍がありますが、フロンティアワークスとしては、どういう経緯でそれを実現させようということになったのでしょうか?

黒澤:われわれとしては、いくつもTVアニメに関わるなかで現場にさまざまな課題があることを知り、またAIでその解決を図れないかという現場からの可能性を探る声も届いていました。会社としても技術を用いて、新しいアニメの作り方ができないかと模索をしていたタイミングだったのです。

そんな中、KaKa Creationさんのツインズひなひまがスタートしたというプレスリリースを拝見し、「これは面白そうだ」と上司と二人でお話を伺いにいったのがきっかけでした。最初のヒアリングで大きな手応えがありましたので、すぐに社長(辻政英氏)も交えて再訪し、トップ判断として「TVアニメ」にチャレンジしようということになりました。

――社長肝いりのプロジェクトだったのですね。

黒澤:そうですね。都度プロジェクトの方向性にも意見をもらいましたので、そう呼んでも問題ないかと思います。

目標はセルアニメ――ルック・モーションとの格闘

――Stable Diffusionは当初画像(静止画)の生成に強みがありましたし、一貫性があり、比較的長いダンス動画を生成するにはいろいろ工夫が必要ではなかったかと思います。

飯塚:そうですね。もともと私はCGプロデューサーでもあるのですが、リサーチをしていくなかで、Stable Diffusionと3DCGとの相性が良いということが分かり、最初の動画では、まずそのアプローチで制作するのが現実的だと考えました。この基本的なフローはTVアニメでも同じです。

モーションキャプチャーを行い、そこから用意される3DCGモデルをAIでセルルックに変換するのですが、これは3DCGだけでアニメ調にする「セルルック」とは比較にならないほど、手描き感のあるものになります。セルルックが、あくまで境界線や塗り・シェーディング等の調整で手描き風に「見せている」のに対して、あらかじめ学習した実際の手描きイメージにのっとって、ルック(見た目)が「生成」されるからです。

ただ、技術的にはいま見ると、TikTokで投稿した1本目の動画はその後放送されたTVアニメと比較するとクオリティーは決して高くありません。特にAIには時間の概念がなく、映像における「連続性」を表現することが苦手なので、アニメーションの肝となるタメやツメなどのタイミングが自動的には生まれてきません。

そこで、AIに入力する3DCGからの連番画像の方を、あらかじめ私たちが演出意図にそって間引くなど調整を施し、AIがそれらの画像の色やシルエットなどの要素をどれぐらい追随するか(現場ではこれを「依拠性」と呼んでいた)をパラメーターで調整しながら、1枚1枚生成していくということを行っていました。特に23年時点のStable Diffusionは、この依拠性を高めておかないと相当破綻した映像を出力してしまうため、結果的に手間を掛けているにもかかわらず、3DCGのプレビューとそこまで変わらない映像になってしまっていました。

そこからはTVアニメを制作していくなかでも技術検証を続けていたというのが実際のところです。当初のダンス動画に寄せられていた「映像がちらついて見える」「3DCGのプレビューと何が違うのか(AIを用いる意味があるのか?)」といった指摘は、1年余りの技術のアップデートの結果、TVアニメに対してはほとんど見られなくなったのは良かったと思っています。

――キャラクターデザインには「ラブライブ!虹ヶ咲学園スクールアイドル同好会」などを手掛けられた横田拓己氏を起用されていますが、そのデザインのテイストを生成AIで再現するにあたってはどのような工夫が必要だったのでしょうか?

飯塚:ブレークスルーは2023年7月にリリースされたSDXLモデル※を、作品のワークフローにも導入したことですね。このあとご紹介するワークフローの改善(低解像度で生成した画像の高解像度化)とあわせて、Stable Diffusion自体のパラメーター数が大幅に増加したことで画質・詳細度が格段に向上しました。インターネットの黎明期とも似ていて、技術をキャッチアップしておけば、それらを用いた成果物の品質もそれに応じて向上していくという、いまはそういう時期だと捉えています。

※SDXL(Stable Diffusion XL)は英Stability AI社によって開発された、画像生成AIモデル。23年7月にリリースされたが、当初は問題も多く「ひなひま」では高品質なルックが得られるようになったおよそ半年後から本格導入を始めている。

Copyright © ITmedia, Inc. All Rights Reserved.

Special

PR