AI「はっきりしませんが……」 “自信がないAI”に人はどう反応する? 米Microsoftらが400人以上で実験:Innovative Tech(AI+)

Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

米プリンストン大学とカナダと米国のMicrosoftに所属する研究者らが発表した論文「“I’m Not Sure, But…”: Examining the Impact of Large Language Models’ Uncertainty Expression on User Reliance and Trust」は、自信がない回答をする大規模言語モデル(LLM)に対して人々はどう反応するかを調査した研究報告である。

LLMは、人間のように流ちょうで説得力のある文章を生成できるが、その内容が常に正しいとは限らない。LLMが間違った情報を提示した場合、ユーザーがそれをうのみにしてしまう「過度な依存」が問題視されている。この問題に対処するため、LLMが出力の不確実性(自信がない表現)をユーザーに伝えることが提案されているが、その効果を実証的に検証した研究はほとんどない。

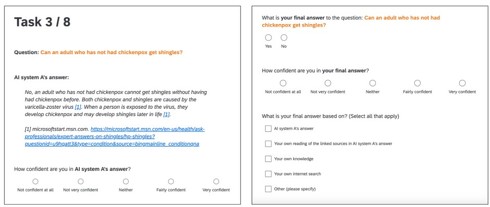

そこで、この研究では404人の参加者を対象に、架空のLLMを搭載した検索エンジンを使った情報探索タスクを行ってもらった。タスクは、用意したLLMなどを駆使して医療に関する質問8つに回答するというもので、その際にAIの情報を信用するかどうかを調べた。参加者は、以下の4つのグループに分けられた。

- AIの回答は見せるが、AIは不確実性を表現しないグループ

- AIの回答は見せるが、AIは不確実性を一人称で表現するグループ(例:「私はよく分かりませんが…」)

- AIの回答は見せるが、AIは一般的な視点で不確実性を表現するグループ(例:「はっきりしませんが…」)

- AIの回答を見せないグループ

ただし、AIの回答が正しいのは4つ、間違っているのは4つある。また正解・不正解のそれぞれ半分にのみ不確実性表現が含まれるよう設定されている。

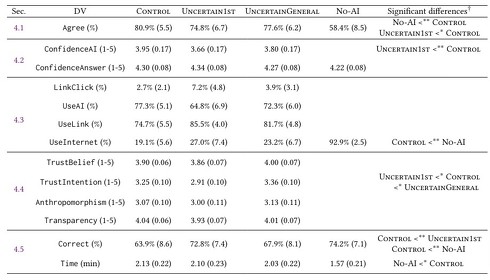

実験の結果、AIの回答に同意した割合は、グループ1の80.9%に対し、グループ2では74.8%と有意に低く、グループ3でも77.6%と低かった。AIの回答に対する参加者の自信も似た割合であった。つまり、自信がない回答をされるとAIに対する参加者の自信と同意する傾向が下がった。

その一方、参加者の最終的な回答の正確さは、グループ1の63.9%に対し、グループ2では72.8%と有意に高く、グループ3も67.9%とやや高かった。この結果は、参加者のAIに対する過度な依存が減った可能性(完全には排除されない)を示唆する。

続いて、グループ1ではLLMとは別にネット検索をする割合が19.1%だったのに対し、グループ4では92.9%だった。またAIの回答が不確実性を含む場合、AIの回答を利用する割合が有意に低下し、独自検索をする割合が上昇した。さらに、AIの回答が不確実性を含む場合、回答時間が長くなる傾向があった

要するに、AIが答えに自信がないと言うと、人々はその出力に対して警戒心を強め、最終的には他の場所で正確な情報を探し出すということである。もっというと、グループ4の回答の正確さは74.2%とさらに高かったため、LLMを全く利用せずに、始めからネット検索した方が正確な回答を導けることを示唆した。

参加者の自由回答を分析したところ、多くが不確実性表現をLLMの能力の限界や質問の難しさの表れと解釈していた。一方、一部は単なる「印象操作」や「信頼性の維持」「法的責任の回避」などと捉えていた。

Source and Image Credits: Kim, Sunnie SY, et al. “” I’m Not Sure, But…”: Examining the Impact of Large Language Models’ Uncertainty Expression on User Reliance and Trust.” arXiv preprint arXiv:2405.00623(2024).

関連記事

LLMが別のLLMを何度も改善 より良い回答を出す最適化手法をAIが発見する技術 Sakana AIなどが開発

LLMが別のLLMを何度も改善 より良い回答を出す最適化手法をAIが発見する技術 Sakana AIなどが開発

AIベンチャーのSakana AIやFLAIR、英ケンブリッジ大学、オックスフォード大学に所属する研究者らは、人間の介入を最小限に抑えて新しい最適化アルゴリズムをAIによって発見する手法を提案した研究報告を発表した。 米Appleの独自AI「Apple Intelligence」の技術詳細 基盤モデルや学習データなどを解説

米Appleの独自AI「Apple Intelligence」の技術詳細 基盤モデルや学習データなどを解説

米Appleは、年次開発者会議「Worldwide Developers Conference 2024」(WWDC24)において、iOS 18、iPadOS 18、macOS Sequoiaに統合される独自AI「Apple Intelligence」を発表した。このシステムの基盤モデルについて、簡潔にまとめる。 「自称オープンソース生成AI」は本当に“オープン”なのか? 45種のAIモデルをオランダの研究者らが調査

「自称オープンソース生成AI」は本当に“オープン”なのか? 45種のAIモデルをオランダの研究者らが調査

オランダのRadboud University Nijmegenに所属する研究者らは、オープンソースと主張する生成AIを対象に、どの程度オープンなのかを調査した研究報告を発表した。 ChatGPT vs. Wikipedia──生成AIの登場でウィキペディアはどう変わったか? 英国の研究者らが調査

ChatGPT vs. Wikipedia──生成AIの登場でウィキペディアはどう変わったか? 英国の研究者らが調査

英キングス・カレッジ・ロンドンに所属する研究者らは、2022年11月にChatGPTが一般公開されたことを受け、Wikipediaの利用状況にどのような変化が生じたのかを調査した研究報告を発表した。 経済アナリスト vs. GPT-4──生成AIは金融投資にどれくらい使える? 米シカゴ大が研究報告

経済アナリスト vs. GPT-4──生成AIは金融投資にどれくらい使える? 米シカゴ大が研究報告

米シカゴ大学に所属する研究者らは、大規模言語モデル(LLM)、特にGPT-4が企業の財務諸表分析においてどのような能力を発揮するかを検証した研究報告を発表した。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.