パナソニック、1000億パラメータの社内専用LLMを開発へ AIスタートアップ・ストックマークと協業

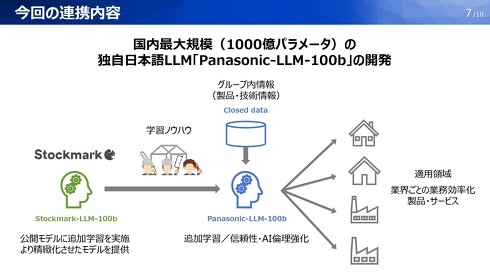

パナソニックホールディングスは7月2日、パナソニックグループ専用の大規模言語モデル(LLM)「Panasonic-LLM-100b」を開発すると発表した。AIスタートアップ企業のストックマーク(東京都港区)と協業し、開発していく。パラメータ数は1000億を想定しており、これは企業が開発する自社専用LLMとしては国内最大規模という。

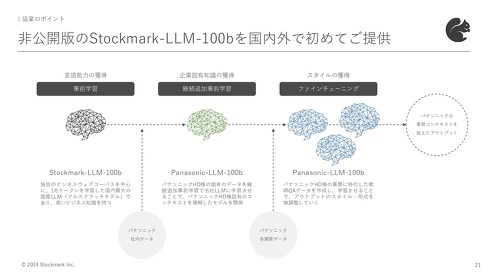

ストックマークは5月、LLM「Stockmark-LLM-100b」をフルスクラッチで開発し、Hugging Face上で一般公開していた。ハルシネーション(AIがもっともらしいうそをつく現象)を大幅に抑えているのが特徴。また、独自に収集したビジネスドメインの日本語データを中心に事前学習しており、日本語やビジネスドメイン、最新の時事話題に精通しているという。

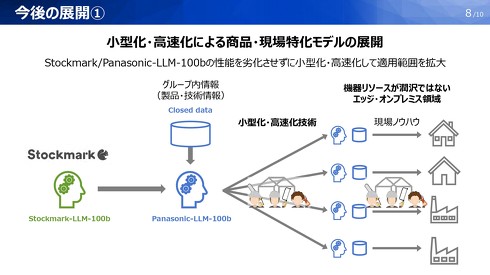

パナソニックではこのLLMに対して、同社の社内情報を追加事前学習させ、グループ専用の日本語LLM「Panasonic-LLM-100b」を構築する。今回利用するStockmark-LLM-100bは一般公開したものではなく、非公開版のより高性能なAIモデルという。社内LLMの開発後には、開発中のマルチモーダル基盤モデル「HIPIE」に統合し、グループ内の各事業会社でのAI開発・社会実装を進めていく。

現状、国内企業が自社LLMを構築する場合、70〜130億パラメータの小型モデルを採用することが多いという。パラメータ数を上げる意味について、ストックマークの林達CEOは「パラメータ数が増えるほどテキストの読解力や、生成の流ちょうさが上がってくることが分かってきている。大体700〜800億パラメータを超えてくるとブレークスルーし、精度も上がっていく」と話す。

一方、パラメータ数を増やすことによるデメリットもある。林CEOは「パラメータ数を上げるほど、AIモデルがじゃじゃ馬のようになって制御が難しくなり、チューニングがやりづらくなる」と説明。パナソニックは、この技術的な難しさをストックマークと協業することで、クリアしていく算段だ。

Panasonic-LLM-100bは秋ごろまでに構築し、実業務で運用していく方針。

関連記事

1000億パラメータのLLM、AIスタートアップが公開 フルスクラッチで開発 「ハルシネーションを大幅抑止」

1000億パラメータのLLM、AIスタートアップが公開 フルスクラッチで開発 「ハルシネーションを大幅抑止」

AIスタートアップ企業のストックマークは、1000億パラメータ規模の大規模言語モデルを開発したと発表した。同社がフルスクラッチで開発したものでハルシネーションを大幅抑止しているのが特徴という。 “GPT-4超え性能”の日本語特化型LLM AIスタートアップ・ELYZAが開発 国外プレイヤーとの競争も「諦めない」

“GPT-4超え性能”の日本語特化型LLM AIスタートアップ・ELYZAが開発 国外プレイヤーとの競争も「諦めない」

東大発のAIスタートアップ企業であるELYZAは、GPT-4を超える性能を持つ日本語特化型の大規模言語モデル(LLM)「Llama-3-ELYZA-JP-70B」を開発したと発表した。 ソフトバンク子会社、独自LLM「Sarashina」シリーズを一般公開 「24年度中に3900億パラメータLLMの構築目指す」

ソフトバンク子会社、独自LLM「Sarashina」シリーズを一般公開 「24年度中に3900億パラメータLLMの構築目指す」

ソフトバンクの子会社でAIの研究開発などを手掛けるSB Intuitionsは、日本語に強い大規模言語モデル(LLM)「Sarashina」シリーズを一般公開した。 LLMが別のLLMを何度も改善 より良い回答を出す最適化手法をAIが発見する技術 Sakana AIなどが開発

LLMが別のLLMを何度も改善 より良い回答を出す最適化手法をAIが発見する技術 Sakana AIなどが開発

AIベンチャーのSakana AIやFLAIR、英ケンブリッジ大学、オックスフォード大学に所属する研究者らは、人間の介入を最小限に抑えて新しい最適化アルゴリズムをAIによって発見する手法を提案した研究報告を発表した。 生成AIでGPUがいらなくなる? 業界を揺るがす「1ビットLLM」とは何か、識者に聞いた

生成AIでGPUがいらなくなる? 業界を揺るがす「1ビットLLM」とは何か、識者に聞いた

米Microsoftの研究チームが発表した「BitNet」、通称「1bit LLM」と呼ばれる論文が波紋を呼んでいる。これまで必須だと思われていたGPUが不要で、CPUでもLLMが動作することを示唆している。そもそも“1bit”とは何が1bitなのか、どうして1bitになるとGPUが不要になるのか、AIソリューションの開発・提供を行うLaboro.AIの椎橋徹夫CEOに聞いた。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.