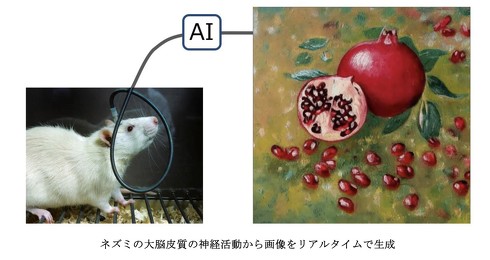

ネズミの脳波からAIが画像を生成、東大が発表 脳波の変化をリアルタイムで反映

東京大学は9月7日、ネズミの脳波からAIが画像を生成するシステムを作ったとする研究を発表した。画像生成AIにネズミの脳波をノイズとして入力。脳波の変化をリアルタイムで反映する画像が出力できるという。

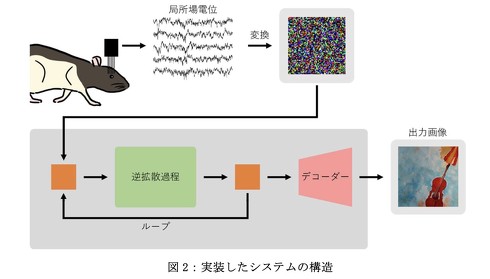

研究に使った画像生成AI「Stable Diffusion」は、ノイズから画像を作り出す「拡散モデル」。このモデルは、画像に加えられたノイズを除去し、元の画像を復元するように学習する。結果、ランダムなノイズを入力すると、学習に沿った新しい画像を出力できるようになる。

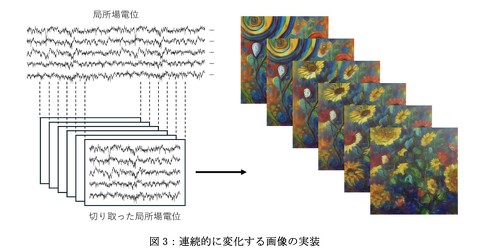

研究では、Stable Diffusionにネズミの脳波をノイズとして入力するシステムを構築した。脳波はニューロンの信号を記録する時系列データであり、そのままStable Diffusionに入力することはできない。そこで脳波を1/30 秒ずつずらして切り取り、ノイズに変換。リアルタイムで入力できるようにし、脳波の変化に応じて少しずつ変化する画像の出力を可能にした。

Stable Diffusionは、文章による入力から画像を生成する使い方が一般的だが、ノイズのみの入力にも対応する。今回の研究ではネズミの脳波から変換したノイズのみを入力に使ったが、今後はネズミの内部状態を文章に反映させ、例えば眠たいときには静かな雰囲気の画像など、「気分」に応じた画像の生成ができるシステムの構築を目指すという。

今回開発した手法は、脳波以外のバイオ信号、波や風といった自然現象など、全ての時系列信号に応用可能。研究グループは、この手法が芸術の新たな創作手法となることを期待するとしている。

研究を発表したのは、東京大学大学院薬学系研究科の山城皓太郎さんと池谷裕二教授らの研究グループ。研究成果は、PLOSONE誌(オンライン版)に7日付で掲載された。

関連記事

「換気していない部屋では眠くなる」は科学的に正しかった――二酸化炭素と“日中の眠気”の因果関係、東北大が解明

「換気していない部屋では眠くなる」は科学的に正しかった――二酸化炭素と“日中の眠気”の因果関係、東北大が解明

東北大学は二酸化炭素が日中の眠気を引き起こすとする研究結果を発表した。 「脂質ゼロの油」「糖類ゼロのクリーム」を作る研究、明治大が発表 “食感”制御で味を再現

「脂質ゼロの油」「糖類ゼロのクリーム」を作る研究、明治大が発表 “食感”制御で味を再現

明治大学の宮下芳明研究室は「脂質ゼロの油」や「糖類ゼロのクリーム」を作る研究を発表した。 幼少期のタブレット使用が多いと将来“怒りっぽく”なる? 300人以上の幼児を対象に調査

幼少期のタブレット使用が多いと将来“怒りっぽく”なる? 300人以上の幼児を対象に調査

カナダのシャーブルック大学などに所属する研究者らは、幼児期のタブレット使用と怒りやフラストレーション爆発の表出に関する研究報告を発表した。 陰陽マーク? 「量子もつれ」をリアルタイムに可視化することに成功 国際チームが23年に発表

陰陽マーク? 「量子もつれ」をリアルタイムに可視化することに成功 国際チームが23年に発表

イタリアのローマ・ラ・サピエンツァ大学とカナダのオタワ大学に所属する研究者らは2023年に、量子もつれの光子をリアルタイムに可視化する技術を提案した研究報告を発表した。 小惑星リュウグウの水は「にがり」に満ちていた 生命の源となる有機物の材料を安定保存か

小惑星リュウグウの水は「にがり」に満ちていた 生命の源となる有機物の材料を安定保存か

小惑星リュウグウにかつて存在していた水は、物質を安定的に保存する性質を持つ「にがり」に満ちていたことが分かったと、海洋研究開発機構などが9月5日、発表した。探査機はやぶさ2が持ち帰ったリュウグウの試料からは、生命の材料となる多様な有機物が発見されており、これらの生成に、にがりが役立った可能性があるとみられる。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.