「ほとんどのIT基盤はAIを支えるために使われるように」──米DellのチーフAIオフィサーが見る生成AI時代の企業戦略

「挑発的な言い方になるが、ほとんどのIT基盤はAIのワークロードを支えるために使われるようになるだろう」──。デル・テクノロジーズの年次イベント「Dell Technologies Forum Japan 2024」(10月3日)で、米Dell TechnologiesのチーフAIオフィサーも務めるジョン・ローズCTOが、生成AI時代のIT基盤のあり方についてこんな予測を明かした。そんな予測の下、デルとしてどんな戦略を立てているかについて講演した。

「みなさんが使っているLLM(大規模言語モデル)やRAG(検索拡張生成)、ベクトルDBといったテクノロジーは2年前にはなかったものだ」とローズCTO。生成AIについて、デルが創業してからの過去40年間にいろいろな創造的破壊があった中でも最もインパクトが大きく、変化のスピードも早いと評する。

そんな生成AIを企業が活用するにはどうしたらいいかについて、ローズCTOは5つの基本的な考え方が重要だという。

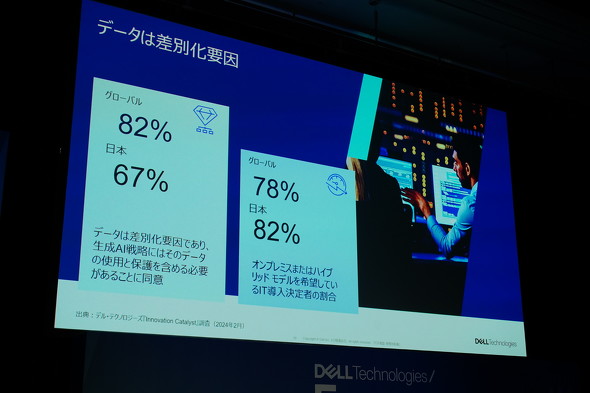

1つ目は「データの整備」。企業のデータは多くがオンプレミスやエッジで生成されるとして、LLMのモデルやチャットbotよりも企業データを整備することや、競合優位性のカギとなるデータの取り扱いを慎重に考えることが重要だとする。

2つ目は「計算資源とデータを置く位置を近づけること」だ。企業内の膨大なデータをAIで扱うに当たっては、AIの実行基盤である計算資源とデータの置き場所が離れていると転送にも時間的、金銭的コストがかかることになる。データがクラウドにあるならクラウドにAIの計算資源を置き、オンプレミスにあるならオンプレミスに置くべきだという。

デルの大塚俊彦社長も「それぞれの企業が持つデータが最大の差別化要因。世界でも日本でも約8割のIT導入決定者がオンプレミスかハイブリッドモデルを希望している」として、オンプレミスでのAI実行の重要性を説く。

3つ目は「IT規模の適正化」だ。プライベートLLMなどのローカルなAIの実行基盤について、多くの企業はまずワークステーションで試すが、次のステップではサーバでチャットbotなどのアプリケーションを作ることになる。そしてより多くの自社ユーザーへ届けるためにはさらに大きなサーバ群が必要になるとして「企業のITインフラの多くが今後はAIのために使われるようになる」とローズCTOは見る。

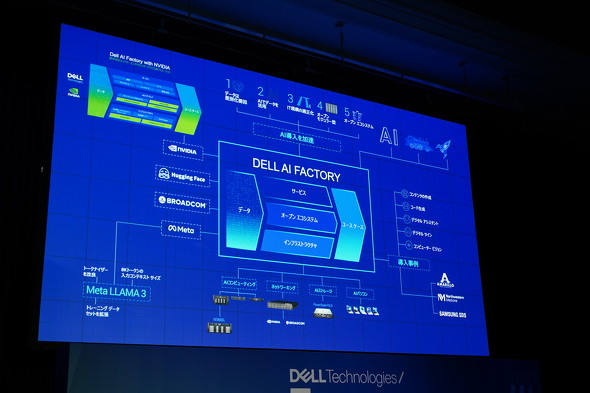

4つ目は「オープンなアーキテクチャ」。ローズCTOは「2年後にどうなるかは自分でも分からない」とした上で「今からロックインを防ぐ必要がある。1社のみに賭けてしまうと、そのときは非常に優れたシステムだとしてものちのち行き詰まる可能性もある。コンポーネントを入れ替えられるようにしておくことが大事だ」とした。

最後の5つ目には「オープンなエコシステム」を挙げた。AIのソリューションはデル1社で届けられるものでもなく、米IntelやNVIDIA、Microsoft、AMD、Broadcom、Meta、Hugging FaceといったAI関連企業との連携があってこそという。

こうした5つの考え方を踏まえ、ローズCTOは「みなさんにお願いしたいのは、AIインフラについて戦略的に考えてほしいということだ」と訴える。「単にサーバを導入すればいいわけではない。いかにAIのために作り変えるかだ」(同)

デルは単なるPCベンダーやサーバベンダーという立ち位置ではなく、AIを活用するためのエコシステムや方法論を包括的に提供するソリューション「Dell AI Factory」を打ち出していくとした。

関連記事

ハローワーク、生成AI導入を検討 マッチングの効率化狙う OpenAI Japanの協力も視野に

ハローワーク、生成AI導入を検討 マッチングの効率化狙う OpenAI Japanの協力も視野に

厚生労働省はハローワークの生成AI導入に向け、プロジェクトチームを設置すると発表した。 Cerebras、「NVIDIAのGPUベースより20倍高速」謳うAI推論サービス提供開始

Cerebras、「NVIDIAのGPUベースより20倍高速」謳うAI推論サービス提供開始

Cerebras Systemsは、AI推論ソリューション「Cerebras Inference」を発表した。「世界最速」でNVIDIAのサービスより20倍高速ではるかに安価だとしている。 Meta、無料で商用可のLLM「Llama 3.2」リリース マルチモーダルモデルも

Meta、無料で商用可のLLM「Llama 3.2」リリース マルチモーダルモデルも

MetaはLLMの最新版「Llama 3.2」を発表した。初のマルチモーダルモデルと、エッジデバイス対応の軽量モデルがある。開発者は無料で利用可能だ。

Copyright © ITmedia, Inc. All Rights Reserved.