「NVIDIA H200」がズラリ 産総研の最新AIスパコン「ABCI 3.0」の中身を見てきた

産業技術総合研究所(産総研)が11月から試験運用を予定しているAIスパコン「ABCI 3.0」の実機を、技術・産業の総合展示会「CEATEC 2024」の同研究所内ブースにて展示している。ノードには米NVIDIAの「H200」が複数搭載されており、前モデルよりAI処理性能が向上しているという。

ABCIは「AI橋渡しクラウド」(AI Bridging Cloud Infrastructure)として、産総研傘下のAIST Solutionsが提供する大規模計算基盤で、AIや機械学習を研究する大学や企業、研究機関向けに計算リソースを提供している。2.0は、NVIDIAの「A100」を採用した1088ノード(4352GPU)で構成されており、2020年から運用が始まった富岳が登場するまで、国内最高の計算性能を誇っていた。

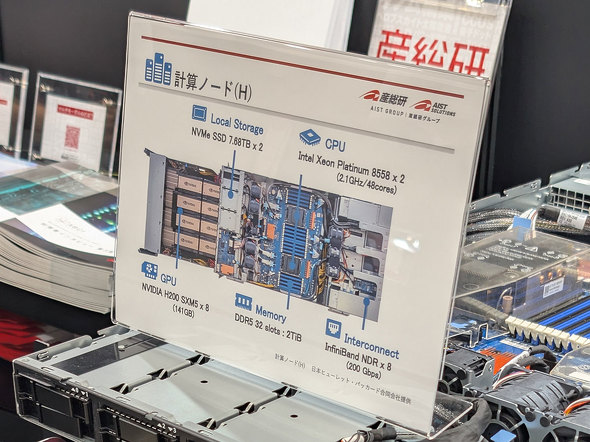

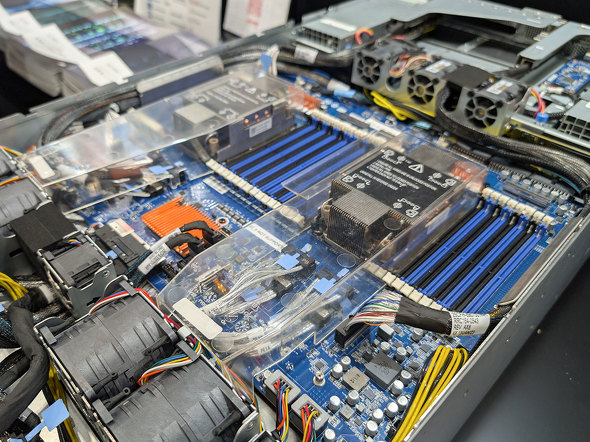

3.0は、これまでの富士通製に代わりHewlett Packard Enterprise(HPE)製を採用。1つのノードに、米Intel Xeon Platinum 8558(48コア)を2基、NVIDIA H200 SXM5(VRAM 141GB)を8基搭載。ストレージは7.68TBのNVMe SSDが2基、メモリはDDR5で2TiB(32スロット)、インターコネクトはInfiniBand NDR(200Gbps)を8基搭載する。ノード数は766(GPUは6128個)で、国内有数の大規模計算基盤となる。なお、H200だけで1台あたり約600万円と言われている。

ABCI 3.0は、24年11月に試験運用を開始し、25年1月に正式提供を予定。ピーク性能は半精度で6.2エクサフロップス(従来比7倍)、単精度で3.0エクサフロップス(従来比13倍)に向上している。また、AI開発がすぐに始められるソフトウェアスタックを備える他、学習済みモデルの再利用などAI開発を容易にする「AI Hub」サービスを提供。Webポータル「Open OnDemand」の導入により、ウェブブラウザからGUIベースで簡単に操作できる環境も提供するという。

関連記事

NTTがAWSのLLM開発支援プログラムに参加 「H100」96基の提供受ける

NTTがAWSのLLM開発支援プログラムに参加 「H100」96基の提供受ける

AWSジャパンが、大規模言語モデル(LLM)の開発支援プログラム「AWS LLM開発支援プログラム」の成果報告会を開催した。これまでは非公開だったが、NTTがプログラムに参加していたことも明らかになった。 AIドリームチーム「Sakana.ai」が人材募集 AWS・GCPや日本産HPCインフラの利用経験があるエンジニアなど 設立者は元Googleトップ研究者ら

AIドリームチーム「Sakana.ai」が人材募集 AWS・GCPや日本産HPCインフラの利用経験があるエンジニアなど 設立者は元Googleトップ研究者ら

元米Googleの著名な研究者、リオン・ジョーンズ氏とデビッド・ハー氏らが東京で立ち上げたAI企業Sakana.ai(東京都港区)が、ITエンジニアやビジネスアナリストといった人材の募集を始めた 「世界トップレベルの大規模言語モデルの開発に着手」──産総研らが表明 目指すのは“GPT-3級の日本語LLM”

「世界トップレベルの大規模言語モデルの開発に着手」──産総研らが表明 目指すのは“GPT-3級の日本語LLM”

「世界トップレベルの大規模言語モデル(LLM)の開発を始める」──産業技術総合研究所は、そんな声明を発表した。 なぜ日本はGPUのない「富岳」でLLMを研究するのか 外国に後れを取らないための“現実的な理由”

なぜ日本はGPUのない「富岳」でLLMを研究するのか 外国に後れを取らないための“現実的な理由”

日本では今、スパコン「富岳」を使ってLLMの研究・開発を進めている。深層学習においてはGPUを使うのが一般的だが、なぜGPUのない富岳を使うのか。そこには現実的な理由があった。 産総研のスパコンで“大規模強化学習” なぜいま「囲碁AI」開発で世界一を目指すのか?

産総研のスパコンで“大規模強化学習” なぜいま「囲碁AI」開発で世界一を目指すのか?

日本発の囲碁AIで世界一を目指すプロジェクトが4月18日に発表された。AIが人間のトップ棋士を超える実力を持って久しいが、なぜいまこのような挑戦をするのだろうか。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.