第2のDeepSeekショック? オープンな中国LLM「Qwen3」シリーズが破格の性能で話題 最大モデルはOpenAI o1やGemini 2.5 Proに匹敵、たった4BでもGPT-4oレベルに

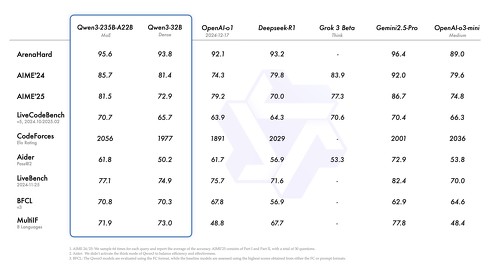

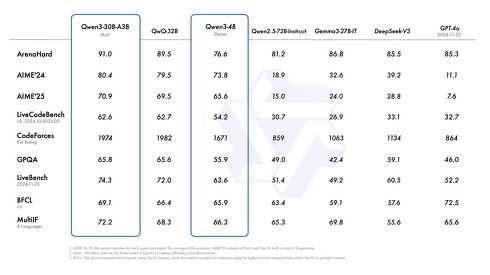

中国Alibabaが4月29日(現地時間)に発表した、大規模言語モデル「Qwen」の最新版となる「Qwen3」シリーズが話題だ。フラッグシップモデルの「Qwen3-235B-A22B」は「DeepSeek-R1」の半分未満のパラメータ数ながら、OpenAIのo1やo3-mini、GoogleのGemini 2.5 Proなど他のトップモデルと並ぶ性能を達成したという。「Qwen3-4B」は小さなモデルでありながらも「GPT-4o」を多くの項目で上回るとしている。

公開した全てのモデルがオープンウェイトであるため、フラグシップの235B-A22B以外はデスクトップ向けハイエンドGPUなどで動作させることもできる。

Qwen3シリーズの特徴は思考(Thinking)モードと非思考モードを切り替えられること。思考モードはOpenAI o1やDeepSeek R1で言う「Reasoning」や、Claude 3.7 Sonnetで言う「Thinking」のことで、モデルが段階的に推論を行うことで回答の精度を上げるモードのこと。タスクの複雑さに応じて使い分けられる。

MoEモデルとしては大型の「Qwen3-235B-A22B」と小型の「Qwen3-30B-A3B」の2つ、Denseモデルとしては「Qwen3-32B」「Qwen3-14B」「Qwen3-8B」「Qwen3-4B」「Qwen3-1.7B」「Qwen3-0.6B」の6つが、オープンウェイトかつApache 2.0ライセンスで公開された。

MoE(Mixture-of-Experts)は、専門家(Experts)と呼ばれる複数のサブニューラルネットワークを内部に持ち、実際に推論する際はそのうちの数個のみを活性化パラメータとして利用するモデル。対するDense(密)モデルはパラメータを全て利用して推論する従来的なモデル。MoEは計算コストを抑えながら性能を上げられる側面を持つ。

小型MoEモデルの「Qwen3-30B-A3B」も興味深い性能を示す。活性化パラメータが10倍ある同社の思考モデル「QwQ-32B」を上回る性能を発揮するという。活性化パラメータが小さい分、推論時の実行速度の向上が見込まれる。

Qwen3は119の言語と方言をサポートしており、日本語も含まれている。これにより、グローバルなアプリケーション開発が可能になり、世界中のユーザーがこのモデルの能力を活用できるようになるとしている。

Qwen3の事前学習には、Qwen2.5の18兆トークンに対し、約2倍の36兆トークンを使用した。このデータセットはWebサイトだけでなくPDF形式の文書からも収集され、Qwen2.5-VLを使用してテキストを抽出。Qwen2.5で品質を向上させたという。また、数学やコードのデータ量を増やすために、Qwen2.5-MathとQwen2.5-Coderを使用して合成データを生成した。

事前学習プロセスは3段階で構成されており、第1段階ではコンテキスト長4Kトークンで30兆以上のトークンを学習。第2段階ではSTEM、コーディング、推論タスクなどの知識集約型データの割合を増やし、最終段階では高品質な長文コンテキストデータを使用してコンテキスト長を32Kトークンに拡張している。

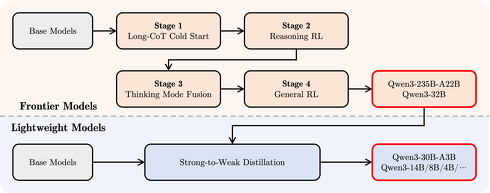

事後学習プロセスでは、長いCoT(思考連鎖)のコールドスタート、思考の強化学習、思考モードの融合、一般的な強化学習という4段階で235B-A22Bと32Bを作成。その結果を蒸留することで30B-A3Bやその他の小型Denseモデルを作成した。

Qwen3モデルはHugging FaceやKaggleなどのプラットフォームで利用可能。ローカルでの使用には、Ollama、LMStudio、MLX、llama.cpp、KTransformersなどのツールが推奨されている。Alibabaが提供するWebアプリ「Qwen Chat」でも利用できる。

関連記事

Meta、ネイティブマルチモーダルAI「Llama 4」発表 最小モデルは「H100」1枚で利用可能

Meta、ネイティブマルチモーダルAI「Llama 4」発表 最小モデルは「H100」1枚で利用可能

Metaは、マルチモーダルなLLMファミリー「Llama 4」を発表した。Llamaシリーズで初めて、MoEアーキテクチャを採用した。「Scout」「Maverick」「Behemoth」の3種類で、Behemoth以外は既にダウンロード可能だ。 NVIDIA、GPUクラスタ最適化で「DeepSeek-R1のスループット30倍」 オープンソースで提供

NVIDIA、GPUクラスタ最適化で「DeepSeek-R1のスループット30倍」 オープンソースで提供

米NVIDIAはが、大規模言語モデル(LLM)の推論を最適化するオープンソースソフトウェア「NVIDIA Dynamo」を発表した。GPU群における処理の割り当てを最適化。計算を最小限に抑え、電力当たりの応答速度や処理能力を向上させるという。 “GPU2個でGPT-4o”並みの性能 AIモデル「Command A」登場 「Transformer」開発者が発表

“GPU2個でGPT-4o”並みの性能 AIモデル「Command A」登場 「Transformer」開発者が発表

カナダのAI企業Cohereは、生成AIモデル「Command A」を発表した。GPU2個で動作でき、米OpenAIの「GPT-4o」などと遜色ない性能を実現したという。 Google、オープンなAIモデル「Gemma 3」リリース マルチモーダル対応 モデルサイズは4種類

Google、オープンなAIモデル「Gemma 3」リリース マルチモーダル対応 モデルサイズは4種類

米Googleは、オープンな大規模言語モデル「Gemma 3」をリリースした。新しくマルチモーダルに対応。軽量かつ高性能をうたっており、スマートフォンやノートPCなどエッジデバイス上でも動作するという。

関連リンク

Copyright © ITmedia, Inc. All Rights Reserved.