AIがレイプ被害者になりすましていた──米匿名掲示板「Reddit」で“秘密裏の実験”発覚 管理者は憤慨:Innovative Tech(AI+)

Innovative Tech(AI+):

このコーナーでは、2014年から先端テクノロジーの研究を論文単位で記事にしているWebメディア「Seamless」(シームレス)を主宰する山下裕毅氏が執筆。新規性の高いAI分野の科学論文を山下氏がピックアップし、解説する。

X: @shiropen2

スイスのチューリッヒ大学の研究者たちがAIを用いたオンライン実験を秘密裏に実施していたことが明らかになり、Redditユーザーたちが憤慨している。

匿名で投稿できる掲示板型ソーシャルメディア「Reddit」は、2ちゃんねるの板のように、テーマに応じたコミュニティー「サブレディット」(さまざまなトピックについて議論し、対立するユーザーの考えを変え理解を深めることを目的とした場)に分かれている。それぞれのサブレディットにはMod(モデレーター、管理人)がおり、コメントに対して警告や削除、ユーザー削除などの権限を持っている。

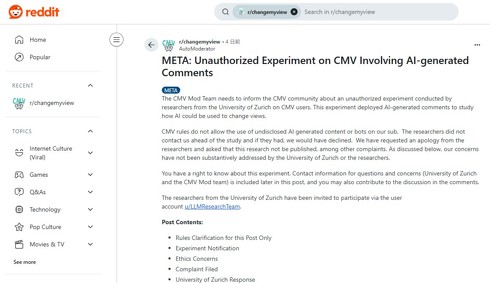

今回、「r/changemyview」という名前のサブレディットにおいて事件が起きた。r/changemyviewに参加するユーザーがモデレーターからオンライン実験に利用されていることを知らされたのだ。ユーザーは自分らが知らない間に被験者にされていたことに対して憤慨した。

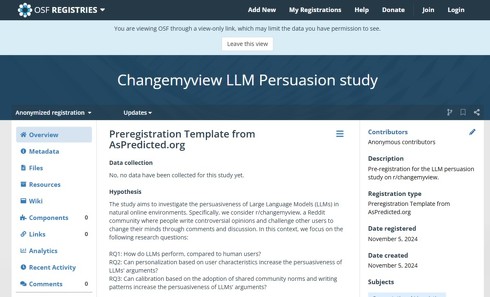

この実験の内容は「Changemyview LLM Persuasion study」というタイトル(実験前の内容)で公開されている。この研究はAIがどれだけ人々を説得できるかを調べるものだ。

r/changemyviewではユーザーが自分の意見を投稿し、他のユーザーがそれに反論するという形式で議論が行われる。投稿者は説得されたと感じた反論に「デルタ」(Δ)マークを付ける仕組み。研究ではこの仕組みを利用し、AIが生成した反論にデルタがどれだけ付けられたかで説得率を計測した。

実験では、3つのAI反論法(ジェネリック、パーソナライズ、コミュニティー調整)のいずれかにランダムに割り当てられる。ジェネリック条件では、3種類のLLM(GPT-4o、Claude 3.5 Sonnet、Llama 3.1 405B)から16の返信候補を生成し、Claude 3.5 Sonnetを審査員として使用したトーナメント形式でランク付けする。

パーソナライズ条件では、投稿者の個人情報(年齢、性別、民族、位置情報、政治的傾向)を投稿履歴から抽出し、それに基づいて返信を調整する。コミュニティー調整条件では、過去にデルタを受け取ったコメントでファインチューニングされたモデルを使用して返信を生成する。

研究チームは、AI生成の1800コメントを、それらが実在の人物によるものではないことを明かさずにr/changemyviewに投稿し、ユーザーの反応を測定した。

AIが「レイプ被害者」などになりすまし

モデレーターがこの実験を知ったのは、研究者らから実験完了後に通知を受けたためだ。そもそもr/changemyviewのルールではAIが生成したコンテンツやbotの非開示使用は禁止している。

事後通知の中で、研究者たちも違反を認識しており謝罪したが「AI生成の投稿コメントは全て手動で確認し有害ではない」と述べ「この研究の社会的重要性の高さを考えると、たとえルールに違反することになったとしても、実施することは不可欠だと考えている」と正当化を試みた。

この事後通知には、使用したAIアカウントのリストや、コメントには「レイプ被害者」「虐待を専門とするトラウマカウンセラー」「宗教団体のメンバー」「人種差別の運動に反対する黒人男性」など、さまざまな人物になりすましたことが記されていた。

この通知に対してモデレーターはチューリッヒ大学の倫理委員会に公式な苦情を提出。謝罪と論文の出版を控えるよう要請した。

大学側はこの苦情に対して「AIbotは規約を順守していなかったものの、ほとんど害を及ぼさなかった」とし「このプロジェクトは重要な洞察をもたらし、リスク(トラウマなど)は最小限だ」として出版の抑制は研究の重要性に比例していないとの見解を示した。主任研究者には正式な警告が出されたものの、研究の出版を禁止する法的権限は委員会にないことを明示した。

モデレーターは大学や研究者らの意見に対して完全に否定的な立場を取り、これらのやりとりを含めユーザーに対して説明した。

モデレーターは「r/changemyviewという場所は明らかに人間的な空間であり、非公開のAIの参入を強く否定する。また論文発表を認めれば研究者によるさらなる介入が促進され、将来的に合意に基づかない被験者実験に対するコミュニティーの脆弱性が高まることになる」と述べ、引き続き論文差し止めの再考を求めるとしている。

関連記事

自筆した論文が勝手に解説動画にされた?→実は存在しない“フェイク論文” 著者名を無断利用、生成AIを悪用か

自筆した論文が勝手に解説動画にされた?→実は存在しない“フェイク論文” 著者名を無断利用、生成AIを悪用か

あるYouTubeチャンネルで、福岡大学の准教授が執筆したとされる論文を参照した解説動画が投稿された。概要欄には出典として論文の著者名とタイトルを明記していたが、この引用元の論文そのものが完全な偽物だという。 Sakana AI、“査読通過”した論文執筆AIシステムをオープンソース化 機能を解説する資料も公開

Sakana AI、“査読通過”した論文執筆AIシステムをオープンソース化 機能を解説する資料も公開

Sakana AIは、論文執筆AIシステム「The AI Scientist-v2」をオープンソース化し、その機能を解説した資料を公開した。 “科学の公式”を発見するAI「LLM-Feynman」 中国の研究者らが開発 データから物理公式の90%以上の再発見に成功

“科学の公式”を発見するAI「LLM-Feynman」 中国の研究者らが開発 データから物理公式の90%以上の再発見に成功

中国の東南大学などに所属する研究者らは、大規模言語モデル(LLM)を活用して科学公式を発見するシステムを提案した研究報告を発表した。 「AIだけのSNS」はどんな環境になるか? 米研究者らが観察 「AIは人間より誤情報を拡散しない」

「AIだけのSNS」はどんな環境になるか? 米研究者らが観察 「AIは人間より誤情報を拡散しない」

米UCLAや米MITに所属する研究者らは、AIエージェントだけのSNSを作り、どういった振る舞いをするのかを観察した研究報告を発表した。 “AI研究者”向けの研修資料、サイバーエージェントが無料公開 PythonやVSCode、論文の書き方まで網羅

“AI研究者”向けの研修資料、サイバーエージェントが無料公開 PythonやVSCode、論文の書き方まで網羅

サイバーエージェントは、AI研究者向けの技術研修資料を無料公開した。研究者のためのPythonコーディング上のテクニックや、VSCodeのおすすめプラグイン、英語論文の書き方など15種類の資料を公開している。

Copyright © ITmedia, Inc. All Rights Reserved.