LLMの“次に来るAI”? NVIDIAが推進する「フィジカルAI」とは何か、識者に聞いた(2/3 ページ)

フィジカルAIの開発方法は?

――フィジカルAIはどのように開発されているのでしょうか

椎橋:面白いのは、先述した第一の層、予測に米OpenAIの動画生成AI「Sora」などで知られる映像生成の技術が使われていることです。1秒後のカメラ映像がどうなるか予測することは、言い換えれば「1秒後の映像を生成する」ということ。だから映像生成の技術がそのまま使える。これを「世界基盤モデル」(World Foundation Model)と呼びます。

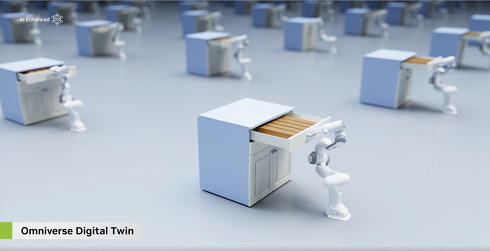

一方、実際の制御の学習には、NVIDIAが提供する「Omniverse」などを活用します。Omniverseは、物理法則に従って動くシミュレーション環境を構築できるプラットフォームです。産業用メタバースとも呼ばれていて、工場のラインや都市環境をバーチャル空間に完全に再現できます。

――なぜわざわざバーチャル空間で学習させるのでしょうか

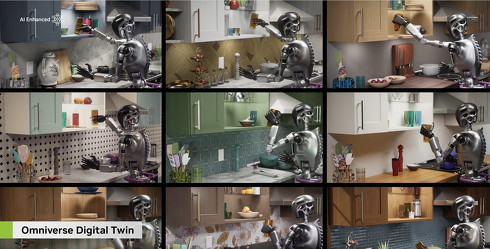

椎橋:ロボットに歩き方を学習させるとき、実際のロボットで何度も転んだり失敗したりさせるのは現実的ではありません。時間もかかりますし、壊れるリスクもある。自動運転も同じで、実際に事故を起こしながら学習させるわけにはいきません。そこで安全なバーチャル空間で練習させるわけです。これを「強化学習」と言います。

簡単に説明すると、AIに何度も試行錯誤させる学習方法です。初めはランダムに動くけど、うまく歩けたら報酬を与え、転んだらペナルティーを与える。何度も繰り返すうちに、AIが自動的に正しい動き方を獲得していく。バーチャル空間なら何度失敗しても大丈夫だし、現実の何倍もの速度で学習できます。

一方で、シミュレーションには限界もあります。例えば、ロボットに洗濯物を畳ませようとすると、どういう問題が起きると思いますか。洗濯物みたいなソフトなものが、どういう風に揺れるか、どう変形するかを、シミュレーターで再現するのは非常に難しい。硬い物体なら物理エンジンで計算できますが、柔らかくて非線形な動きをするものは、バーチャル空間でも正確に再現できません。

だからこそ、最近Teslaが発表した「ゼロショット」、つまりシミュレーションだけで学習させて現実世界で動かせるロボットは、すごい革命といえます。シミュレーションと現実のギャップ、これを「Sim-to-Realギャップ」と呼びますが、これをゼロにできれば開発速度は飛躍的に向上します。

フィジカルAI実現への課題とは

――シミュレーションがそこまで進化しているなら、フィジカルAIは実現できそうな気もします

椎橋:実は、シミュレーションを支える動画生成AIに、大きな課題があります。例えばSoraは、すごくリアルな映像を生成しますが、よく見ると物理法則に従わない変な動きが出てきます。確率的にそれっぽい映像は作れるけど、物理法則を本当に理解しているわけではありません。

これは、LLMのハルシネーションと同じ構造です。学習データにうそが含まれているわけじゃない。正しいデータだけから学習しても、それを確率的に組み合わせて新しいパターンを生成すると、物理法則に反する動きが出てきてしまいます。

自動運転やロボット制御で、物理法則に従わない予測をされたら致命的です。だからフィジカルAIでは、単にきれいな映像を生成するだけじゃなく、物理法則をちゃんと踏まえた正確な予測が必要になります。

どうやって物理法則を守らせるのか。それが今のフィジカルAI研究の最前線です。物理法則の知識と、リアルなデータから学習した結果を、どう組み合わせるかが重要な研究テーマになっています。単純にデータだけから学習するのでも、理論だけでシミュレーションするのでもない、両者を融合させる新しいアプローチが必要です。

――そう考えると、汎用的なヒューマノイドロボットの実現はまだ先でしょうか

椎橋:従来のペースなら10年以上かかるといわれていました。しかし今は、ロボット開発自体にもAIが使われるようになっています。開発スピードが今までとは違う角度から加速する可能性はあります。

例えば、LLMと組み合わせることで、言葉の指示を理解して行動に移すことができるようになってきています。「コーヒーを入れて」という指示を、LLMが「カップを取る」「コーヒーメーカーを操作する」といった動作ごとに分解し、フィジカルAIがそれぞれの動作を実行する。こうした組み合わせで、より汎用的なロボットが実現できる可能性があります。

Copyright © ITmedia, Inc. All Rights Reserved.